- (Обновлено: ) Алина Дрига

Видеозапись вебинара, о том, как улучшить видимость сайта в выдаче за счет правильного составления семантического ядра, презентация и текстовая версия с вопросами слушателей.

Евгений Аралов рассказал, как улучшить видимость сайта в выдаче за счет правильного составления семантического ядра, об эффективных способах сбора и фильтрации ключевых запросов и сложностях, которые могут возникнуть в процессе группировки семантики.

Ниже смотрите видеозапись вебинара, под видео можно скачать презентацию и прочесть текстовую версию вебинара.

Ждем вас на следующих вебинарах!

Видеозапись вебинара (29.04.2015)

Презентация Как создать эффективное семантическое ядро

Текстовое содержание вебинара

Начать я хочу с Минусинска, который Яндекс должен запустить 14 мая – новый алгоритм, который будет банить за использование SEO-ссылок. Это говорит о том, что ссылки уходят, и теперь нам надо более внимательно заниматься внутренней оптимизацией, а она начинается с работы с семантическим ядром.

Можно сказать, что семантика – наше все.

От полноты семантики зависит эффективность всего сайта в будущем (в частности продажи: если на начальном этапе мы правильно соберем семантику, то будем получать трафик: если ошибемся, не поймем спрос – будем терять клиентов и продажи).

Алгоритм подготовки СЯ:

- Формирование маркеров

- Сбор запросов (облако ключевых запросов)

- Чистка и фильтрация

- Группировка

Формирование маркеров

Маркер – запрос, который однозначно отвечает странице. Т.е. если у нас есть категория GPS-навигаторов, то маркером для нее будет запрос «gps-навигатор». Грубо говоря, это слово, которое характеризует страницу.

На начальном этапе важно правильно подобрать эти маркеры, так будет проще собирать полное семантическое ядро.

Где их получать?

— Выгрузка Яндекс.Метрика

— Парсинг своего сайта или конкурента

— Самостоятельно – исходя из логики («мозговой штурм»)

Выгрузка из Яндекс. Метрики – это самый простой способ. Если ваш сайт уже работает, вы можете посмотреть спрос конкретно на ваш сайт. Это удобно – вы сразу знаете посадочную страницу, ориентировочную категорию.

Я рекомендую использовать новую Метрику 2.0 – она удобна тем, что там уже есть готовые отчеты по поисковым фразам + URL. В старой Метрике надо воспользоваться конструктором, чтобы получить отчет.

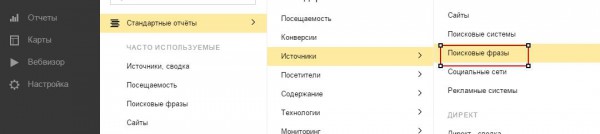

Стандартные отчеты – Источники – Поисковые фразы:

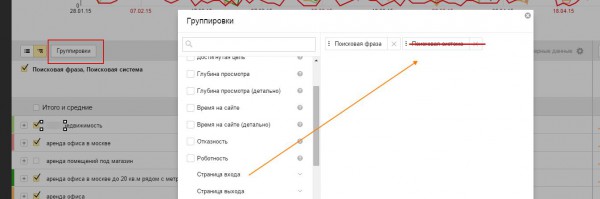

Группировки > Убираем «Поисковые системы» > Вставляем «Страницы входа»:

Группировки > Убираем «Поисковые системы» > Вставляем «Страницы входа»:

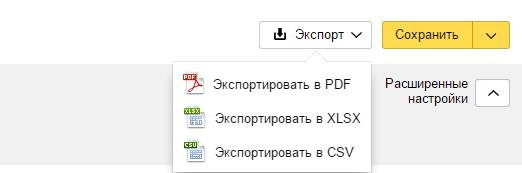

После этого нам все надо выгрузить в Excel, справа вверху есть кнопка «Экспорт»:

После этого нам все надо выгрузить в Excel, справа вверху есть кнопка «Экспорт»:

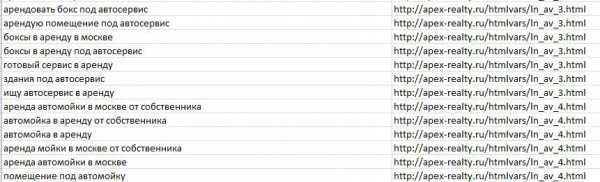

Они уже являются маркерами, под них мы будем подбирать уточняющие слова.

Они уже являются маркерами, под них мы будем подбирать уточняющие слова.

Парсинг. Мы можем парсить title по разделам своего сайта или конкурента.

Чем парсить – программа Netpeak Spider, SEO Screaming Frog (платная).

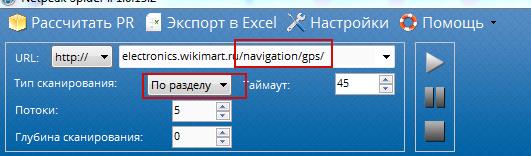

Берем раздел, вставляем, выбираем «По разделу» и нажимаем Play:

В итоге мы получаем title вех этих разделов, после того, как мы получили выгрузку, загружаем все эти данные в Excel.

В итоге мы получаем title вех этих разделов, после того, как мы получили выгрузку, загружаем все эти данные в Excel.

Теперь эти title нам надо разбить на n-граммы.

N-грамма — ряд слов. Последовательность из двух-трех элементов, часто – биграмма (из двух слов); последовательность из трех элементов называется триграмма и т.д.

Как это сделать? Качаем программу N-Gram Extraction Tools. В папке создаем файл, например, in.txt, в него загружаем наши полученные тайтлы и в командной строке задаем: text2ngram – n3 in.txt > out.txt,

где n3 – тип n-граммы (в данном примере это триграмма), in.txt – входной файл с фразами, out.txt – исходный файл с полученными n-граммами и частотным словарем.

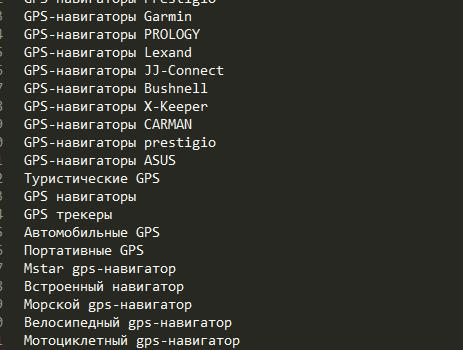

После чистки от «мусора» мы получаем такой файл:

Конечно, пришлось немного почистить «мусор» вручную, но это не так долго и сложно.

Сбор запросов

Парсим по маркерным словам из разных источников

Инструменты:

Wordstat

+ Полнота, актуальность и доступность

— Часть запросов накручена

Поисковые подсказки

+ Полнота и высокая актуальность

— При парсинге генерируются «мусорные» (фантомные) подсказки: [gps навигатор мотоциклетный аккумулятор]. Когда мы набираем «gps навигатор мотоциклетный», нам подставляется слово «аккумулятор». Это не запрос, и это надо учитывать при чистке.

Сервисы SemRush, SpyWords, Prodvigator (может использоваться для маркерных запросов)

+ Скорость

— Низкая полнота, все они платные

Если вы готовите качественную, полную семантику, не стоит слепо опираться на такие сервисы.

Различные готовые базы

+ Скорость (ничего не парсим, просто делаем выборку)

— Много «мусора» и неактуальность (не понятно, кем и как собрана эта база, прямого отношения к поиску она не имеет)

Пользоваться такими базами стоит только в частных случаях, опираться на них не надо.

В итоге мы получаем такую схему сбора запросов:

Маркеры – Wordstat (левая колонка) – Подсказки*

*Учитывайте геозависимость – в Саратове у вас будут совсем другие подсказки, нежели в Москве

Все это может делать Keycollector либо Slovoeb.

Чистка и фильтрация

1. Чистка по стоп-словам. Надо их искать самому или в паблике. Те, кто занимается составлением семантического ядра, должны иметь свой список стоп-слов. Это могут быть:

- Для коммерческих сайтов: нецелевые топонимы (купить навигатор в Саратове), явно некоммерческие сущности (онлайн, смотреть, скачать, бесплатно), бренды конкурентов и т.д.

- Для каждой тематики отдельно: «ремонт», если услуга ремонта не предоставляется, ios – для магазина навигаторов и т.д.

- Общие для всех сайтов: порно, названия соц.сетей

По стоп-словам чистит Slovoeb и Key Collector.

2. Убираем навигационные запросы ([gps навигатор в эльдорадо], [ресторан у реки]).

Отсеивать руками их достаточно сложно. Есть 2 метода фильтрации:

А. Анализ выдачи по запросам

Гипотеза: если сайт занимает несколько верхних позиций, то запрос навигационный.

Метод: собрать ТОП10 url выдачи Яндекс по запросу, проверить есть ли несколько одинаковых доменов среди полученных url, если да – запрос считаем навигационным.

Реализовать можно через Key Collector – подробно о методике на блоге Игоря Бакалова bakalov.info.

Б. Колдунщик Google

Гипотеза: если по запросу в Google появляется карта – запрос навигационный.

Метод: анализируем выдачу по запросам (нужно писать скрипт либо руками).

Еще один способ – парсить xml-выдачу – если у вас есть возможность написать скрипт, его можно использовать. Яндекс подсвечивает витальные сайты в выдаче, если сайт витальный – запрос навигационный.

Витальный сайт – сайт, наиболее релевантный запросу. Например, по запросу Samsung витальным будет сайт компании Samsung. Яндекс определяет такие сайты и выделяет их, в XML-выдаче мы можем это увидеть.

3. Делим на коммерческие и информационные – самая сложная часть.

ВАЖНО! Нельзя продвигать на одной странице коммерческий и информационный запрос.

Сложность в том, что не всегда очевидно, какой запрос для Яндекса коммерческий, какой – информационный.

Пример:

[раствор для кладки кирпича] – информационный запрос

[смесь для кладки кирпича] – коммерческий запрос

На глаз определить это не получится.

Методы фильтрации

Анализ содержимого страниц конкурентов из ТОП по запросу

Гипотеза:

А) Чем больше в ТОПе коммерческих сайтов, тем больше запрос коммерческий. Т.е. если у нас 3 сайта коммерческих и 7 информационных, то запрос, скорее всего, информационный. И наоборот.

Б) Коммерческий сайт продает товары или услуги => для коммерческого сайта характерно: наличие корзины, информации о доставке и оплате, кнопки «Купить», реквизитов и т.д.

В) Информационный сайт ничего не продает, может содержать рекламные блоки.

Вывод: чем больше документов ТОПа по запросу q содержат сущности, характеризующие коммерческий сайт, тем вероятнее, что запрос q – коммерческий.

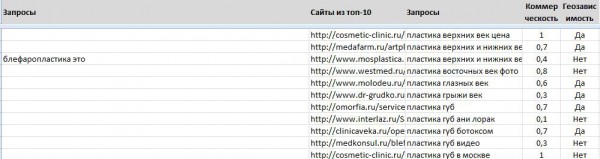

Метод: собрать ТОП10 url выдачи Яндекс по нужному запросу, спарсить контент каждого документа, проанализировать полученное содержимое на наличие коммерческих и информационных сущностей. Если документ коммерческий – присваиваем 1, если информационный – присваиваем 0. Суммируем значения и делим на 10. Получаем ранк коммерционности для запроса.

Инструменты: ZennoPoster или другой парсер, Excel

Методика Игоря Бакалова, подробное описание и пример реализации на сайте bakalov.info

Как конкретно Яндекс определяет, коммерческий запрос или нет, не ясно. Эта методика ориентировочно помогает определить.

Результат:

1 – коммерческий запрос, 0,3 – это уже некоммерческий запрос, 0,7 – больше коммерческий

Группировка

После того, как мы собрали маркеры, подобрали запросы, распределили их на коммерческие и информационные, убрали навигационные запросы, нам надо их разгруппировать.

Как мы группируем?

- По маркерам: категория, категория+бренд, категория+уточняющие слова

- По типу: коммерческий (на коммерческие страницы) или информационный (на информационные)

- По соответствию: специфические сущности контента (отзывы, онлайн, видео, фото) – на отдельные страницы (или на карточках товара)

- По страницам: главная или внутренняя (если по запросу в ТОПе главная страница, то внутреннюю вы туда не продвинете, запрос надо сажать на главную)

Способы группировки:

Ручная (при небольших объемах может использоваться, но начиная с примерно 1000 запросов это долго и, скорее всего, некачественно).

По маркерам. Мы берем, к примеру, маркер «купить» и название категории и группируем все страницы по этим маркерам. Или название категории + бренд.

Ее просто автоматизировать – в Key Collector можно отфильтровывать и группировать запросы по определенным маркерам, что уже увеличивает скорость работы.

Можно написать свои скрипты, но есть некоторые сложности:

gps навигатор navitel

Gps навигаторы навител

gps навигатор navitel A720

gps навигатор navitel A—720

Жпс навигатор navitel

При маркерной группировке нужно учитывать различные словоформы и другие случаи. Если группировать по маркеру «навигатор», то ключевые слова «навигаторы» не сгруппируются. Из-за таких неточностей могут быть пробелы в полноте и правильности группировки.

Сравнение SERP (выдачи). Берем запрос 1, вбиваем его в Яндексе, берем запрос 2, также вбиваем его в Яндексе и смотрим, какие пересечения и насколько их много по этим двум запросам. Если совпадений много: пересекаются страницы, у конкурентов на одних и тех же страницах сидят одни и те же запросы – мы сразу можем группировать эти запросы вместе.

Это лучший вариант, мы сразу убираем вопрос, коммерческий запрос или информационный, поскольку ТОПы нам врать не будут, вряд ли на одной странице будет и коммерческий, и информационный запрос. Скорее всего, будет сразу 2 коммерческих или 2 информационных. Но есть серьезная проблема – автоматизировать этот процесс достаточно сложно. Если у нас большое количество запросов, каждый запрос должен попарно быть почекан и попарно должны быть проверены серпы.

Но однозначно хочу сказать: если вы проверяете вручную, сравнивайте SERPы. Допустим, вы сгруппировали запросы по маркерам – смотрите, пересекаются ли эти запросы по ТОПам.

Это важно, поскольку если вы не будете обращать внимания на ТОП, могут возникнуть трудности:

1. Какой тип страницы: главная или внутренняя. В ТОПе могут быть одни главные, а вы пытаетесь посадить запрос на внутреннюю страницу.

2. По типу: коммерческий или информационный – в ТОПе могут быть одни информационные запросы, хотя этот вопрос мы решаем еще на этапе фильтрации и сортировки.

3. Маркеры: сажают запросы типа [категория+уточняющее слово1] и [категория + уточняющее слово2] на одну страницу.

Пример: [облицовочный кирпич фасадный], [облицовочный кирпич для дома]

Продвинуть их можно, но так делать не надо – это разные страницы для продвижения.

4. Ситуация «Третий лишний».

У нас есть запросы:

[Запрос А]

[Запрос Б]

[Запрос В]

По запросу А и Б есть пересечения в ТОПе, по запросу Б и В – также есть пересечения, а запросы А и В не пересекаются. То есть запрос А и В продвинуть на одной странице нельзя.

5. Синонимы: у Яндекса своя база синонимов. Согласно нашей логике, [уборка в москве] и [клиннинг в москве] – синонимы, а для Яндекса они синонимами не являются. Поэтому посадить их на одну страницу и продвинуть будет сложно – при разработке структуры учитывайте это.

Не бойтесь создавать страницы, конечно, не стоит создавать отдельные страницы под запросы «купить gps навигатор» и «купить gps навигатор дешево», это будет восприниматься как спам.

Подробнее о группировке запросов у нас на блоге.

Вопросы слушателей:

— Сколько информационных запросов можно посадить на страницу?

Сколь угодно много. Можете зайти в Яндекс.Метрику, сделать фильтрацию по одному урлу и посмотреть, сколько запросов ведет на один урл. Нет никаких ограничений, главное, чтобы они были посажены грамотно, соответствовали интенту страницы и были полезны для пользователей

— Где можно посмотреть синонимы?

Синонимы надо парсить, есть модуль «Синонимы по запросам» в seolib.ru.

— Я не понимаю, как все же формировать маркеры? Неужели нельзя просто пробить мозговым штурмом все, что относится к твоей тематике?

Можно, но проще и полнее получится, если вы этот процесс автоматизируете. Но тут есть небольшой нюанс: не стоит подбирать запрос и маркер тех категорий, которые вы не продаете. Это логично, но это не все понимают.

— Перечислите сервисы по группировке семантики, которыми пользуетесь.

В основном это Key Collector и внутренние скрипты. Могу порекомендовать Rush Analytics, https://py7.ru/tools/text/.

— Запрос, в котором присутствует уточнение места, например, «ресторан в Москве» геозависимый или нет?

Нет, не геозависимый, потому что «в Москве» уточняет, скорее всего, из любого региона будет одинаковая выдача.

— Может ли раздел в одной статье быть одинаковым с тайтлом другой статьи? Например, в «Корице» написать общую информацию и кратко про применение в кулинарии и сделать еще одну статью только про применение в кулинарии?

Вопрос такой, риторический, я бы советовал рассматривать его со стороны полезности для пользователя: если обе эти статьи полезны и каждая из них содержит какой-то уникальный интент, то можно писать. Если одно и то же написано разными словами, то это будет восприниматься как спам.

— А для сбора семантики под буржнет чем пользуетесь?

Очень хорошо подходит Semrush.

— Если клиент хочет продвигать запрос, как в примере про кирпич для фасада, но страницу создавать не хочет. Что делать?

Надо убедить его в этом, показать ему ТОП, объяснить, что это бессмысленно. Это как приехал человек на сервис. Ему говоришь: «Надо тебе рулевую тягу делать». А он говорит: «Не, я не хочу, я вот так буду ездить, но вы мне сделайте, чтобы я мог 160 идти по трассе и с машиной ничего не случилось. И еще ответственность несите за это. Давайте с вами договор заключим, что я не разобьюсь». Глупость.

— Так в Google можно вести на 1 страницу коммерческие и информационные запросы?

В некоторых случаях да, можно вести, там нет такого конкретного разделения, как в Яндексе. Все равно также анализируйте ТОП, но это вполне возможно.

— А как с региональными поступить? Создавать 100500 страниц с одним текстом, но разным регионом?

Региональность – это отдельная история. Если коротко: сайт должен быть в Яндекс.Каталоге, он вам позволит присвоить 7 регионов, если у вас есть там представительства. Такая реализация «создать 100500 страниц» возможна, но надо не просто менять город, а делать реально полезный контент для каждого региона.

— А если более 7 регионов?

Это сложнее. Можно подключать поддомены и двигаться по ним, каждому присваивая свой регион. Если у вас нет представительств, то это сложно, в Яндексе с этим достаточно проблематично. Регион «Россия» — это ни о чем в Яндексе. Делайте поддомены, региональный контент, можно даже, чтобы цены отличались. Если это будет явно спам, Яша может и наказать. Простого выхода нет, у вас должны быть представительства или хотя бы пункты вывоза, вы можете добавить в Яндекс.Справочник все эти адреса, это уде улучшит ранжирование по регионам.

— Если тематика узконаправленная то и продвигаться сложнее? Или же наоборот?

Надо смотреть ТОП, если в ТОПе одни прайс-агрегаторы типа Викимарта, Яндекс.Маркета, price.ru и т.д. узкотематическому сайту туда залезть будет нереально, если наоборот – там одни узкотематические сайты, продующие только акустику, к примеру, – скорее всего, туда будет тяжело высокопрофильному сайту залезть.

— Для Гугла теперь ссылки тоже не нужно покупать?

Нужно, но не покупать. Нужно их получать, сегодня это достаточно сложно, мы занимаемся так называемым крауд-маркетингом — есть специалист, который не сидит на биржах, не покупает ссылки, а наращивает естественную ссылочную массу.

Этот способ очень эффективный, но требует много времени. По крауд-маркетингу ждите отдельную статью, будет на нашем блоге в скором времени.

Еще по теме:

- Как почистить сайт от переоптимизации: видео и текст вебинара Как диагностировать фильтр Яндекса за переоптимизацию, выявить основные ошибки на сайте и исправить их. Об этом детально, на примерах рассказал аналитик Никита Простяков - смотрите...

- Мастер-класс: Избавляемся от Панды самостоятельно Причины, признаки и кейсы по выходу из-под Google Panda. Евгений Аралов рассказал, как обнаружить на сайте Панду и избавиться от нее. Просмотрев видеозапись вебинара, вы сможете самостоятельно...

- Какие есть полезные SEO-блоги, сайты и прочие каналы? Можете порекомендовать полезные SEO-блоги, сайты и прочие каналы, которые вы используете, чтобы быть в курсе всех новостей и изменений? Ответ Интернет-блоги: Search engine Journal Ветка...

- Фильтр за накрутку ПФ: как подготовить свой сайт к пересмотру Смотрите видеозапись и презентацию нового вебинара "Фильтр за накрутку ПФ: как подготовить сайт к пересмотру" (провели в среду, 24 июня). Вы узнаете, как диагностировать фильтр за...

- Юзабилити на практике – улучшаем конверсию, позиции и трафик (видео с вебинара) Во время вебинара Владимир Столбов рассказал, как с помощью юзабилити можно улучшить конверсию и трафик интернет-магазина или другого коммерческого сайта. Смотрите видеозапись вебинара, презентацию и текстовое...

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

не могу подписаться а вебинар ошибку выдает :

Системное сообщение

Произошла ошибка: SK120618-01 — Unable to create single msg address. .

Попробуйте повторить операцию. Если это не поможет, сообщите нам об ошибке.

Аркадий, добрый день! Спасибо. что написали, будем решать с сервисом рассылки. Зарегистрировала Вас на вебинар вручную.

спасибо

Подскажите, а когда будет ссылка на сам вебинар, пока не пришло оповешение куда перейти, а он уже скоро начнется 9

Ссылку отправила Вам на почту лично. Должна была уже прийти. Возможно, письмо попало в спам

Не пришло письмо, можете прислать ссылку?

Ссылку на вебинар не дождался 🙁

Ольга, Олег, ссылки Вам выслала лично. Видеозапись и презентацию пришлю на почту завтра, сможете посмотреть, что пропустили.

Здравствуйте. Записаться не успел к сожелению, можно ли где то будет посмотреть запись данного вебинара?

Сергей, здравствуйте! Здесь опубликую запись вебинара, на этой страничке, и продублирую на почту Вам

Мне тоже можно? 🙂 так хотел посмотреть, но не успел.

Здравствуйте, Сергей! Сделаем. Видео будет и на этой страничке тоже

Большое спасибо! 🙂

Добрый вечер! Всем, кто регистрировался на вебинар, отправила на почту запись вебинара и ссылку на презентацию. Тем, кто просил запись в комментариях, также выслала. Если письма нет — проверьте, пожалуйста, в папке спама. Если и там нет — пишите, я отправлю записи вручную.

На следюущей неделе опубликуем видео, презентацию и текстовую версию на этой страничке. Спасибо!

Очень полезный вебинар, большое спасибо!

Подскажите, пожалуйста, нет ли сборки Ngram Extractor Tools для 64 разрядной Windows?

И вам спасибо! Она прекрасно работает на Win x64.

Не могу понять как работать с text2ngram

Через cmd.exe не получается. Сообщается что не является внутренней или внешней программой

Можно пошагово объяснить?

1. Распаковываем на рабочий стол.

2. В распакованной папке в корень добавляем файл с нужными словами (файл с расширением .txt), например, in.txt.

2. Через cmd переходим в папку с распакованной программой, введя следующую команду: cd путь (например, C:\\Desctop\NGRAM), см. ссылку https://joxi.ru/Rmz9qZofWVd8Rr

3. Набираем команду [text2ngram -n2 in.txt > out.txt], где [-n2] — количество n-грамм; in.txt — входной файл; out.txt — выходной файл (см. https://joxi.ru/52a5klBiG0WMw2)

Статья интересная, разбираюсь. Все известно, но структурировано. Если можно обновите ссылку на презентацию (или пришлите), пожалуйста