- (Обновлено: ) Елена Камская

12 февраля на конференции AllintopConf 2014 мы выступили с докладом о ссылочных санкциях Google. Рассказали о промежуточных результатах нашего исследования, посвященного этой теме, и поделились опытом команды SiteClinic по лечению сайтов от ручных санкций и Google Penguin. В этой статье мы поделимся с вами своими наблюдениями за ссылочными фильтрами Google в сопровождении наглядных картинок, взятых из нашей презентации.

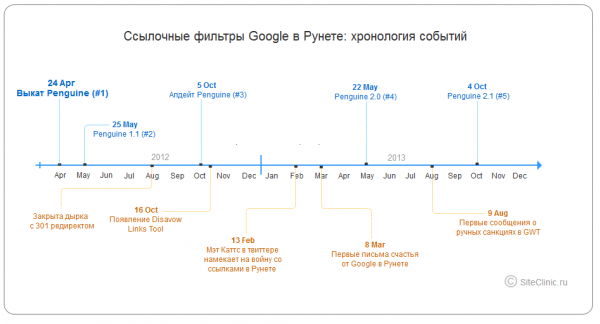

Для начала освежим в памяти хронологию событий. Google начал открытую антиссылочную войну в апреле 2012. Именно тогда появился Google Penguin — фильтр, разработанный для борьбы с искусственными ссылками. Penguin уже пережил одно серьезное обновление и несколько апдейтов базы. Примерно через год после появления Пингвина вебмастера начали получать «Письма счастья» — предупреждения от Google о возможном понижении сайта за злоупотребление искусственными ссылками, а вскоре после этого в Google Webmaster Tools появился раздел «Меры, принятые вручную»:

Penguin или ручной фильтр?

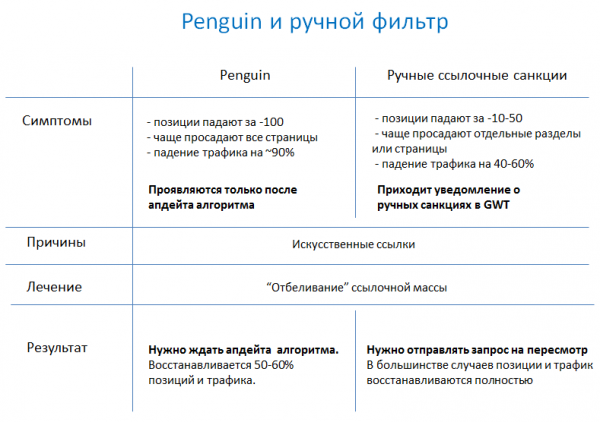

Сейчас в Google есть 2 типа ссылочных санкций: автоматические (алгоритм Penguin) и ручной фильтр.

Основные отличия автоматических и ручных санкций:

В отличие от ссылочных санкций Яндекса, которые проявляются в залипании позиций и поэтому заметны только в динамике, ссылочные фильтры Google диагностировать легко — они всегда сопровождаются резкой потерей трафика. Если при этом в GWT появилось сообщение о применении ручных мер — имеем дело с ручным фильтром. Если сообщения нет, но момент просадки трафика совпадает с датой апдейта Google Penguin — констатируем автоматические санкции.

Не забываем, что один и тот же сайт может одновременно находиться и под Пингвином, и под ручными санкциями, поэтому рекомендуем всегда проверять оба предположения.

Плохой и хороший ссылочный профиль

Предположим, что поисковые системы к оценке ссылочной массы подходят комплексно — оценивается не одна отдельно взятая ссылка, а ссылочный профиль сайта в целом.

Мы решили провести исследование и сравнить ссылочные профили сайтов, которые были понижены в результате ссылочных санкций (назовем их аутсайдерами), и ресурсов, которые стабильно находятся в топах Google по разным запросам (назовем их лидерами). Для исследования брались сайты из внутренней исследовательской базы сервиса Seolib.ru.

Для исследования было выбрано 400 сайтов (200 лидеров, 200 аутсайдеров), для каждой группы собраны ссылки по Ahrefs.com (всего около 380 тыс. ссылок). Ссылочные профили сравнивались по таким группам показателей: качество доноров, спамность анкор-листа, динамика роста ссылок. Исследование планируем закончить к началу лета, а пока готовы поделиться некоторыми промежуточными результатами.

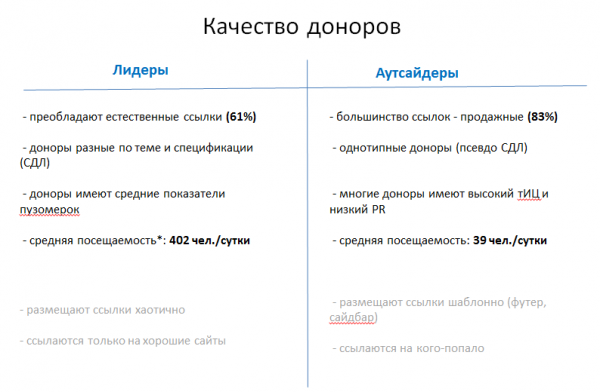

Качество доноров

Выводы касательно разницы в качестве доноров лидеров и аутсайдеров представлены в таблице:

———————————————————-

* Средний показатель по сайтам, у которых окрыт доступ к статистике.

Тезисно об основных наблюдениях по качеству доноров:

— процент площадок, продающих ссылки через Sape, у лидеров в 2 раза меньше (39%), чем у аутсайдеров (83%). Проверить это несложно с помощью White-листов;

— показатель cредней посещаемости у площадок лидеров в 10 раз больше, чем у аутсайдеров;

— среди доноров аутсайдеров есть много доменов с высоким тИЦ (>300) и нулевым значением PR главной страницы;

— возраст: сайтов, моложе 2008 года включительно, среди площадок лидеров — 56%, среди площадок аутсайдеров — 81%.

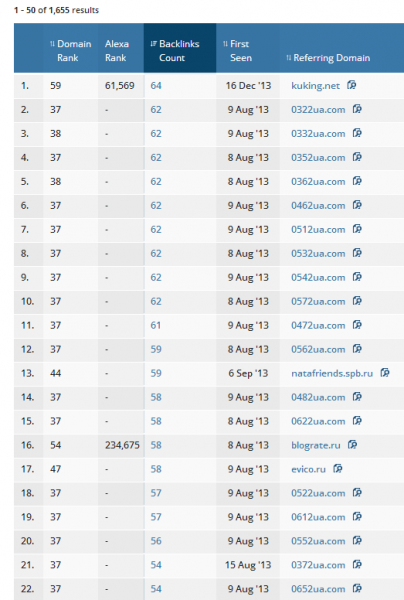

Также ссылочная масса некоторых аутсайдеров очень однотипна, что бросается в глаза даже при беглом анализе доменов или title ссылающихся страниц:

Место размещения ссылки — пока не проверенный, но вполне заслуживающий внимания параметр. Если большинство ссылок расположено в сквозных блоках, это может привлечь дополнительное внимание фильтров.

Еще один интересный показатель, влияние которого пока не доказано — рекомендательный вес. Ссылка с сайта, который ссылается только на авторитетные ресурсы, является более ценной, чем ссылка с сайта, который ссылается на малоизвестные/неавторитетные ресурсы или вообще не содержит ссылок. Подробней об алгоритме рассчета ссылочного веса читайте в Википедии.

Спамность анкор-листа

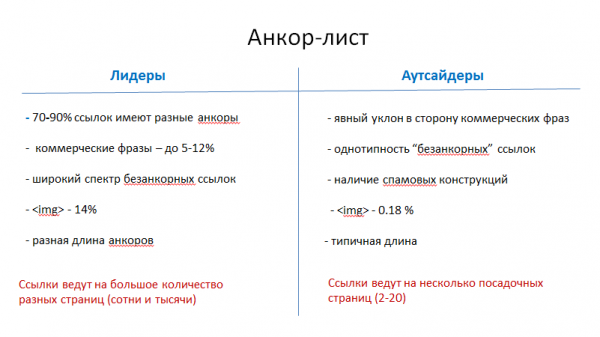

Мы ожидали, что увидим разницу в анкор-листах лидеров и аутсайдеров, но не думали, что она будет такой существенной:

Основные отличия анкор-листов сайтов обеих групп заключаются в следующем:

— содержание коммерческих фраз у аутсайдеров зашкаливает за 60%, в то время как у лидеров такие тексты встречаются только в 5-12% случаев;

— большинство ссылок лидеров имеют анкоры, разные по содержанию, длине, спецификации;

— однотипность анкоров аутсайдеров наблюдается даже для так называемых «безанкорных» ссылок: прослеживается явный уклон в сторону «тут», «здесь» и домена сайта, в то время как большинство «безанкорных» ссылок лидеров являют собой URL внутренних страниц;

— ссылочная масса лидеров содержит 14% ссылок в виде картинок, у аутсайдеров таких ссылок менее 1%;

— средняя длина ссылки лидеров составляет 5,3 слов, аутсайдеров — 2,2 слова.

В процессе анализа — количественный показатель страниц-акцепторов. Выборочный анализ нескольких десятков сайтов показал, что ссылочная масса аутсайдеров сосредоточена, как правило, на 3-10 страницах сайта. То есть видны явные старания оптимизаторов прокачать ссылочным посадочные страницы. Среднее число внутренних страниц, имеющих хотя бы одну входящую ссылку, у лидеров гораздо больше, чем у аутсайдеров.

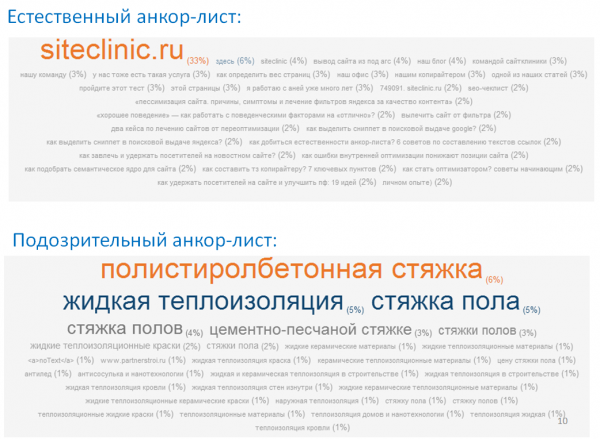

Примеры естественного и спамного анкор-листов:

Этот показатель анализируется вручную, поэтому на данный момент проанализирована только половина сайтов выборки. На текущий момент имеем следующее:

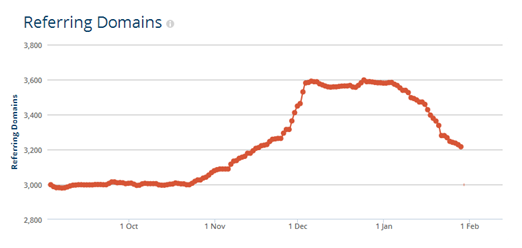

1) Примерно 40% сайтов обеих групп имеют горизонтальные отрезки в динамике роста ссылочной массы:

2) Приблизительно у 35% аутсайдеров в динамике встречаются скачки и падения. Интересно, что у лидеров такая динамика встречается гораздо реже:

Возможно, это связано с тем, что владельцы многих сайтов уже знают о санкциях и чистят ссылочную массу, чтобы снять фильтр.

Возможно, это связано с тем, что владельцы многих сайтов уже знают о санкциях и чистят ссылочную массу, чтобы снять фильтр.

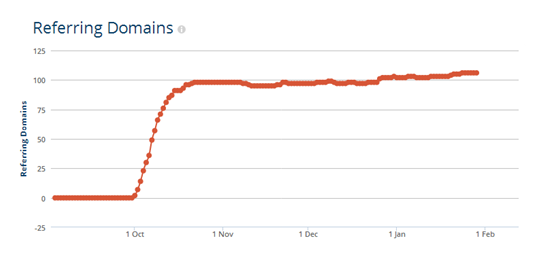

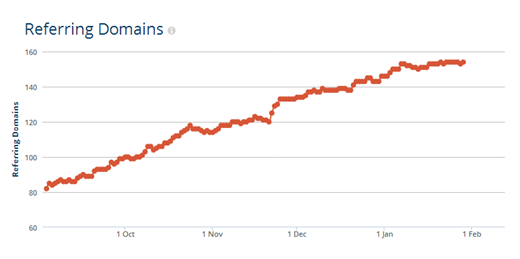

3) Постепенная динамика роста ссылок наблюдается приблизительно у половины лидеров:

Тут есть и небольшие скачки, но они, скорее всего, вызваны естественными факторами. Например, добавлением нового контента или инфоповодами.

Как я уже говорила, мы продолжаем исследование и планируем завершить его в течение 3 месяцев. Если у вас есть идеи по поводу новых исследований, пишите на kamskaya@seolib.ru.

Безопасная стратегия наращивания ссылок

Напоследок — 4 золотых правила наращивания ссылочной массы, которых нужно придерживаться, чтобы не привлекать внимание фильтров:

1) Не арендуйте ссылки

На последнем изображении показано, как выглядит естественная динамика роста ссылок. Чтобы придерживаться такой динамики, ссылочную массу нужно растить постоянно — это непрерывный процесс. Если вы получаете ссылки естественным путем или покупаете с разовой оплатой, поддерживать такую динамику не проблема. Но если вы арендуете ссылки, то ссылочный бюджет придется постоянно повышать: ведь нужно платить и за продление старых ссылок, и за покупку новых. А бюджет, как правило, имеет свои рамки. Не можете обойтись без покупных ссылок — ищите с разовой оплатой.

Кроме того, последние полгода Google ведет открытую войну с европейскими ссылочными биржами. Рано или поздно он доберется и до Рунета — это только вопрос времени.

2) Забудьте о закономерностях

Естественный ссылочный профиль похож на хаос: проследить какие-либо закономерности по текстам, длине, специфике размещения и прочим показателям нереально. Поэтому не старайтесь загнать свою ссылочную стратегию в какие-то рамки, просто делайте свои ссылки максимально разнообразными.

3) Мониторьте ссылочную массу

В нашей практике были случаи наложения ручных санкций Google за ссылки, которыми сайт «забомбили» конкуренты. И хоть официально Google утверждает, что умеет отличать такие ссылки и не учитывает их, на деле все немного не так. Поэтому нужно время от времени выгружать и анализировать ссылочную массу через GWT и Я.Вебмастер — если обнаружите происки конкурентов, успеете вовремя отреагировать.

4) Развивайте свой сайт…

Если ссылочная масса растет, а сайт не развивается и устаревает, теоретически это тоже может показаться подозрительным. Поэтому при работе с внешними факторами никогда нельзя забывать и о внутренних.

Следуйте этим правилам, и ваши сайты будут чувствовать себя отлично при любых алгоритмах Яндекса и Google.

Еще по теме:

- Стоит ли в листинги категорий и тегов добавлять товары, которых сейчас нет в наличии? Стоит ли в листинги категорий и тэгов добавлять товары, которых сейчас нет в наличии. Сейчас реализован вариант, не отражающий товары, которых нет в наличии. При...

- «Бессылочный» аудит сайта — готов ли Ваш магазин к отключению ссылочного ранжирования? Несколько дней назад, во время своего выступления на IBC Russia 2013, руководитель отдела веб-поиска Яндекса Александр Садовский шокировал всех оптимизаторов: в начале следующего года коммерческие...

- «Хорошее поведение» — как работать с поведенческими факторами на «отлично»? Поведенческие факторы оказывают весомое влияние на процесс ранжирования сайта в выдаче основных поисковых систем. Сегодня мы поговорим о том, как можно улучшить поведенческие показатели сайта....

- Насколько важна уникальность текстов для организационно-правовых страниц сайта? Насколько важна уникальность текста на страницах сайта "Политика конфиденциальности", "Отказ от ответственности", "Защита данных" и пр.? И как сделать эти страницы уникальными? Ответ Для данного...

- Турбо-страницы Яндекса: зачем нужны, как создать и подключить 22 ноября 2017 года Яндекс объявил о запуске Турбо-страниц в своём блоге. С тех пор прошло полгода, и я решил собрать всю актуальную информацию о них....

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

(5 оценок, среднее: 4,20 из 5)

(5 оценок, среднее: 4,20 из 5)

на скриншоте в донорах засветился blograte.ru — это качественный донор? 😉

Отличное исследование. Ждём продолжение. А анализ источников планируется? Имеется в виду форумы, блоги, соц.сети, каталоги и пр.

Уточните про "ресурсов, которые стабильно находятся в топах Google по разным запросам (назовем их лидерами)". Интересует следующий момент — это просто сайты из выдачи, которые занимают хорошие позиции и/или имеют трафик, или для анализируемых лидеров у вас есть доступы в GWT и там нет ручных санкций (в том числе "частичных совпадений")?

Дим, blograte.ru засветился в профиле аутсайдера. Как он туда попал не знаю, так как конкретно этот аутсайдер не являетс блогом. А качественный он как площадка или нет не могу — точечно его не оценивала =)

>Bakalov В выборку лидеров попали сайты с широкой семантикой, покрывающей большинство разделов. Доступы к GWT есть, увы, далеко не ко всем. У тех, что есть, ручные санкции не применялись.

Ну а если предположим, есть сайт — лидер своей отрасли, профиль ссылочный — явно спамный — прямые вхождения-однословники. Но в панели гугла до сих пор нет никаких предупреждений, и за счет ссылочного он даже подрос в выдаче гугла. Стоит ли чистить от некачесвенных ссылок через dissalow links? Вроде и пока не нашел гугл, а начать — значить сознаться перед ним, что ссылки спамные…

Сергей, все зависит от текущих позиций — если есть что терять, нужно действовать осторожно. Использование Disavow для топового сайта вряд ли привлечет внимание фильтра, но за счет снижение веса ссылочного профиля может привести к просадке позиций и трафика. Если проблема сугубо в переспаме анкор-листа, а сами доноры качественные, лучше просто аккуратно разбавлять старые анкоры + при дальнейшем наращивании ссылок делать упор на естественные тексты. Это снизит риски наложения фильтра в Google и не приведет к падению в Яндексе (в некоторых случаях чистка анкоров даже помогает сдвинуть "залипание").

Спасибо за ценную информацию Елена. У меня как раз возник вопрос на тему что делать если узнал про наращивание ссылочной массы спустя 2 года после создания и совершенствования ресурса и своих навыков?) ссылок уже накупил непонятных, конкуренты уже забомбили и т.д…. есть подозрения что seo у меня не движется именно из-за ссылочного профиля.

Что делать когда много говноссылок и трафика нет, но внутренняя оптимизация вроде ничего?)