- (Обновлено: ) Евгений

- 7 минут

- Мануал

Техническое состояние сайта — это важный фактор, который влияет на продвижение сайта и его позиции в поисковой выдаче. Своевременное устранение технических ошибок позволяет избежать просадки и временной утраты целевого трафика.

Первый этап технического аудита — это сбор информации и данных по техническому состоянию сайта. Вручную это делать очень долго и малоэффективно. Поэтому для этих задач SEO-специалисты используют парсеры сайтов.

Мы используем платные программы, но не всегда в этом есть необходимость. Если вы начинающий специалист или у вас в работе небольшое количество сайтов, то приобретать платные программы не рентабельно. Бесплатные парсеры могут справиться с поставленными задачами ничуть не хуже, чем их платные аналоги. Сегодня мы поговорим об одном из них.

В статье “Обзор ТОП-6 лучших парсеров сайтов” мы кратко упоминали сервис SiteAnalyzer. На тот момент данный инструмент почетно занял первое место среди бесплатных парсеров. С момента написания статьи прошло три года и мы по-прежнему считаем его качественным бесплатным сервисом. Поэтому сегодня мы хотим более детально разобрать обновленный функционал данного инструмента.

Что может SiteAnalyzer?

Парсер выполняет ряд своих основных задач:

- Находит и сканирует все страницы на сайте. При этом можно настроить, какие разделы стоит индексировать, а в анализе которых нет необходимости.

- Анализирует важную информацию о странице по типу:

- Код ответа сервера.

- Канонические страницы.

- Время отклика.

- Закрыта ли от индексации страница специальными атрибутами или нет.

- Метатеги и контентное содержимое страниц.

- Отображает полученные данные в удобной табличной форме. Также доступен экспорт данных в Excel и PDF.

К сожалению, при использовании бесплатных сервисов приходится жертвовать чем-то, и у данного инструмента недостатки также имеются:

- Парсер не умеет сканировать JS сайты. Поэтому если вы владелец или SEOшник сайта на скриптах, то данный парсер вам не подойдет.

- Скорость сканирования чуть ниже, чем у платных парсеров. Мы проверили на нескольких сайтах, в среднем, за 20 минут мы получаем данные для сайта в объеме 2500 страниц (средний показатель страниц для большинства сайтов на 10 потоках).

- Парсер умеет находить дубликаты страниц, но не умеет фильтровать дубликаты по метатегам. Практически все сайты имеют одну и ту же проблему с дубликатами шаблонных метатегов и в данном парсере не хватает вкладок “дубликаты title, description и h1”. Да, можно выгрузить данные, отсортировать и с помощью формул гугл таблиц выявить дубли. Но когда сайт крупный это занимает время. Гораздо удобнее одним нажатием на клавишу получать все данные по ошибкам.

- Также заметили, что сервис находит не все страницы на сайте. Проверяли с применением базовых настроек User-agent. Платный парсер “Screaming Frog” нашел 555 страниц, Site Analyzer 546 страниц. Такая же небольшая разница в числе просканированных страниц отмечена и в других тестах. Возможно, при детальной настройке можно получить более точный результат, но на данный момент платные аналоги парсят больше страниц.

Несмотря на эти недостатки, в целом парсер имеет все необходимые функции для seo-специалиста. Кроме того, SiteAnalyzer имеет ряд интересных фишек, которые мы рассмотрим.

Простота в использование инструмента

Для начала работ достаточно скачать инструмент. Очень радует, что нет необходимости в регистрациях и прочих манипуляциях, которые требуют другие бесплатные аналоги.

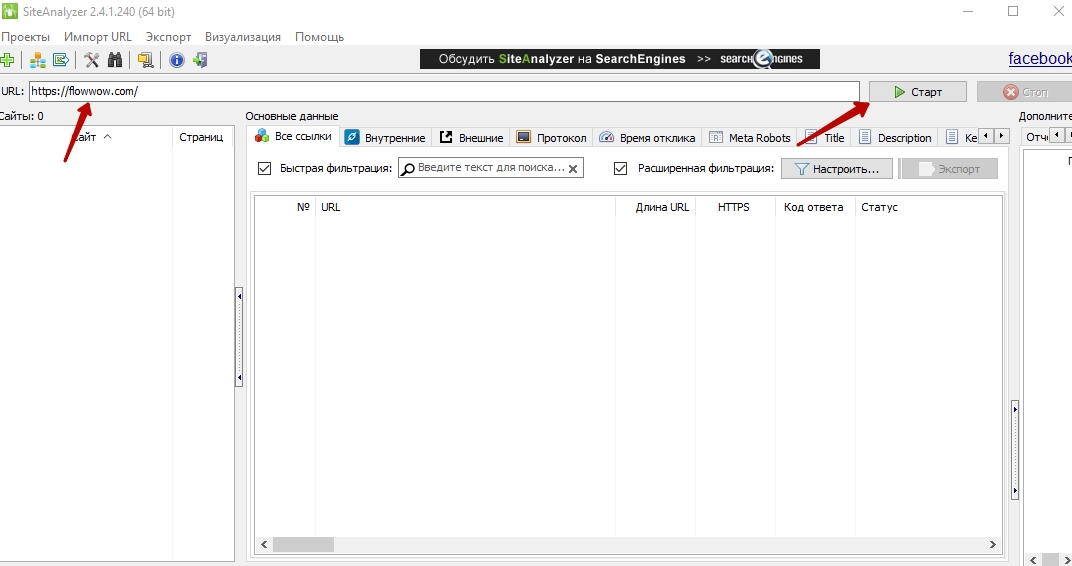

После загрузки необходимо разархивировать содержимое файла в желаемую папку и запустить программу. После запуска вводим домен в строку и при готовности нажимаем на кнопку “Старт”.

Генерация sitemap.xml в один клик

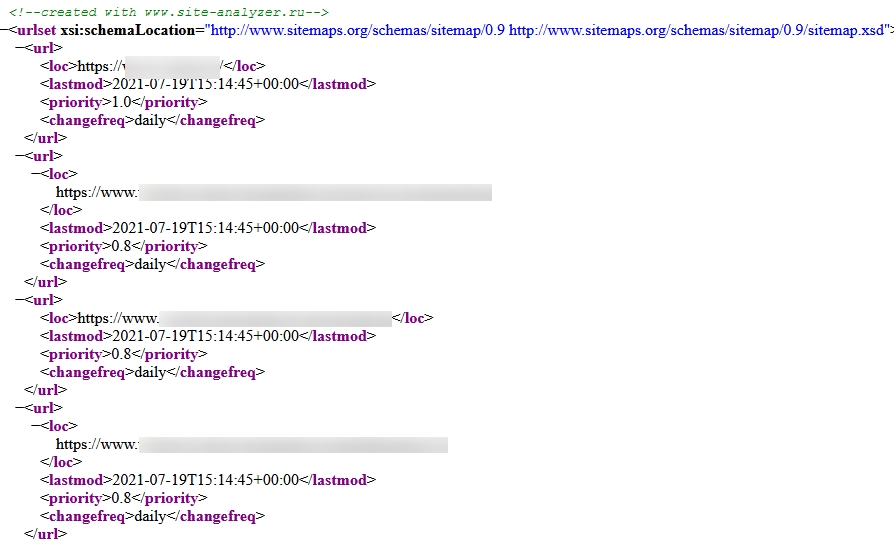

Достаточно удобный и быстрый функционал позволяет создать sitemap.xml за считанные секунды. Кроме того, это не будет простой sitemap с указанием лишь списка ссылок. Sitemap от SiteAnalyzer включает в себя список следующих атрибутов:

- <loc> — обязательный атрибут, который указывает месторасположение страницы (url страницы).

- <lastmod> — необязательный атрибут, который указывает дату последнего изменения страницы. Достаточно удобная штука, для того, чтобы отслеживать периодичность обхода страниц поисковым роботом.

- <changefreq> — вероятная частота изменения этой страницы.

- <priority> — приоритетность URL относительно других URL на Вашем сайте.

Полезность некоторых атрибутов спорная, однако, если программа сама создаст для Вас развернутый sitemap, почему бы не воспользоваться данным функционалом.

Перекрестный анализ сайтов

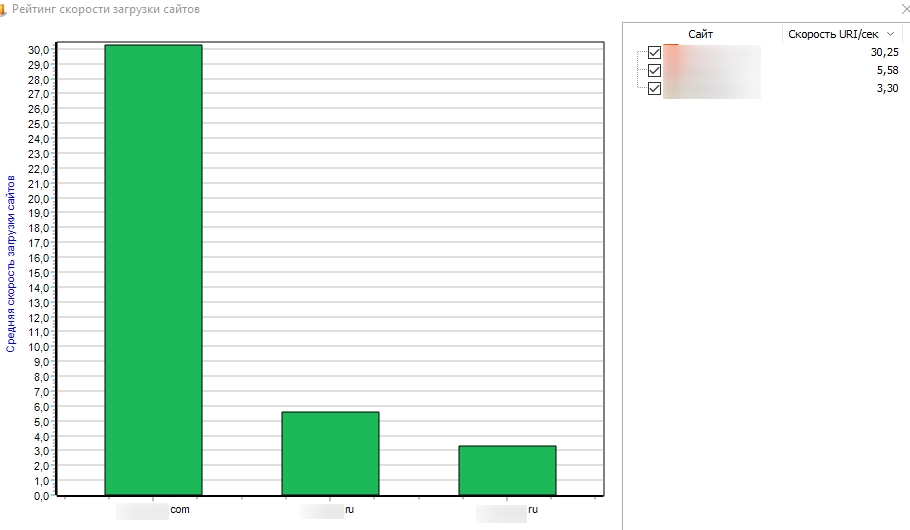

SiteAnalyzer предоставляет уникальную функцию — сканирование нескольких сайтов одновременно и их сравнение. Это дает нам следующие преимущества:

- При парсинге нескольких сайтов мы можем переключаться между проектами без каких-либо перезапусков программы.

- Элементарное сравнение метатегов и другого содержимого на сайте.

- Рейтинг скорости загрузки сайтов. Важно понимать, что инструмент PageSpeed отлично разбирает скорость загрузки отдельных страниц. Но функционал парсера SiteAnalyzer позволит получить общую скорость загрузки сайта и сравнить её с конкурентами.

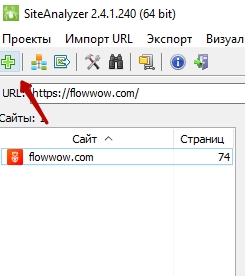

Для запуска сканирования второго сайта не нужно перезапускать парсер. Достаточно нажать на иконку “+” в панели быстрого доступа.

Постраничная скорость загрузки сайта

Кроме общего сравнения скорости между проектами, инструмент ещё показывает “График скорости загрузки отдельных страниц”.

Интересный функционал, который позволит взглянуть на общую картину со скоростью загрузки сайта. Тот же инструмент в GSC не показывает скорость загрузки сайта таким удобным способом. График SiteAnalyzer показывает, сколько страниц имеют определенную скорость загрузки.

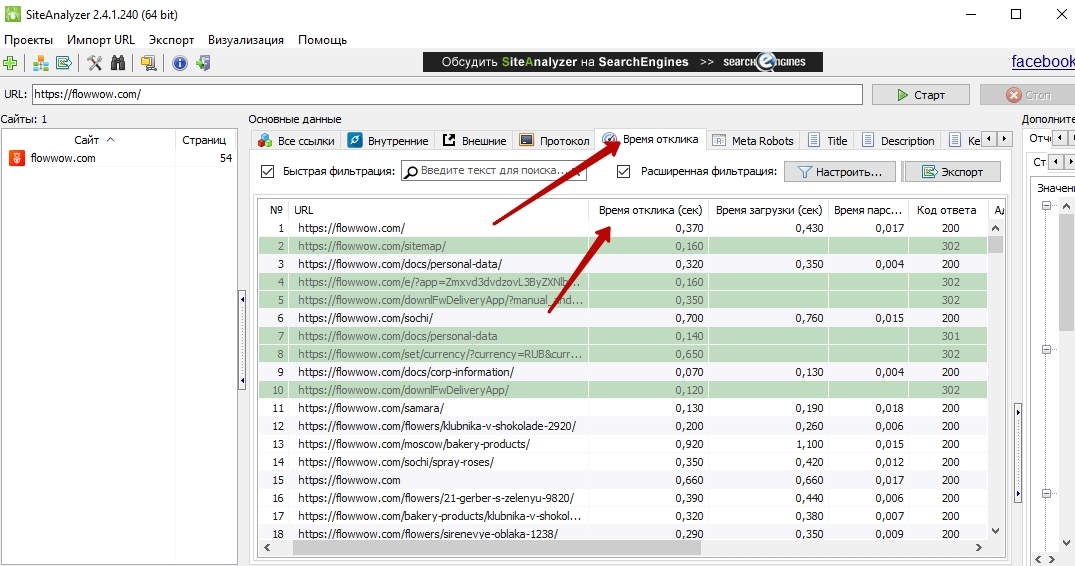

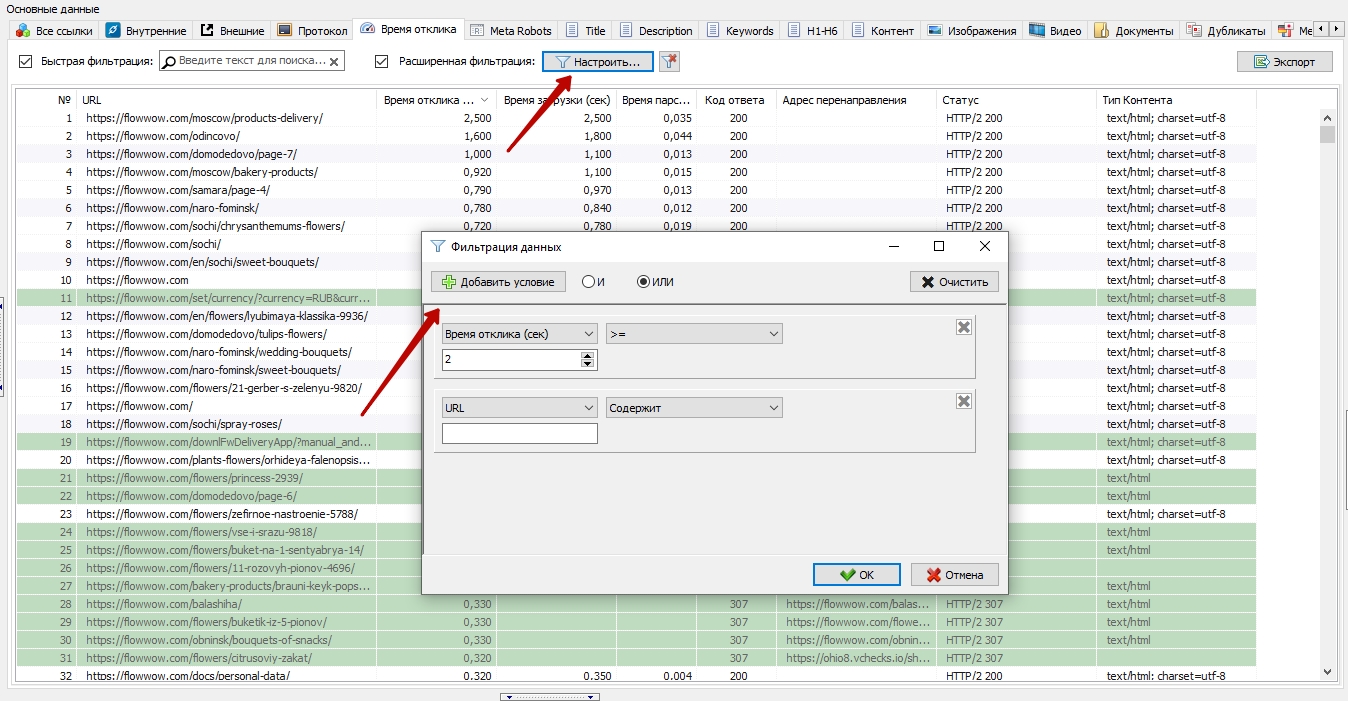

Мы считаем, что это отличная идея, поскольку Вы сразу видите страницы, которые нужно прорабатывать в первую очередь. Чтобы узнать, какие страницы относятся к определенной группе с указанной скоростью загрузки, достаточно перейти во вкладку “Время отклика” и отфильтровать по значению.

Выделение группы страниц со скоростьюотклика более чем 2 секунды.

Однако, намного удобнее было бы сделать активные столбики. Например, нажав на столбик 1,7, нам бы открывался список страниц со скоростью в этом диапазоне. Такая реализация есть у данного парсера в графике распределения ссылок.

Конечно, можно использовать сортировку и фильтрацию, которая в данном сервисе выполнена на 5+, но активные столбики проще и быстрее. Надеемся, разработчики в скором времени внедрят данный функционал.

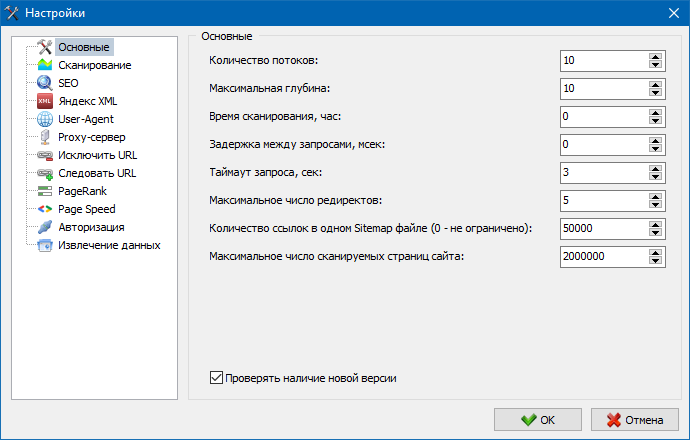

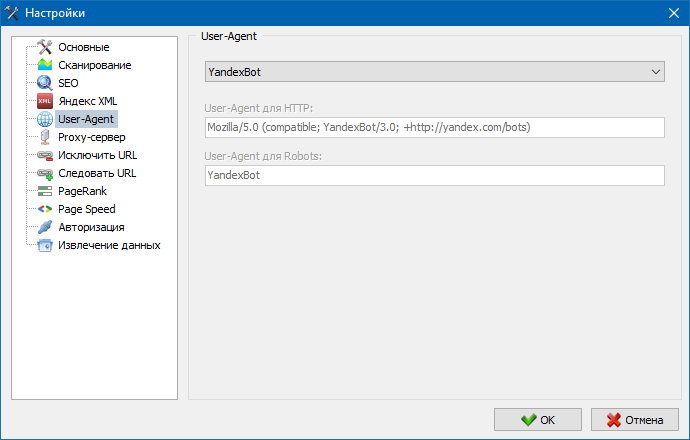

Тонкие настройки парсера

Учитывая, что мы постоянно работаем с достаточно разными сайтами, то есть необходимость в индивидуальной настройке инструмента для сканирования сайта. Бесплатный сервис Site Analyzer настраивает бота для сканирования практически на том же уровне, что и платные инструменты.

Из важного стоит отметить следующие настройки:

- Количество потоков. Выше мы уже упоминали, что мы можем оценить серверную нагрузку своего сайта и конкурентов. Чтобы не допустить проблем с отключением сайта и выгрузить все нужные данные, иногда нужно уменьшать количество потоков.

- Можно выбрать одну из двух формул расчета PageRank (классическую или расширенную).

- Выбор User-Agent. При проведении аудитов мы сканируем сайт с выбором настроек бота интересующей нас поисковой системы и типа устройства (desktop/mobile). К сожалению, мы не нашли в настройках мобильной версии Яндекса.

В целом настройки позволяют подстроить парсер под ваши конкретные цели.

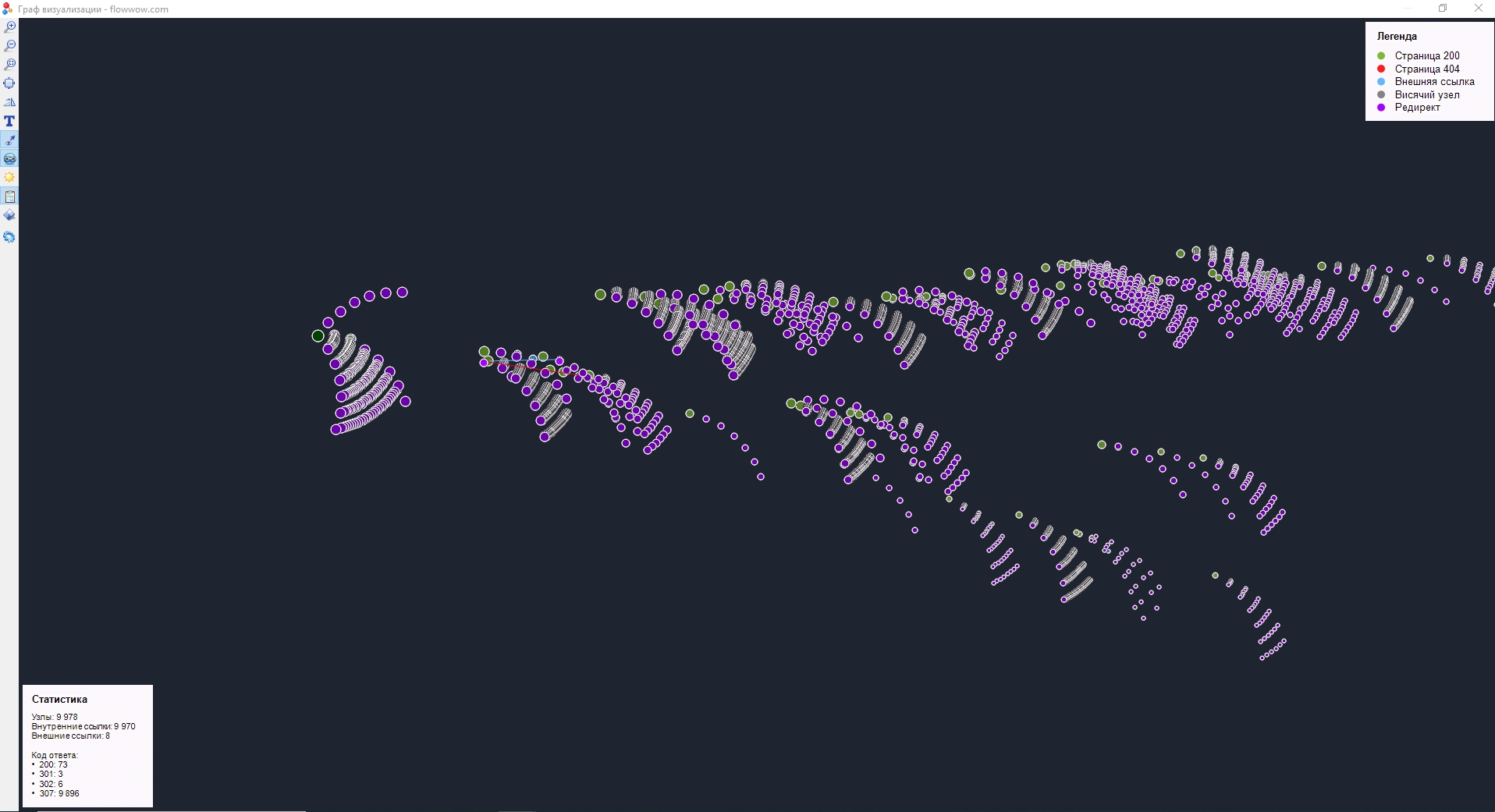

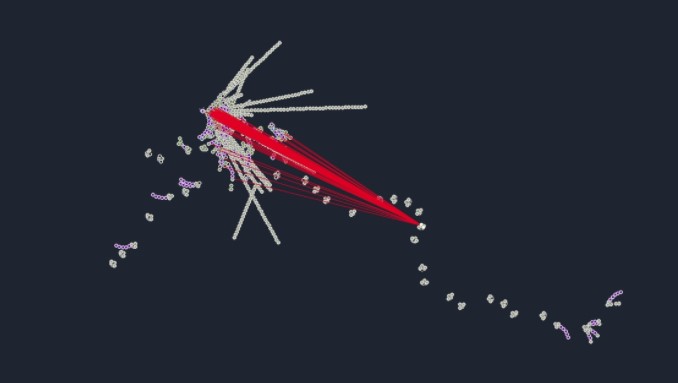

Все ведь любят визуализацию?

После сканирования сайта мы получаем визуализированную структуру сайта со всеми цепочками. Чем глубже страница, тем дальше точка находится от основного скопления.

Данный график масштабируется, также можно активировать вывод url под каждой точкой. Но если у вас крупный сайт, то Вам такой функционал ни к чему.

Выводы

Главное достоинство SiteAnalyzer — это его цена и доступность, он совершенно бесплатный. Это здорово, т.к. инструмент позволяет уменьшить расходы seo специалиста. К примеру, Netpeak Spider подняли цены до 39$ в месяц за Pro аккаунт. Screaming Frog обойдется в £149 за год.

SiteAnalyzer мог бы полностью заменить Netpeak Spider и Screaming Frog, если бы в его функционале появились удобные SEO отчеты о проблемах с сайтом. Такие отчеты значительно экономят время специалиста.

Многие SEO специалисты готовы покупать инструменты (в виде разовой платы за релиз). По такому принципу работает сервис проверки позиций TopSite, инструмент ScrapeBox. Но далеко не все хотят платить за ежемесячную аренду инструмента.

Желаем от SiteAnalyzer дальнейшего развития!

И кто знает, возможно, после обновления мы полностью заменим платные аналоги.

Если у Вас возникли трудности с SEO-анализом Вашего сайта — доверьтесь профессионалам.

Еще по теме:

- Доступны ли к индексации страницы, если лягушка показывает, что они закрыты x-robots-tag? Лягушка не сканирует метатеги и показывает, что страницы закрыты x-robots-tag, но в индексе, если проверять страницы через site: поисковики выдают эти страницы - почему так?...

- Почему по Ahrefs трафик может расти, а ключевые слова падают или наоборот? Сталкивались ли вы с ситуацией, что по ahrefs трафик растет, а ключевые слова падают или наоборот, ключи растут, трафик падает. С чем это связано и...

- Как долго ждать результата от Disavow Tool? Подскажите, как быстро срабатывает Disavow Tool? Как быстро ждать результата от таких действий, может есть какие-то кейсы? Ответ Время, необходимое для того, чтобы Google учел...

- Как в аналитике отделить трафик с АI и АI поиска Google? Подскажите, как в аналитике отделить трафик с АI и с того же АI поиска гугл? Ответ Прямой трафик из AI-чатов (ChatGPT, Perplexity, Claude) обычно попадает...

- Настройка отслеживания e-commerce с помощью Google Tag Manager Мы продолжаем делиться информацией о том, как пользоваться Google Tag Manager для анализа трафика, конверсий и поведения пользователей. Ранее мы рассмотрели следующие способы работы с...

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

Мой опыт использования Фрога и СайтАналайзера показывает, что последний легче (когда он парсит, его почти незаметно, можно нормально работать параллельно), обрабатывает большие проекты быстрее и может с легкостью собрать 100+ К (а с Фрогом в этом отношении бывают нюансы).

Просто личные наблюдения на конкретном железе.

Ну и, конечно, очень удобно что можно просто переключаться между проектами. Особенно актуально, когда работаешь с тестовыми версиями и продом.

Благодарим за отзыв, очень приятно! Будем стараться и дальше развивать софт и добавлять новые фишки.

В СайтАналайзер очень не хватает подключения сторонних сервисов. Например, парсинг Вебмастера или Метрики.

Парсинг метрики только в софте у Алаича видел. Но как понимаю, он на свою прогу забил и занимается другими проектами.

Здравствуйте. Связь с метрикой и аналитикой есть в планах. Не могу сказать что выйдет в ближайших версиях, но кто знает, возможно мы увидим это уже в этом году.

Не соглашусь. Идёте в статистику SEO слева. Там находите Дубликаты Title, Description, H1-H6 и выводите список. Упорядочиваете и всё!

TopSite уже на подписке, насколько я знаю.

Благодарю за интересную и полезную информацию.