- (Обновлено: ) Никита К.

- 15 минут

- Экспертное мнение

Сервисы для проверки уникальности текста

Как влияет уникальность контента на продвижение в разных ПС?

Почему неуникальные статьи попадают в ТОП?

Защита от копирования контента

В данной статье речь пойдёт о важности и влиянии на продвижение такого фактора, как уникальность контента.

На сегодняшний день мнения расходятся: одни считают, что уникальность является чуть ли не панацеей от всех проблем, а другие утверждают, что для поиска важна не уникальность как таковая, а востребованность контента у аудитории. Давайте разбираться по порядку.

Что такое уникальность контента

Уникальность контента — это значимое свойство информационного материала, которое подразумевает размещение контента в интернете один раз. Уникальность является одним из базовых критериев, по которым поисковые системы оценивают качество контента.

Поисковые системы, такие как Яндекс и Google, рекомендуют для качественного SEO-продвижения сайта публиковать только оригинальные статьи и изображения к ним. Обычно сайты с уникальным контентом ранжируются выше в поисковой выдаче, однако бывают и исключения.

Давайте рассмотрим подробнее, из чего же состоит уникальный контент.

Уникальный текст

Текстовая составляющая сайта — это один из главных инструментов его SEO-оптимизации и продвижения. Уникальный текст и статьи создаются при помощи:

- копирайтинга — написания оригинальных текстов на определённую тему;

- рерайтинга — метода, когда за основу берётся готовый текст и полностью переписывается.

Уникальность текста измеряется в процентах и является соотношением объёмов заимствованного и авторского текста. Существует общепринятая шкала:

- 95% — 100% — очень высокий уровень уникальности;

- 90% — 95% — высокий уровень уникальности;

- 80% — 90% — средняя уникальность;

- 79% и ниже — низкий уровень уникальности.

Я обычно требую от копирайтеров уникальности не ниже 90%, так как такие тексты хорошо ценятся поисковиками. Однако информация должна быть не только оригинальной, но и полезной. Тогда появляется вероятность, что эта статья задержится в ТОПе значительно выше.

Далее давайте разберёмся, насколько важна уникальность текста на типовых страницах коммерческих сайтов.

- На таких страницах, как «Главная», «О компании», «Контакты» однозначно должен быть уникальный текст. Сюда входят: уникальное торговое предложение (УТП), преимущества организации, контакты компании (реквизиты, номера телефонов, адрес, email). Всё это должно быть оригинальным и не совпадать с контентом на сайте других компаний, иначе сайт может попасть под фильтр аффилирования.

- В зависимости от специфики и тематики ресурса в карточках товара можно допускать неуникальный текст. К счастью, поисковые системы понимают, что трудно создать действительно уникальный текст — например, для товаров газового оборудования или трубного металлопроката, потому что технические параметры будут повторяться на различных ресурсах. В таких случаях нужно делать упор на дизайне и юзабилити, чтобы добиться высоких позиций.

- По-настоящему уникальность важна в статьях, новостях, обзорах вашего сайта, так как здесь просто скопировать не получится. Одним из вариантов решения может стать указание первоисточника — ссылки на ресурс, с которого была взята информация. Тогда такая статья может занять почётное место в ТОПах, особенно если у сайта-первоисточника хорошие поведенческие факторы.

Также важную роль играет кликабельность в выдаче. Например, если у сайта-первоисточника слабо проработан сниппет, который не привлекает пользователей, а у сайта, скопировавшего страницу, будет хорошо проработан Title, добавлена микроразметка и эмоджи, пользователь соответственно будет переходить не на первоисточник, а на копию. Дополнительно добавляется вес копии, если это последний клик в выдаче (last click). - Полностью неуникальный текст может использоваться в случаях, когда речь идёт об интеллектуальной собственности – например, законах и постановлениях на сайтах юридической тематики, текстах различных книг на онлайн-библиотеках, текстах песен на музыкальных сайтах и т.п.

В остальных случаях текст можно с лёгкостью уникализировать.

Уникальные изображения

На сегодняшний день использование изображений является одним из успешных методов продвижения. Они также являются добавочной ценностью статей. Картинки оживляют текст, делая его более читабельным и усиливая привлекательность страницы.

Сейчас Яндекс и Google могут различать изображения не только по атрибутам тега <img>, но и по самой графике. Они ценят оригинальный контент, так как за счёт этого могут показывать пользователям более разнообразные результаты в выдаче. Уникальные изображения позволяют сайту участвовать в поиске по картинкам и получать дополнительный трафик. Однако помимо наличия авторских изображений нужно дополнительно оптимизировать теги Alt и Title, текст около изображения и саму страницу.

Идеальный вариант — сделать фотографии (нарисовать) самому или нанять штатного фотографа. Если же такой возможности нет, можно найти картинки через поиск или на фотобанках, а потом уникализировать их с помощью графических редакторов.

Помогут такие приёмы:

- зеркальное отображение;

- поворот на несколько градусов;

- кадрирование;

- применение различных графических фильтров.

Уникальный дизайн

Если же вы решили воспользоваться шаблонным дизайном, чтобы сэкономить время и средства, будьте готовы к тому, что ещё несколько, а то и десятки сайтов в интернете имеют точно такой же дизайн. Естественно, такой дизайн будет не очень хорошо восприниматься поисковыми системами.

Также перечислю ещё пару минусов использования шаблонного дизайна:

- Это может негативно отразиться на поведенческих факторах. Если пользователи увидят сайт с одинаковым дизайном, они могут посчитать его вторичным, не заслуживающим должного внимания и просто покинут его.

- У большинства шаблонных сайтов сложно или невозможно вносить существенные изменения в дизайн – такие как перемещение блоков, виджетов, меню и других элементов.

- Также значительным минусом является то, что создатели бесплатных шаблонов зачастую вшивают в код страницы скрытые или сквозные ссылки, из-за которых будет переливаться вес с вашего сайта на сайт создателя. Также за счёт таких ссылок он получит множество переходов по реферальной ссылке, которые будут приносить ему прибыль.

В целом сайты с шаблонным дизайном могут ранжироваться на уровне с сайтами, имеющими уникальный дизайн, однако конкурировать за место в ТОПе значительно тяжелее.

Если вы хотите добиться серьёзных результатов, важно создать для своего веб-сайта дизайн, который будет отличать его от конкурентов. Если дизайн вашего сайта будет полностью совпадать с другим ресурсом, то есть риск попасть под аффилирование. Также на вас может пожаловаться владелец сайта-двойника. Не стоит копировать успешные решения, даже если они вам очень понравились.

Хорошее внешнее оформление – это уникальный дизайн. Нужно постоянно искать новые, интересные и необычные решения UI/UX – это высоко оценится как пользователями, так и поисковыми системами.

Многие под дизайном подразумевают структуру. Однако для интернет-магазина создать абсолютно уникальную структуру будет сложно. Тут лучше следить за удобством пользователей. При создании интернет-магазина выбирайте шаблон с правильной структурой и наполняйте его уникальным контентом.

Сервисы для проверки уникальности текста

Давайте кратко рассмотрим 3 топовых сервиса для проверки уникальности текста, которые используем мы.

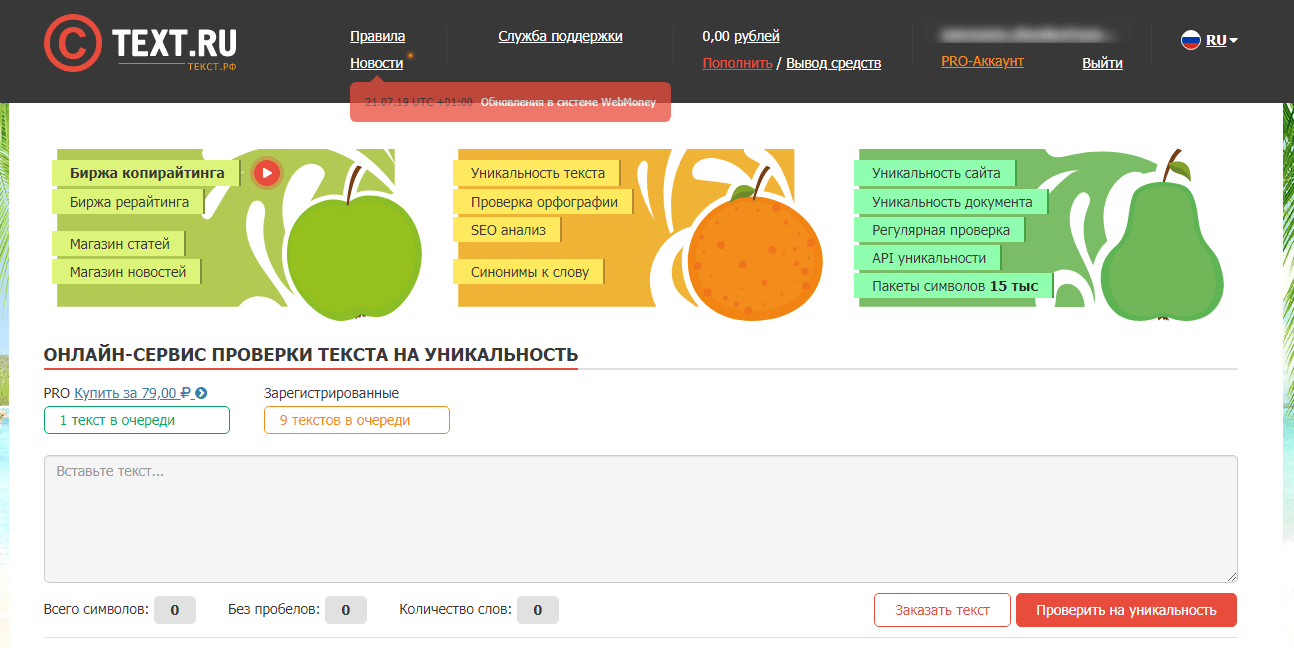

Сервис бесплатной онлайн-проверки текста покажет процент уникальности текста, а также найдёт дубликаты и рерайт. Дополнительно проверяет орфографию и выполняет SEO-анализ текста (количество символов с пробелами и без них, количество слов, проценты заспамленности и воды).

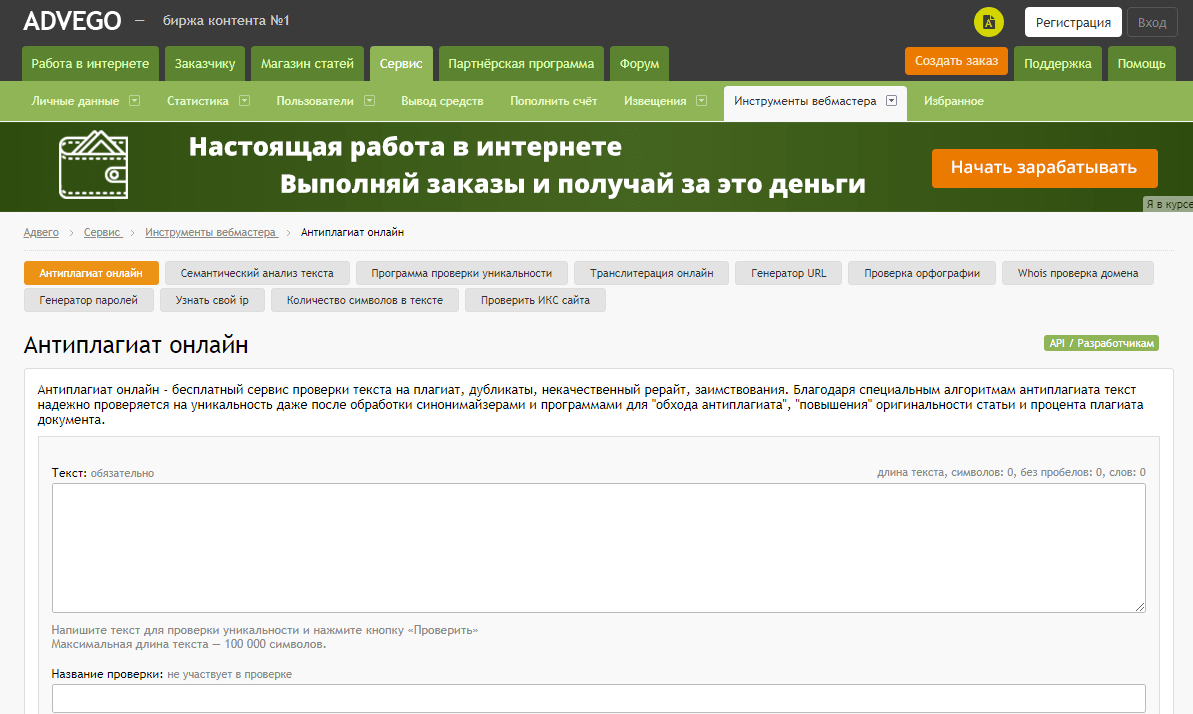

Данный сервис проверяет тексты на уникальность по алгоритмам шинглов, лексических совпадений и псевдоуникализации. На сайте Advego пользователям доступны:

- бесплатный SEO-анализ текста (плотность ключевых слов, частотность, стоп-слова, водность, классическая и академическая тошнота, грамматические ошибки);

- сервисы проверки орфографии, онлайн-транслитерации;

- генератор URL.

Есть как онлайн-версия, так и десктопная версия.

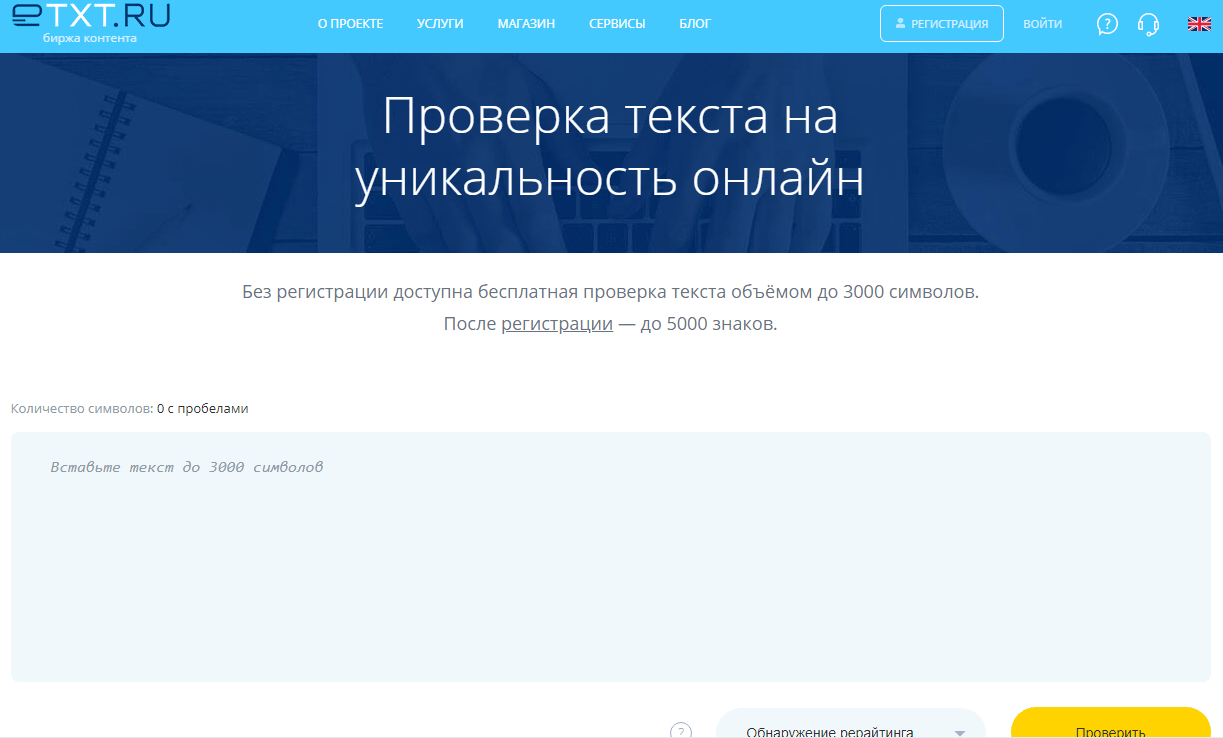

В данном сервисе есть возможность проверить тексты на уникальность. Незарегистрированные пользователи могут бесплатно проверять тексты длиной до 3 тысяч символов, зарегистрированные – до 15 тысяч. Есть разные типы проверок: глубокая проверка, экспресс-проверка. Что интересно, есть проверка картинок и другие функции. Для проверки большого количества текстов команда eTXT готова предоставить пользователю отдельный сервис (взимается абонентская плата).

Есть три вида программы:

- десктопная версия (бесплатно);

- онлайн-версия (1,5 руб. за 1000 символов);

- API (абонентская плата — 3000 руб./месяц).

Как влияет уникальность контента на продвижение в разных ПС?

Можно с уверенностью сказать, что к копипасту Google и Яндекс относятся отрицательно. Однако, как показывает практика, Google больше ценит релевантность и то, насколько решается задача пользователя, поэтому контент с низкой уникальностью может спокойно ранжироваться в ТОПе.

В Яндексе же низкая уникальность контента может привести к удалению страниц из индекса, а если неуникальный контент обнаруживается на большинстве страницах сайта, это может привести к пессимизации сайта, то есть понижению его позиций в поисковой выдаче.

Почему неуникальные статьи попадают в ТОП?

У меня есть 2 версии того, почему так происходит:

- «Многорукий бандит» может помочь неуникальным статьям попасть в ТОП Яндекса. Данный алгоритм поднимает новые сайты в ТОП, оценивает их поведенческие факторы и принимает решение, достоин ли сайт быть в ТОПе. Попасть в ТОП нетрудно — трудно там удержаться. И здесь на помощь приходят поведенческие факторы и last click, о которых упомянул выше.

- Сейчас достаточно много тематик, в которых не то чтобы трудно, а невозможно создать уникальные статьи. Например, это тексты законов, судебных решений, юридических формулировок и т.п. Также к таким видам относятся онлайн-библиотеки, тексты песен и различная справочная информация, которая является неизменной.

В таких случаях в бой вступают поведенческие факторы. Если пользователь перешёл на сайт и не вернулся в выдачу, значит, он нашёл, что искал. Вывод: сайт интересный и в полной мере отвечает на запрос пользователя, поэтому ПС будут оставлять их в ТОПе. В интернете содержится очень много хорошего контента, но мало просто написать хорошую статью — её нужно хорошо представить пользователю.

Защита от копирования контента

Давайте поговорим о том, как обезопасить веб-сайт от копирования контента. Начнём сразу с плохих новостей: полностью обезопасить себя от копирования контента невозможно, но можно усложнить недоброжелателям этот процесс.

1) Если вы заметили, что ваш контент воруют, необходимо в первую очередь посмотреть, чей контент появляется раньше в индексе поисковых систем.

В случае если ваш сайт индексируется позже, необходимо принять меры к ускорению индексации.

Индексацию можно улучшить следующими способами:

- Автоматически добавлять созданные страницы в sitemap.

- Вывести на сайте сквозные блоки со ссылками на новые статьи.

- Отправлять новые статьи на индексацию:

- в Яндекс.Вебмастере это вкладка «Переобход» (раздел «Индексирование»);

- в Google Search Console – заходим в «Проверить URL» и проверяем адрес, потом нажимаем на кнопку «Запросить индексирование».

- Настроить заголовки Last-Modified.

Суть этого метода: если после последнего обхода бота на страницы не вносились изменения, сервер должен дать 304 ответ, чтобы бот не скачивал их содержимое и прежде всего расходовал квоту на реально изменившиеся со времени предыдущей индексации или же новые документы. - Установить «Ловец ботов».

Когда поисковый робот будет приходить на страницу, специальный скрипт покажет ему ссылки именно на непроиндексированные страницы. Стоит упомянуть, что это довольно дорогое удовольствие. - Настроить автоматическое добавление ссылок с социальных сетей или хабов со ссылкой на новую страницу. Это привлечёт бота, он перейдёт по ссылке и обойдёт страницу. Таких ссылок должно быть много.

- Закрыть от индексации страницы пагинации, которые ведут на старые страницы. Оставить открытой пагинацию, которая ведёт на новые страницы, добавленные в течение 4–5 дней.

- Пинговать новые страницы.

2) Закрепление авторства контента за собой.

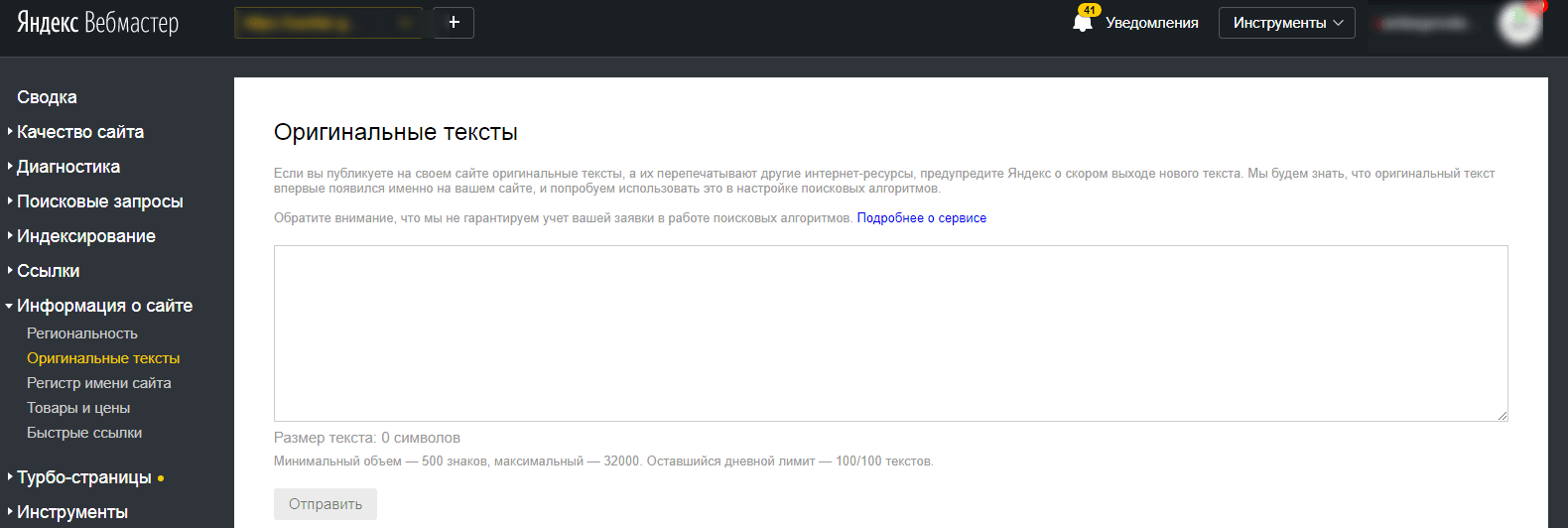

Яндекс:

- для нового контента используем инструмент «Оригинальные тексты» в Яндекс.Вебмастер (раздел «Информация о сайте»);

- на уже украденный контент подаём жалобу с помощью инструмента «Сообщить о нарушении авторских прав».

Google:

- Возможности закрепить за собой оригинальность текстов, как в Яндексе, нет. Поэтому прилагаем максимальные усилия, чтобы наш контент индексировался раньше.

- При нарушениях авторских прав подаём жалобу на дублирующий контент.

После рассмотрения и подтверждения авторского права страницы с дублированным контентом должны быть удалены из индекса ПС Google — пруфлинк.

3) Платное размещение статей на менее трастовых сайтах со ссылкой на оригинал, источник.

Чем больше таких ссылок получит источник, тем меньше поисковая система будет сомневаться в его авторском праве на этот контент.

При такой системе владельцы крупных новостных порталов могут быть уверены, что их репутация не пострадает за счёт более мелких и менее добросовестных ресурсов. Кроме того, владельцы менее трастовых ресурсов имеют возможность заработать на платном размещении статей со ссылкой на первоисточник контента.

4) Запрет на копирование

Защитить свой контент от копирования можно на уровне скрипта сайта, в котором прописываются специальные команды, или в которой добавляются некоторые плагины. Например, для WordPress существует специальный плагин WP-CopyProtect, который попросту запрещает выделение текста на странице, а также запрещает клики правой кнопкой мыши. Однако «продвинутые» пользователи всё же смогут вытащить контент из исходного кода страницы.

5) Скрытые ссылки

Существуют скрипты, которые при копировании контента с вашего сайта могут незаметно поставить ссылку на ваш же сайт в коде страницы конкурента. А чтобы человек, который воровал у вас контент, ничего не заметил, нужно продумать всего один момент — сместить ссылку таким образом, чтобы она не была видна редактору.

Важно! Данный метод нужно использовать крайне осторожно и применять только в том случае, когда ваш контент действительно воруют, так как Google может наложить санкции за скрытый текст и ссылки.

6) Брендирование изображений

Добавляйте на ваши фотографии и изображения фирменные цвета, логотип компании или ссылку на сайт. Это не только защитит картинки от копирования, но и повысит узнаваемость вашего бренда/ресурса.

Конечно, можно при помощи специальных программ убрать или обрезать логотип, водяной знак, однако не каждый станет тратить на это время и силы.

7) Замена изображения на пустой файл

Ещё один способ защитить картинку или изображение от скачивания — установить плагин для WordPress Photo Protect. При скачивании изображения мы получим только пустой файл.

Чтобы не дать скачать картинку в исходном размере, можно с помощью Photoshop наложить прозрачный слой такого же размера поверх оригинального изображения.

Конечно, при желании её всё равно можно будет скопировать, сделав скриншот, однако, опять-таки, не каждый будет тратить на это время.

Выводы

По моему мнению, поисковые системы всё-таки уделяют большое внимание уникальности контента, и она, без сомнения, является одним из важнейших факторов. Однако одной уникальности недостаточно, чтобы приблизить страницу к ТОПу поисковой выдачи.

- Уникальность текста будет работать в совокупности с востребованностью, полезностью, актуальностью, качеством написания и оптимизацией под ключевые запросы. Также нужно позаботиться о том, чтобы прочтение этих статей было удобно для пользователя. Тогда трафик не заставит себя долго ждать.

- Уникальный контент на сайте — это в первую очередь доверие поисковых систем и уверенность в том, что никаких фильтров не будет наложено.

- Если контент неуникальный, но даёт больше ценности для пользователя, чем первоисточник, такой контент, скорее всего, будет получать большую долю трафика, чем первоисточник.

- Если вы хотите копировать чужой контент, нужно больше работать над поведенческими факторами. Только тогда вы сможете попасть в ТОП.

Не растёт трафик сайта? Обращайтесь к нам!

Проанализируем потенциал и составим детальные инструкции по продвижению

Еще по теме:

- Как поднять релевантность страниц фильтров в глазах ПС? До определенного момента на сайте была главная категория которая оптимизировалась под весь пул запросов этой категории + закупались ссылки на эту категорию. После проработки семантики...

- Как уменьшить потерю трафика после смены урлов товаров в ключевых категориях? Из-за технической ошибки (при импорте файла с товарами на сайт) изменились урлы у товаров в ключевых категориях. Редиректы на новые адреса настроились на сайте автоматически....

- Как правильно реализовать динамический текст в теге Н1, чтобы он был доступен для индексации? Динамический текст в h1. Как правильно с точки зрения SEO реализовать появляющийся с помощью js текст (анимация печати), ведь для поисковых роботов текст не виден?...

- Хорошо или плохо nofollow для внутренних ссылок на сайте? Для внутренних ссылок на сайте nofollow — хорошо или плохо? На моём сайте главная страница плохо ранжируется, а внутренние — лучше. Я посмотрел статистику анкоров...

- Сезонность запросов в Яндекс и Google или как развивать сезонный проект Как собирать сезонные запросы Виды сезонных запросов Инструменты для определения сезонности Как и когда собирать сезонные фразы? Сезонность запросов в Key Collector Как продвигать сайт...

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

1. Копирайтинг — все равно не уникальная, копиры пишут не из головы, а на основе сайтов из выдачи

2. Оригинальные тексты не работают 🙁

3. Яндекс не пользуется сервисами на уникальность 🙁

4. Бесят идиоты которые ставят вотермарки — фотку нельзя нормально посмотреть.

Спасибо за статью.

Уникальность решает)!

Бандит многорукий, а не однорукий.

Точно 🙂

Спасибо за статью)

Рады помочь 🙂

Добрый день! Подскажите добрые люди ,как «Автоматически добавлять созданные страницы в sitemap. Вообще,как автоматизировать процесс?

Автоматическое добавление новых страниц в sitemap осуществляется с помощью скриптов, либо специальных плагинов для CMS. Например для wordpress есть плагин — https://ru.wordpress.org/plugins/google-sitemap-generator/, который автоматически обновляет xml карту/ Можете уточнить CMS вашего сайта, скину подходящий плагин, с помощью которого можно будет создавать и управлять sitemap.

Вы сам то верите в то что тут написали?

Тысячи сайтов не имеют своего оригинального контента НО они плотно уселись в ТОПе обоих ПС…

Может вам примеры привести )))