- (Обновлено: ) Ксения П.

- 15 минут

- Решение проблемы

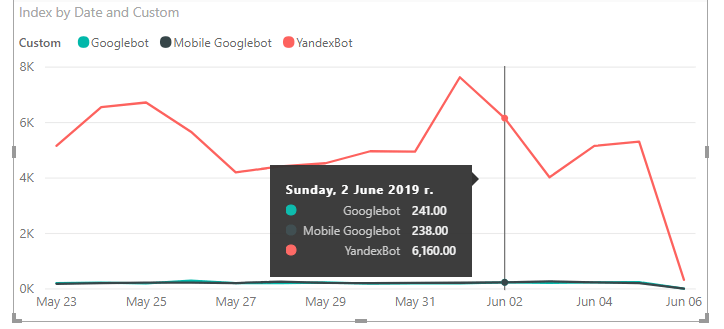

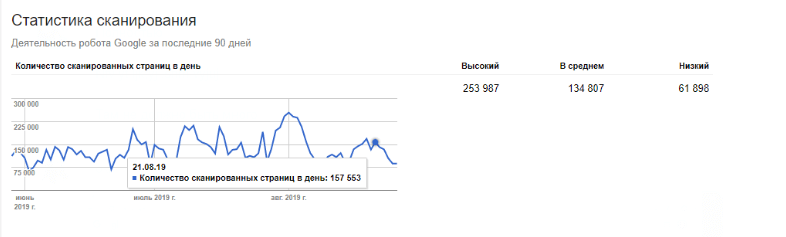

Частая проблема сайтов-пациентов – низкая скорость обхода страниц поисковыми ботами. Особенно это актуально для Googlebot. Зачастую сталкиваемся с тем, что бот Яндекса обходит в 10–20 раз больше страниц, чем основной и мобильный боты Google.

Такой показатель характерен как для больших интернет-магазинов (от 100 тыс. страниц), так и для небольших сайтов услуг (до 1 тыс. страниц).

И если несколько страниц, которые были откорректированы, можно добавить на переобход вручную. То при внесении изменений на всём сайте приходится ждать полного переобхода по несколько месяцев. Поэтому остро становится вопрос об увеличении краулингового бюджета.

В статье мы подробно разберём, что такое краулинговый бюджет, от чего он зависит, можно ли им управлять и как это делать.

Что такое краулинговый бюджет? Стоит ли заботиться о нём небольшим сайтам (до 1000 веб-страниц)?

Многие глубоко убеждены, что нет смысла анализировать поведение поисковых ботов, количество и качество страниц, которые они обходят. Мы считаем – это обязательное условие эффективного продвижения сайта. Как показывает практика, даже у сайта с небольшим количеством страниц могут быть серьёзные проблемы с обходом.

Например, Googlebot мог не обходить важные страницы небольшого (до 500 страниц) и достаточно молодого сайта кредитной тематики более трёх недель. Хоть Google обещал обратное.

Так что такое «краулинговый бюджет»?

Краулинговый бюджет — это количество страниц веб-сайта, которые сканирует Googlebot в течение определённого периода времени. Проще говоря, это количество страниц, которые бот хочет и может обойти.

Несколько примеров, почему «хочет» и «может» зачастую разные значения:

- Googlebot хочет обойти 1000 страниц в день, но сайт работает крайне медленно. И он обходит всего 200 документов в день.

- Сайт работает шустро, и все страницы отдают 200 ОК, но Googlebot не будет обходить все 1000 страниц, так как у сайта низкий органический трафик и, например, низкая цитируемость.

От чего зависит количество страниц, которое «может» обойти Googlebot:

- скорость загрузки – для страниц с высокой скоростью сайта увеличивается количество страниц, которое может обойти бот;

- работа сервера – если сервер не работает стабильно, количество страниц уменьшится;

- ограничения в GSC – можно поставить ограничение на количество страниц, которые обходит бот (заранее предупреждаем, что схитрить не получится, если вы понимаете, о чём мы).

От чего зависит краулинговый спрос или количество страниц, которые бот «хочет» обойти:

- необходимость переобхода – если нет необходимости в переиндексации, активность Googlebot будет низкой;

- количество трафика на страницу – чем больше трафика на странице, тем чаще бот будет её обходить;

- переезд сайта.

На краулинговый бюджет также негативно влияет большое количество низкокачественных страниц. К ним относятся:

- страницы-дубли;

- пустые страницы (мягкая 404);

- страницы с низкокачественным и спамным контентом;

- дубли страниц с get-параметрами и UTM-метками;

- бесконечные страницы.

В сутки Google индексирует около 8 млрд документов. С учётом количества сайтов и страниц во всём мире, важно научиться управлять краулинговым бюджетом в пользу своего ресурса.

Также важно постоянно следить за ним. Хотя бы в GSC. Иначе из-за новшеств программистов можно потерять 90% краулингового бюджета.

Почему краулинговый бюджет важен для SEO

Для получения максимальной отдачи от сайта и работ по SEO нужно, чтобы:

- поисковые системы находили и понимали как можно больше ваших индексируемых страниц;

- боты обходили документы как можно быстрее.

- новые и обновлённые страницы индексировались как можно скорее.

Секрет предельно прост: чем быстрее страницы проиндексируются или переиндексируются, тем быстрее вы сможете оценить свою работу.

Если не следить за тем, что обходят поисковые боты, можно израсходовать краулинговый бюджет впустую. Он будет тратиться на мусорные страницы сайта, которые не имеют значения. В то время как важные документы не просканируются и не попадут в индекс, а вы не получите желаемый трафик.

Как понять, куда и как расходуется краулинговый бюджет?

Единственный достоверный источник информации, сколько и какие страницы обходят поисковые боты — анализ лог-файлов.

Логи — это файлы (журнал), содержащие информацию о работе сервера или компьютера, в которые заносятся обращения пользователя или бота.

Не стоит полагаться на то, что последняя дата обхода в GSC – достоверна. Алексей Трудов уже рассматривал несовпадения данных в панели и журнале логов на реальных кейсах (Блок «Насколько точны данные о последнем сканировании страницы»).

- Зачем анализировать логи, если в GSC показывает, что краулинговый бюджет составляет 2000 страниц, а у меня на сайте всего 500. Всё же в порядке?

- А после анализа выявляется, что бот по 300 раз обошёл 5 страниц, и 450 обращений к файлам CSS, JS, PDF и т. п. (ведь краулинговый бюджет расходуется не только на страницы).

Для анализа логов можно использовать самые разные программы:

- Screaming Frog Log Analyzer;

- JetOctopus;

- LogViewer;

- GoAccess;

- Loggly;

- написать свой анализатор на Python, например;

- Power BI и множество других.

Мы рекомендуем использовать Power BI из-за возможности кастомизации отчётов.

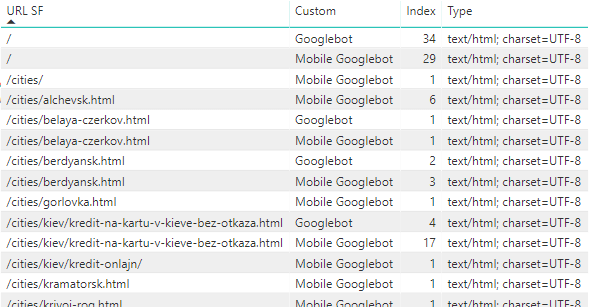

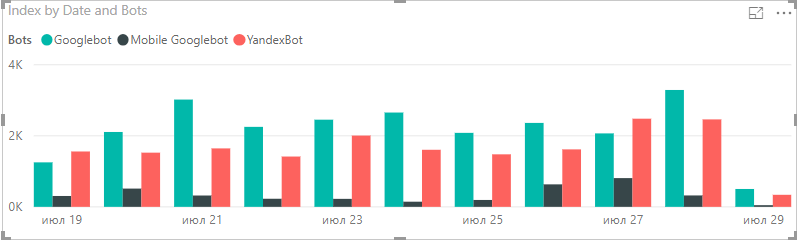

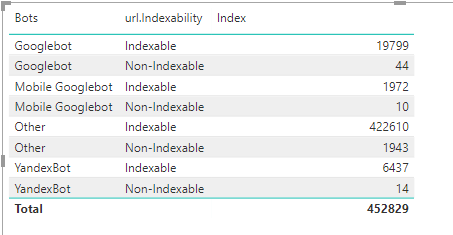

После создания проекта по нашей инструкции вы сможете запросто настроить нужный вам отчёт. Несколько примеров:

- Страницы, которые обходит мобильный Googlebot.

- Распределение ответов серверов и ботов.

- Динамика посещения страниц ботами за определённый период.

- Количество страниц, которые закрыты от индексации, но всё равно обходятся ботами.

- Какие страницы обходят боты, несмотря на то, что на них нет ссылок на сайте (для этого нужно добавить данные парсинга сайта).

После того как отчёты будут настроены, вы наверняка обнаружите какую-то проблему.

Частые случаи:

- боты редко или вовсе не посещают страницы, которые важны для продвижения;

- большое количество 4хх и 5хх ошибок;

- сайт не посещает мобильный Googlebot;

- большое количество ссылок, которых нет на сайте;

- и многое другое.

Как управлять и увеличивать краулинговый бюджет?

В своей практике мы использовали разные методы, чтобы увеличить краулинговый бюджет и направить бота туда, куда нужно.

Это игра вдолгую. Не ожидайте, что бюджет вырастет через неделю после внесения изменений. Такое возможно только в случае улучшения скорости загрузки сайта. Если говорить о том, чтобы закрыть ненужные страницы от сканирования — борьба с ботом может затянуться надолго.

Почему? Все помнят отчёт в Google Search Console «Обнаружена, не проиндексирована»? Даже если вы убрали ссылки с 301-редиректом с сайта, есть вероятность, что бот уже записал их себе в базу. Со временем он их все обойдёт. Придётся только подождать энное количество времени.

А теперь разберём банальные, известные и не очень методы управления краулинговым бюджетом.

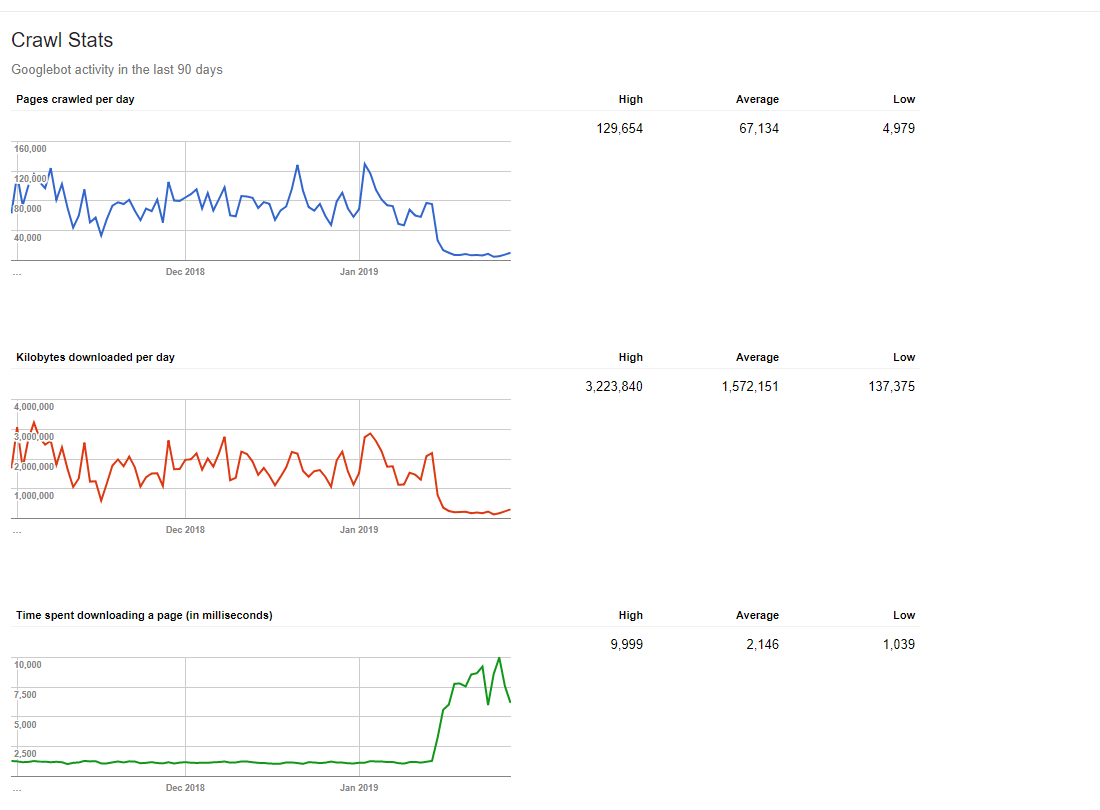

- Увеличить скорость сайта.

Ускорение загрузки сайта, как правило, приводит к тому, что робот Google начинает сканировать больше URL. Что вполне логично. Если раньше бот тратил 5 секунд на одну страницу, а вы уменьшили это время до одной – краулинговый бюджет изменится обратно пропорционально.

Совет: не забывайте, что скорость сайта нужно увеличивать не только для десктопов, но и для мобильных устройств. Так как парсят их разные Google-боты.

- Улучшить внутреннюю перелинковку.

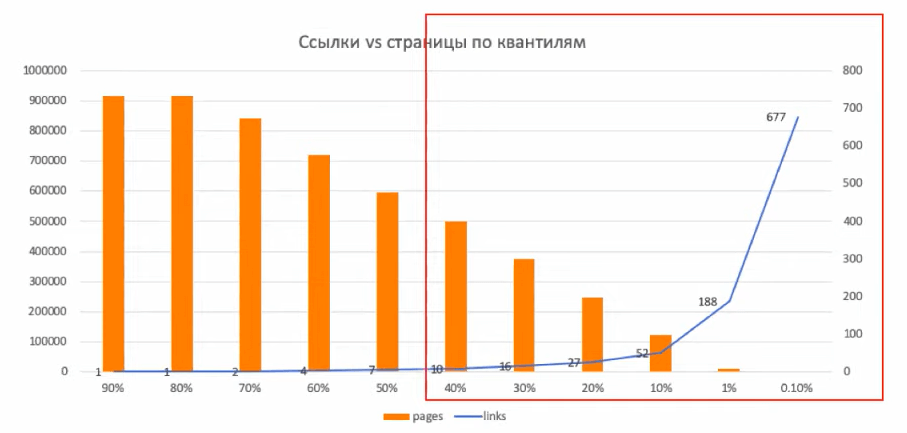

Допустим, у вас есть сайт с 100 тыс. страниц. Бот обходит важные продвигаемые страницы раз в два месяца. Почему так происходит? На всём сайте стоит только по 3 ссылки на эти страницы. Вдобавок две страницы из трёх закрыты от индексации. Чтобы привлечь бота на страницу, нужно разместить больше внутренних ссылок. Есть гипотеза: если на страницу ведёт меньше 10 внутренних ссылок, она будет реже сканироваться ботом.

На самом деле внутренняя перелинковка — это основная проблема крупных сайтов. На скриншоте показан сайт, на 50% страниц которого ведёт менее 7 внутренних ссылок. Частая ошибка — важные продвигаемые страницы попадают в эти 50%.

Источник: вебинар Сергея Безбородова — https://www.youtube.com/watch?v=nqx07yjRuA8.

- Уменьшить глубину сайта.

Отчасти задача тоже связана с перелинковкой. Чтобы бот чаще краулил страницу, она должна быть доступна в 2–4 клика от главной. Чем глубже находится страница, тем реже её обходит бот.

- Убрать «сиротские страницы».

Сиротские страницы — это страницы, на которые нет внутренних или внешних ссылок. Случается, что страницу создали, а ссылку на неё поставить – забыли. Следовательно, как боту узнать о существовании документа?

- Удаляем мусорные страницы (дубликаты, документы низкого качества).

Об этом говорит Google в своей справке: дубликаты и низкокачественные страницы вредят краулинговому бюджету. Поисковая система не хочет тратить ресурсы, индексируя несколько страниц с одинаковым содержимым, пустые документы и т. д.

Как закрыть мусорные страницы:

- В файле robots.txt. Это не гарантия, что страницы не будут сканироваться. Но если на сайте миллиард способов фильтрации товаров, которые тратят краулинговый бюджет, быстро закрыть их можно с помощью директивы disallow в robots.txt. Даже если 10% из них просканируется – это уже хороший показатель.

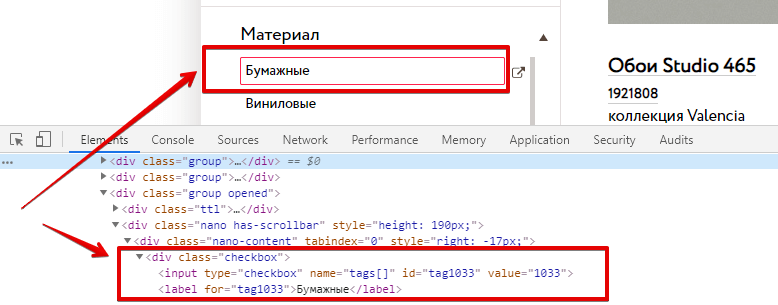

- Реализация фильтров через ajax. Основное преимущество – нет физических ссылок на такие страницы.

- Уникализация и улучшение контента. Это один из вариантов, как можно увеличить краулинговый бюджет. Большая часть контента на сайте должна быть уникальной и качественной.

- Запретить действия, которые не может выполнить робот Googlebot.

С помощью robots.txt можно запретить сканирование страниц входа, контактных форм, корзин покупок и других страниц, единственная функциональность которых не может быть выполнена сканером.

- Избавиться от бесконечной пагинации.

Представим ситуацию: есть страница категории «Каталог одежды для девочек». Она разбита на 1234 страницы пагинации. Но если перейти на 1235 или 3179 – получим ответ сервера 200 ОК. Хоть товара на таких страницах и нет.

Бесконечная пагинация вредит краулинговому бюджету. При обходе бот тратит свои ресурсы на обход бесполезных страниц без товара.

Как исправить: настройте автоматический редирект с несуществующих страниц пагинации на последнюю.

- Удалить идентификатор сессии из URL.

Из URL можно удалить и поместить в файл cookie Get-параметры, которые не изменяют содержимое страницы, например, идентификаторы сеансов. Поместив эту информацию в файл cookie и перенаправив 301 редиректом на «чистый» URL, вы сохраняете информацию и сокращаете количество URL, указывающих на тот же контент. Сейчас программистам не ставят отдельное ТЗ на реализацию этой задачи. Это делается по дефолту. Но мы решили упомянуть, так как раз в полгода встречается и такое.

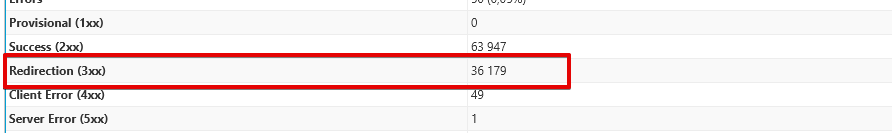

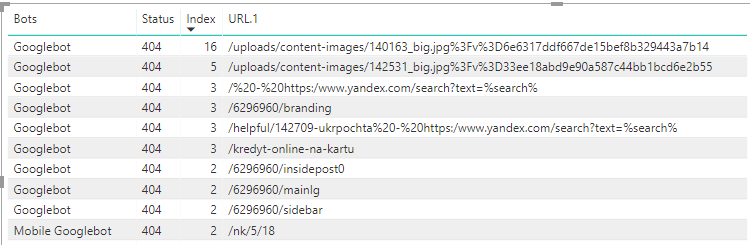

- Уменьшить количество страниц, которые отдают 4xx и 5xx ответы сервера.

Первый шаг к увеличению количества просматриваемых страниц — убедиться, что они возвращают один из двух возможных кодов возврата: 200 (для «ОК») или 301 (для «Перейти сюда вместо»). Все остальные коды возврата — тратят бюджет.

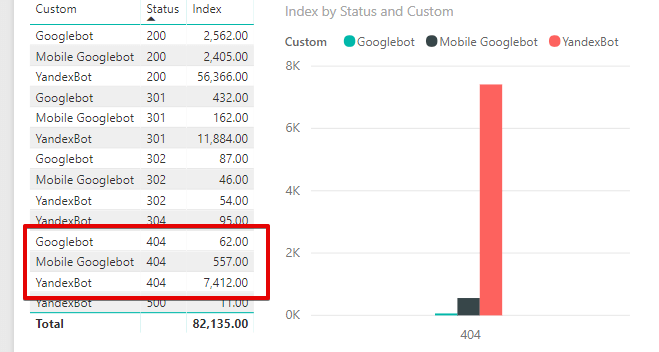

Пример того, как 15% бюджета расходуется на страницы с 404 ответом сервера:

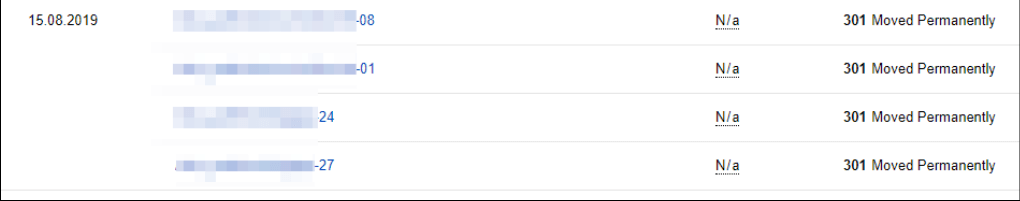

- Уменьшить количество ссылок с редиректами.

На обход страниц с 301-редиректом бот тратит ресурсы, которые мог бы использовать на страницы с 200 ОК. Простая математика: на сканирование вашего сайта выделено ресурсов для обхода 1000 URL; 500 лимитов было потрачено на страницы с 301-редиректом; на страницы с 200 ОК остаётся только половина.

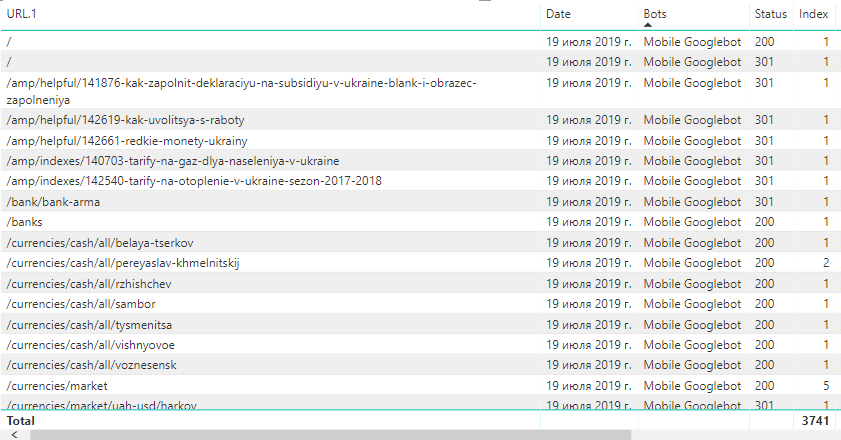

- Привести в порядок XML-Sitemap.

Чистый XML-файл сайта поможет ботам понять, куда ведут внутренние ссылки и как структурирован ваш сайт. Карта сайта должна содержать только канонические URL-адреса, соответствовать вашему файлу robots.txt (не указывайте страницы, заблокированные в disallow).

Например, неактуальные ссылки в карте сайта расходуют часть краулингового бюджета, но не приносят пользы в продвижении. На примере ниже: в карте сайта были ссылки без слеша в конце, на которых был настроен 301-редирект.

- Закрыть ссылки rel=»nofollow».

Направить бота на нужные страницы можно, закрыв часть ссылок с помощью атрибута nofollow. Таким образом вы перераспределяете внутреннюю значимость документов – чем больше ссылок идёт на страницу, тем она важнее в глазах поисковых систем. Бот не должен перейти по ссылке, которая будет закрыта в этот атрибут.

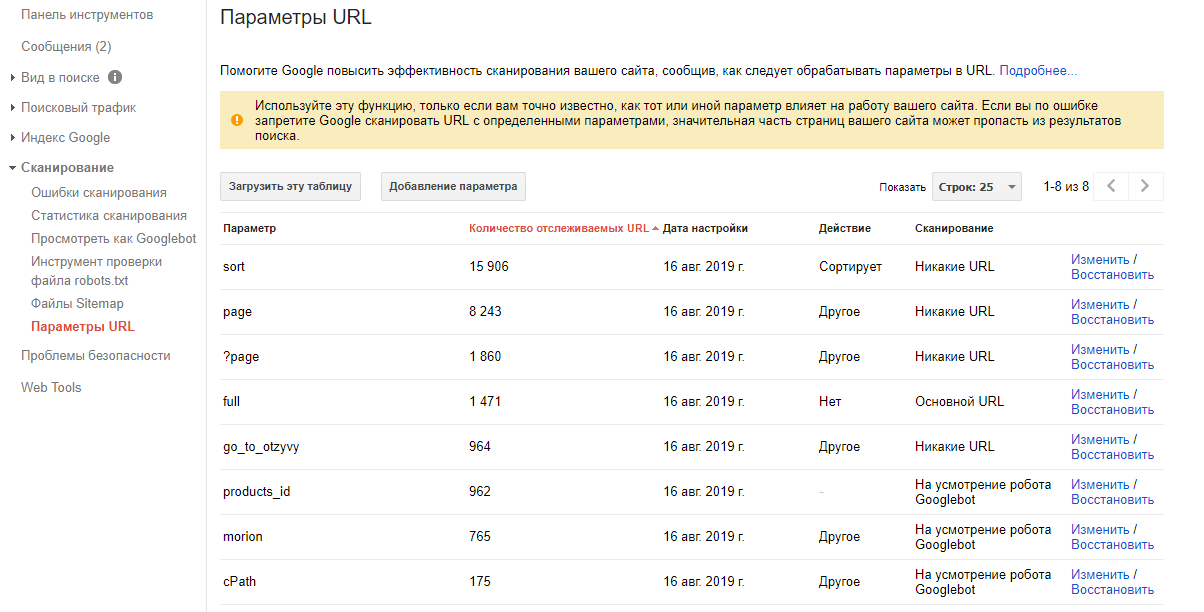

- Настроить параметры URL в консоли.

Наиболее эффективный метод, о котором все почему-то забывают: закрыть страницы сортировки, фильтрации и всё, что содержит get-параметры, в Google Search Console.

- Настроить HTTP-заголовок If-Modified-Since.

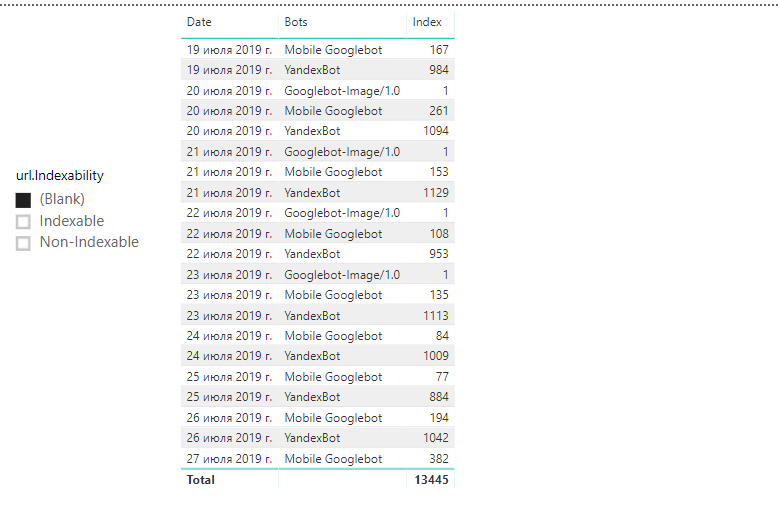

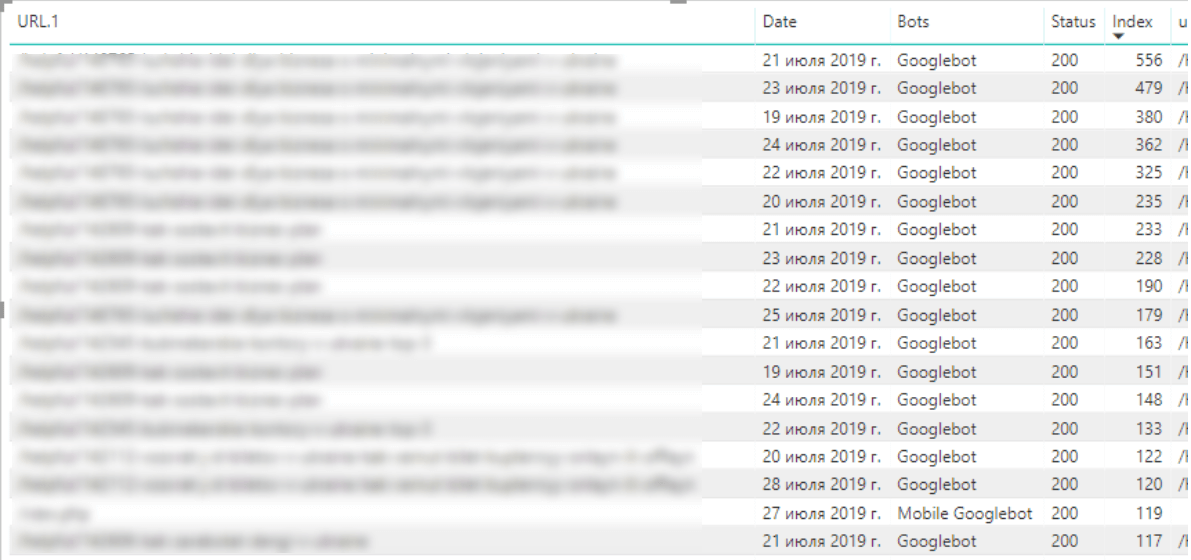

Если на страницу не вносились изменения после последнего обхода Googlebot, сервер должен отдать 304 ответ – не скачивать содержимое. В таком случае квота будет расходоваться только на реально изменившиеся или новые документы. Это особенно важно для сайтов с большим количеством страниц. Также актуально, если при анализе логов видите, что бот обходит одну и ту же страницу 556 раз в день (столбец Index показывает, сколько раз и какой бот обходил в день одну страницу).

Проверить корректность обработки заголовка If-Modified-Since можно с помощью специального сервиса http://last-modified.com/ru.

- Постоянно вносить изменения на страницы – добавить динамический контент.

Чтобы бот постоянно обходил нужные страницы, добавьте на них динамический контент.

Это может быть:

- блок с популярными товарами;

- блок «С этим товаром также покупают»;

- блок «Вас также может заинтересовать».

Ежедневно меняйте товар в этих блоках. В глазах бота ваша страница будет ежедневно обновляться, что заставит обходить её чаще.

- Настроить 410 ответ сервера для удалённых страниц.

Боты по несколько раз обходят страницы с 404 ответом сервера.

Чтобы сообщить, что страница удалена навсегда — настройте 410 ответ сервера.

- Настроить HTTP-кеширование

Это один из самых эффективных методов по оптимизации краулингового бюджета. Не будем многословными, просто читайте Справку: https://developers.google.com/web/fundamentals/performance/optimizing-content-efficiency/http-caching.

Вместо заключения

Корень проблем, связанных с индексацией и переобходом страниц, зарыт в ошибках сканирования сайта. Анализируйте логи, они расскажут чуть ли не всё.

Если следовать простым правилам и рекомендациям по оптимизации краулингового бюджета, Googlebot будет обходить по 150 тыс. страниц в день 😉

30-31 октября не пропустите Optimization — самую масштабную seo-конференцию с участием Яндекса, Google, российских и западных экспертов.

Специальный гость: Сайрус Шепард — автор блога MOZ, консультант компаний из списка Fortune 500. Сайрус расскажет, как бизнесу среднего масштаба наращивать трафик из Google, соревнуясь с монополистами.

Опытом в seo поделятся: Сергей Кокшаров (Devaka), Михаил Шакин, Михаил Волович, SimilarWeb (Израиль), Сравни.ру, Sports.ru, Канобу, Дмитрий Иванов, Алексей Чекушин и др.

Если у вас нет возможности приехать в Москву, забронируйте онлайн-трансляцию Optimization с полным пакетом выступлений и презентаций и возможностью задать вопрос онлайн.

Ознакомьтесь с полной программой и зарегистрируйтесь на сайте конференции.

Если хотите значительно улучшить индексацию сайта, обращайтесь к нам!

Еще по теме:

- Как блокировка отображения сайта в iframe на сторонних ресурсах влияет на ранжирование сайта? Веб-мастера сделали блокировку отображения сайта в iframe на сторонних ресурсах. После чего видимость немного ухудшилась. Вопрос: влияет ли такой запрет на ранжирование сайта? Ответ Напрямую...

- Какие существуют обязательные редиректы для сайта? Есть обязательные редиректы www/без, с/ на без /, index.php, http/https (при смене протокола), а есть ещё не обязательные редиректы? Или остальные настраиваются по мере появления?...

- Почему через оператор site страницу не находит в поиске Google? По данным Google вебмастера страница есть в индексе, но через оператор site:site.com "название товара" не находит в поиске. Почему такое может быть? Ответ То, что...

- Как увеличить скорость загрузки сайта за счёт анализа и оптимизации скриптов Что усложняет загрузку страницы? Если есть возможность, избегаем ненужных скриптов Если скрипт нужен на короткий промежуток времени, не используйте его 360 дней в году Если...

- Какие технические ошибки реально влияют на позиции сайта в поиске? Какие технические ошибки реально влияют на позиции сайта в поиске, а какие — просто “формальные”? Ответ Граница между реально влияющими ошибками и "формальными" очень часто...

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

Статья супер, читал ещё в рассылке, побольше бы таких! Кстати, там у вас написано:

И сразу после этого:

Т. е. как бы получается, что бюджет 301 не тратит, а ресурсы тратит — надо выбрать что-то одно 🙂

Добрый день, Станислав. Благодарю за отзыв и вопрос.

Постараюсь максимально подробнее ответить.

В первом случае я пыталась донести мысль, что это нормально, если в логах есть URL, которые обходят боты или пользователи с 301-ответом сервера. Есть же ссылки на внешних ресурсах или в индексе. Они тоже, как и любой другой ответ, тратят бюджет. Но не попросту, как 4хх и 5хх ответы.

Во втором речь идёт о том, что если ссылки в сайтмапе или на сайте и их много — то это бессмысленное расходование бюджета.

Жаль что панель гугла теперь новая и картинки со статьи не подходят

Почему не подходят? Там всё актуально по-прежнему.