Ответ

Заставить Google переиндексировать столь значительный объем страниц в короткий срок не получиться, все упирается в краулинговый бюджет сайта. Как правило в достаточно крупных и качественных сайтах нет его дефицита и Google постепенно переиндексирует все страницы и сам.

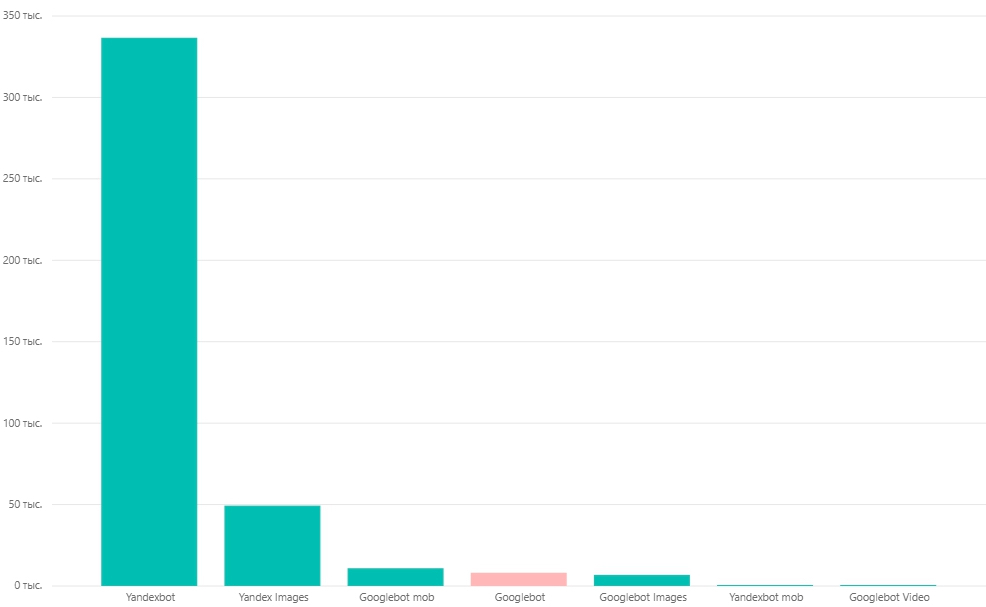

В первую очередь нужно провести анализ логов сервера для определения того, стоит ли вообще проводить работы увеличению краулингового бюджета и куда он собственно тратиться. Если картина анализа логов выглядит примерно так, рекомендуем ознакомиться с нашими советами по увеличению краулингового бюджета:

Особое внимание уделить:

- Формированию динамического Sitemap. Текущую карту сайта в данном случае заменяют динамической, которая содержит только те страницы, которые нужно переиндексировать. Страницы, на которые заходил Googlebot или Googlebot-Mobile, фиксируются в логах сервера и удаляются с динамической карты, на их место загружается новая выборка страниц.

- Настройке 304 ответа сервера. Сервер настраивается таким образом, чтобы на запрос методом GET с использованием заголовков If-Modified-Since или If-None-Match, сравнив временные метки, сервер отдавал 304 ответ (Not Modified), если страница не изменялась.

- Созданию новых динамических блоков на страницах сайта, в которых рандомно показываются ссылки на страницы, которые еще не посещал Googlebot.

- Улучшению скорости сайта. По нашим наблюдениям размер краулингового бюджета значительно зависит от скорости загрузки сайта. Улучшив ее можно рассчитывать не только на улучшения краулингового бюджета но и на улучшения метрик Core Web Vitals.

Для массовой отправки непроиндексированных страниц на переобход иногда мы рекомендуем использовать скрипт, который позволяет автоматически отправить 200 url в сутки, по 100 за один раз. Но при столь большом количестве страниц он будет малоэффективен.

В крайнем случае можно попробовать удалить для ботов весь JS, на рендеринг которого он тратит время. Важно при этом убедиться, что все содержимое страницы находится в начальном HTML [источник].

Хотите получить ответ на свой вопрос? Задайте его нам через телеграм-бота!↓

Еще по теме:

- Как время ответа сервера (TTFB) влияет на индексацию Google? Интернет-магазин строительных товаров, сделан по типу каталожки, очень много категорий. Однако, у сайта есть проблема - время ответа сервера (TTFB) чуть ли не 2 секунды,...

- Как ускорить индексацию страниц сайта после полного запрета? Клиент запретил индексировать весь сайт в Robots.txt. Отменили и поправили всё, но похоже не помогло. Как отменить эффект запрета от индексации и помочь ПС индексировать...

- Какие причины попадания страниц старого сайта в индекс после переезда на другой домен? Когда-то у сайта был переезд с одного домена на другой, но я обнаружил, что через команду site: показывается много страниц в индексе со старого сайта....

- Почему статья спустя время может перестать индексироваться в Google? Почему статья спустя время может перестать индексироваться? Часть статей вылетела из Google, при этом статьи перестали считаться уникальными, сервисы проверки уникальности показывают статьи, которые вышли...

- Почему Google не индексирует региональные поддомены и как решить проблему? Есть сайт с региональными языковыми поддоменами. С индексацией главного сайта проблем нет, но вот страницы поддоменов Google никак не хочет индексировать. Практически все "Просканировано, но...

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

Отзывы клиентов:

"Не ожидал получить настолько качественный анализ и советы за минимальную цену"

Дмитрий Сокол

Hostings.info"Здесь можно реанимировать сайт даже со страшным диагнозом"

Денис Кушнир

Aden-stroy.ru"Сайт вышел из-под фильтра, переспам был ликвидирован"

Вячеслав Мусякаев

Vprognoze.ru

Убедиться что все левые опции движка открыты, затем разбить просто карту по 1000 страниц, добавить их в гугл серч консоль — профит. Не помню точно, но читал пост на английском о техническом сео в бурже, сайт имеющий 17 млн страниц в индексе имел всего 2 млн. Разбили карту сайта по 3000 ссылок — через месяц в индексе в районе 7 млн страниц было. Тестировал сам на генерированных сайтах — так и есть. Чем меньше карта сайта — тем быстрее индексируется сайт в целом. Главное либо обновлять часть постов либо добавлять новых страниц, чтобы все карты обновлялись. Другое дело добавить все карты сайта в вебмастер гугла) Делал это с помощью зенки — за 30 минут добавилось примерно 800 карт. Тут еще заметил фишку, что на отдельную карту сайта может быть отдельный краулинговый бюджет. Логично, если у сайта куча xml карт — сайт большой. И нужно больше ресурсов и краулингового бюджета.

Динамическая карта-сайта хорошо конечно, но займет много времени. Сильно много ссылок в него закинешь — все не пересканит. Есть потолок краулингового бюджета. Т.е если например 40к в динам xml карте — может обойти 5к. Но вот саму карту сайта он может сохранить. Увидев что 35к страниц не изменилось — может снова не обойти их.

Ставить ссылки в коде на страницах — можно, но вес просто будет распределяться неравномерно и будут постоянные качели трафика и позиций. Тем более несколько типов гуглбота есть — быстробот, гуглбот и гуглбот для карт (инфу ведь сначала смотрит в серч консоли, если добавили карты). Просто потратите бюджет гуглбота на сканирование левых страниц и передачу на них веса. Хотя можно было просто разбить их на мелкие и скормит ьв серч консоль и краулинговый бюджет станет больше -0 значит быстрее перескан.

На счет динамической карты — верно, все ссылки в нее не впихнуть. Стартовый объем ссылок для динамической карты мы рассчитываем исходя из показателя количества всех ботов Google посещающих сайт за сутки, как показывает практика — это оптимальное количество. Спустя время мы пересчитываем обьем ссылок в карте при росте краулингового бюджета.