- Ссылочный бум и наращивание ссылочной массы

- Накрутка ПФ

- Перехват быстрого ответа

- Кража краулингового бюджета

- Склейка доменов

- Аффилирование

- Защита от DDOs-атаки

- Снятие ссылок

- Жалобы на сайт

- Размножение индекса

- Дубли контента

- Негативные отзывы

- Кража трафика (хостинга)

- Заключение

Сегодня поговорим на одну интересную тему – как уберечься от негативных действий конкурентов. Хотя Яндекс и говорит о том, что положить сайт в поиске нельзя, на деле, увы, всё немного наоборот.

Рисунок 1. Ответ Яндекса

Конкуренты или просто нехорошие люди всё же могут причинить вред вашему сайту и бережно (или не очень) проводить его в руки фильтров и санкций поисковых систем. Для этого есть много самых разнообразных способов: от банальных манипуляций со ссылочной массой до программных методов. Но вспомним о пословице «против лома нет приёма, если нет другого лома».

Закончим с предисловием и приступим к описанию способов, к которым могут прибегнуть вредители, и как защититься от них.

Ссылочный бум и наращивание ссылочной массы

Раньше ссылочный бум был опасен, сейчас же с этим явлением всё неоднозначно. Нельзя точно сказать, сможет ли он навредить сайту или нет, но перестраховаться надо. Ссылочный бум особенно опасен для молодых сайтов, так как у них ещё нет большой ссылочной массы, да и доверия от поисковиков не так много.

Его суть заключается в том, что за короткий промежуток времени на страницы сайта закупается большое количество ссылок со спамных площадок. При этом эти ссылки делаются явно SEOшными: со спамными анкорами, нередко с ноткой, а, может, и целой симфонией адалта. Этим вызывают не только ссылочный бум, но и переспам анкор-листа. От Яндекса за такое «Минусинкс» был бы обеспечен.

Наращивание ссылочной массы похоже на ссылочный бум, только длиться это будет дольше. Сама угроза уже не вполне конкретна и опасна для вашего сайта и повлечёт за собой последствия. На сайт будут постоянно закупаться некачественные ссылки. Объём таких ссылок, покупаемых за раз, вряд ли будет таким большим, как при буме, но некачественных ссылок будет становиться всё больше и больше, тем самым поддерживая и увеличивая долю спама в ссылочном профиле.

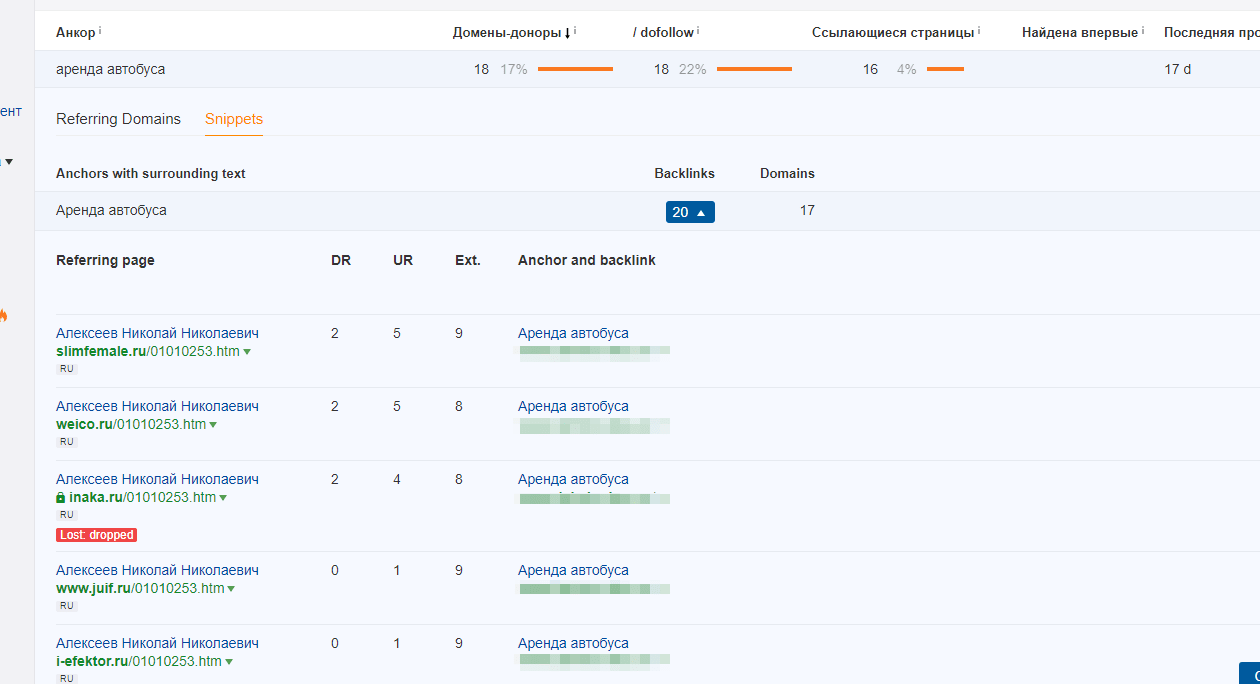

Рисунок 2. Пример переспама акнор-листа

Защита от таких манипуляций для Google – сам алгоритм, который не будет их учитывать. Нелишним будет поместить все спамные ссылки в Disavow Links Tool. А вот у Яндекса всё сложнее: как только вы заметите подозрительную активность, нужно сразу написать Платону об этом факте и попутно снимать спамные ссылки, которые поставили на сайт.

Накрутка ПФ

Накрутка поведенческих факторов – серьёзная проблема, особенно для сайтов с небольшим трафиком. Осуществить против них вредоносные действия проще и сил на это уйдёт меньше. Для сайтов с большим трафиком сделать такую накрутку будет сложнее (нужно заметить, сложно – не значит невозможно, будьте внимательны).

Злоумышленники будут имитировать действия пользователей, переходя на ваш сайт по определённым запросам, и вести там бурную деятельность. Это не разовое мероприятие, с каждым разом переходов будет больше, запросы и страницы будут оставаться теми же. Первое время они могут изощриться и делать всё, не привлекая внимания. Последствия после такой акции будут, мягко говоря, очень неприятны. Как Google, так и Яндекс это «оценят» и последний отправит ваш сайт под фильтр на 8-9 месяцев.

Против этого есть свои способы защиты. Нужно написать о факте накрутки поведенческих факторов Яндексу и заблокировать IP адреса, из которых идут подозрительные переходы.

Перехват быстрого ответа

Конкурент может перехватить быстрый ответ Google со ссылкой на ваш сайт и заменить на свой сайт. В чём же суть. Представьте, что по определённому запросу в выдаче Google есть быстрый ответ со ссылкой на ваш сайт, при этом сайт конкурента может быть на несколько позиций выше вашего или ниже – особой разницы нет. Конкурент берёт текст, который находится в быстром ответе, и копирует его на свой сайт с незначительными изменениями. После этого он отправляет свою страницу на переиндексацию и через некоторое время в быстром ответе уже, вполне вероятно, будет находиться ссылка на его сайт. Конечно, вряд ли это нанесёт вам значительный ущерб, но точно будет неприятно.

Защиты как таковой от этого нет, придётся играть с конкурентом в «перетягивание каната» и переписывать участок, который попадёт в быстрый ответ. Также нужно улучшать информацию, изложенную на странице.

Кража краулингового бюджета

Это довольно интересный способ, к которому могут прибегнуть конкуренты. Интересен он тем, что «доброжелатели» находят у сайта страницы, которые должны отдавать 404 ответ, а на деле отдают 200 или 301/302. Замечу, такие ошибки встречаются достаточно часто и их нужно устранять. Затем они анализируют их, придумывают новые URL вашего сайта и проверяют на ответ сервера, увеличивая количество несуществующих страниц.

Конкуренты собирают список таких URL и начинают запускать на них поискового робота, загоняя их в индекс. Таких страниц будет не десятки и не сотни, счёт пойдёт на тысячи.

Сначала вы не увидите особых проблем, кроме такой «мелочи», как постоянное увеличение количества несуществующих страниц, но через несколько недель сайт начнёт выпадать из индекса. Это случается потому, что краулер бегает по несуществующим страницам, а к существующим просто не доходит.

Чтобы такого не случилось, нужно (главное!) настроить корректный 404 ответ и регулярно проверять панель Вебмастера на предмет появления несуществующих страниц. Подробнее о несуществующих страницах вы можете узнать в статье «Error 404 — что значит, как найти и исправить ошибку».

Склейка доменов

Вот тут вот может возникнуть неожиданный поворот событий. Конкурент найдёт сайт, который находится под баном за ссылки или за накрутку поведенческих факторов, и склеит его с вашим сайтом. Этим он передаст бан вам. Бан передаётся не сразу, это произойдёт не раньше, чем через 3 недели.

Защита от подобного не самая надёжная, но это лучше, чем ничего. Если обнаружили подобные склейки, пишите хостингу с просьбой убрать такие сайты.

Аффилирование

Ещё один вариант – создание одного или нескольких аффилированных сайтов. Всё будет происходить по такому сценарию: создаётся сеть сайтов, похожая по многим параметрам или чуть ли не точная копия вашего сайта (схожий контент, адреса, телефоны, дизайн и т. д.), далее выжидается, когда вся сетка, включая ваш сайт, попадёт под аффилирование.

Защититься от этого непросто. Если обнаружите такие аффилированные сайты, пишите хостингу с просьбой убрать их и предупредить ПС об этом факте с указанием аффилированных сайтов. Ещё один вариант: принимать кардинальные меры по уникализации своего сайта.

Защита от DDoS-атаки

Хотя это и не SEOшный способ, но мы поговорим не о самой DDoS-атаке, а о том, как хостинг может защитить вас от неё, тем самым увеличив количество внутренних переходов. Суть следующая: у хостинга есть некая защита от DDoS-атаки, которая ставит проверочный куки и перезагружает страницу, тем самым рефер поисковой системы отваливается и переходит в статус внутренних переходов, а боты отсекаются.

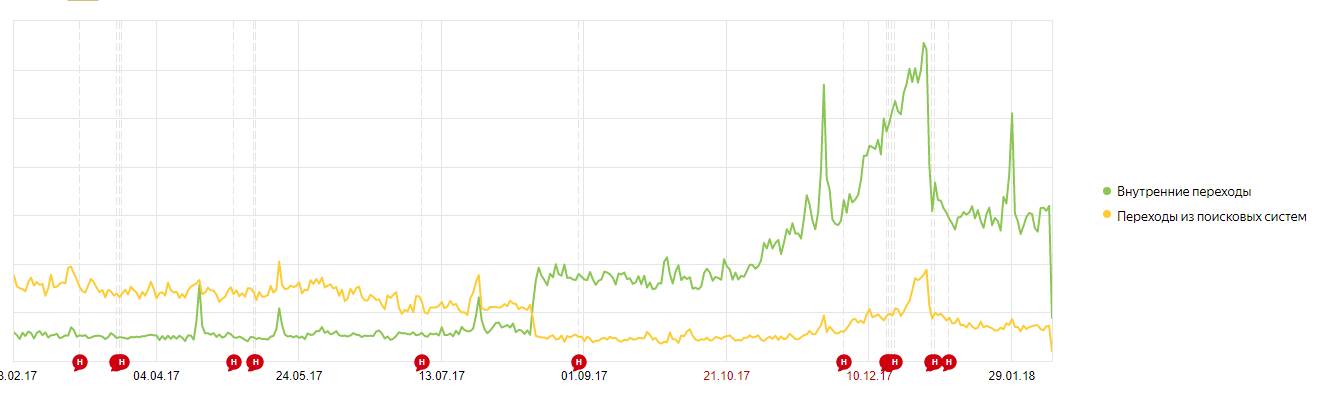

Рисунок 3.

Хостинг может и не сказать вам о том, что у него стоит такая защита, и вы не будете знать, что происходит. Следует узнать у хостинга, есть ли такая защита, и попросить отключить её.

Снятие ссылок

Это неожиданный ход конём. Конкуренты проанализируют ваш ссылочный профиль, соберут информацию и начнут снимать все хорошие ссылки. Они будут писать донорам от вашего лица о том, что нужно убрать ссылку и так далее. Через некоторое время вы обнаружите, что ссылок стало меньше. Вследствие этого вы потеряете не только средства, затраченные на сами ссылки, позиции также просядут.

Защиты от этого нет. Придётся писать донорам, чтобы вернули ссылки, аргументируя тем, что в сторону вас ведётся атака.

Жалобы на сайт

Это простой и, я бы сказал, творческий способ. На ваш сайт начинают жаловаться. Это могут сделать сразу из поиска Google или Яндекса. Жаловаться могут на что угодно: от спама или несоответствия результатам поиску до мошенничества, запрещённого контента и т. д. Так как одной жалобы будет мало, и она не принесёт результата, конкуренты создадут задачу на специальных сервисах, чтобы её выполнило как можно больше пользователей. Через некоторое время ваш сайт забанят.

Творческий он потому, что конкуренты могут добавить на сайт плохие ссылки и сразу же пожаловаться; написать какой-то нехороший контент в комментариях и, опять же, написать жалобу.

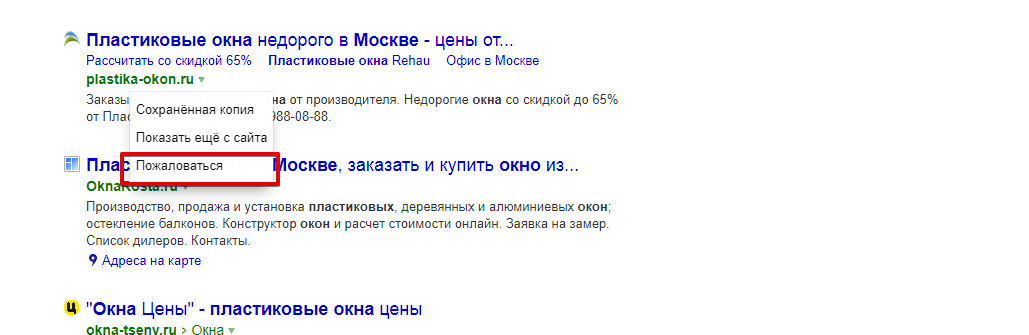

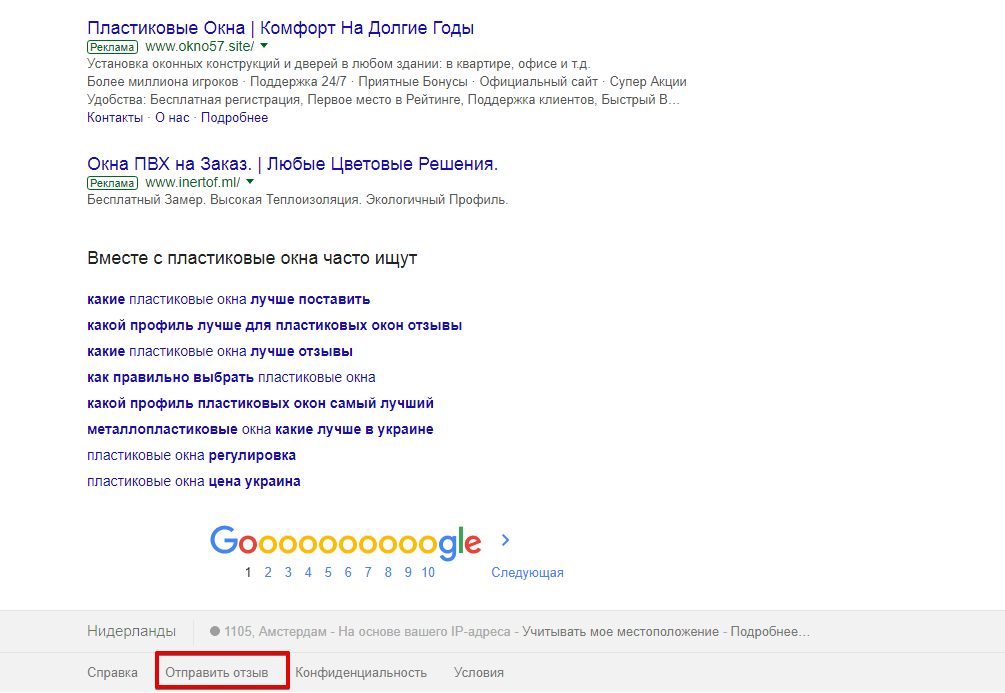

Рисунок 4.Жалоба у Яндекса

Рисунок 5.Жалоба у Google

Защититься от этого непросто. Придётся писать Яндексу о том, что жалобы были искусственными, а если жалоба была создана не на пустом месте, быстро устранять проблемы и писать об этом. Опять же, нужно постоянно следить за сайтом.

Размножение индекса

Этот способ связан с техническими ошибками сайта и очень похож на кражу краулингового бюджета. Отличается немного другой схемой реализации: вместо несуществующих страниц ищут дубли.

У жертвы находят дубли страниц с 200 ответом, далее пытаются увеличить их количество, подставляя новые значения и проверяя ответ сервера. Один из способов поиска дублей – открытая к индексации страница поиска, фильтры, корзина. Когда конкуренты соберут большое количество таких страниц, их начнут массово загонять в индекс. В результате произойдёт обвал позиций.

Защититься можно, закрыв от индексации корзину, поиск, сортировку и т. п. Также можно настроить устранение самих дублей. Если вы всё же попали под удар, выход из такой ситуации затянется: поисковому роботу придётся заново проходить такие страницы, что увеличит время решения проблемы. Узнать о дублях больше можно в статье «Дубли страниц. Чем опасны? Как найти и удалить?».

Дубли контента

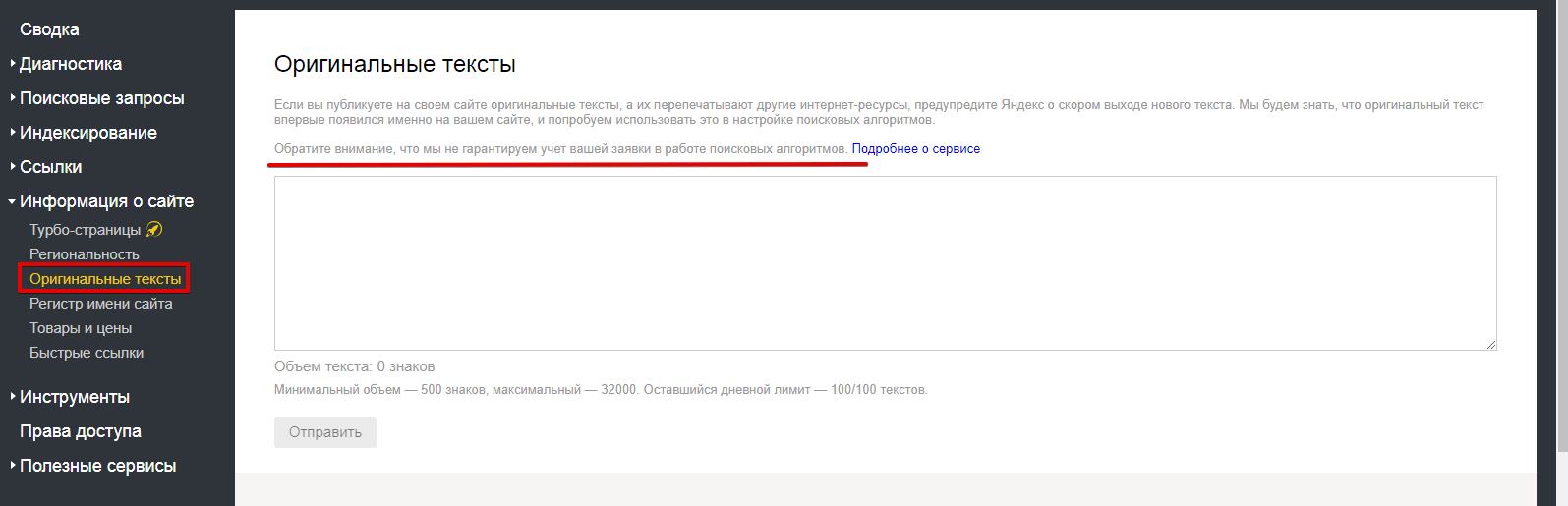

Этот способ больше касается информационных сайтов, ведь, в основном, у них воруют и дублируют контент. Представьте, вы написали статью, отредактировали её, она попала в ТОП, но потом вылетает из него, а на её месте находится уже другой сайт с точно такой же статьёй. Это может случиться, если вы не присвоите своей статье авторство в Вебмастере, но, как пишет Яндекс, с этим могут быть накладки и алгоритм может не учесть вашу заявку.

Рисунок 6. Оригинальные тексты в Яндексе

Если ваш уникальный текст был первым написан и проиндексирован, но потерял позиции из-за дублирования на другом сайте, пишите об этом в Яндекс. В качестве доказательств прикрепляйте скриншоты с веб-архива, если он успел их сделать, или ссылки из социальных сетей, доказывающие, что ваш контент был размещён раньше.

Негативные отзывы

Применение этого способа нанесёт вред репутации вашего сайта, хотя могут и уменьшить трафик, даже если сайт был в ТОП–3. В комментариях, отзывах начинают писать негативные ответы, ставить низкий рейтинг. Когда пользователь видит такие комментарии, он вряд ли захочет воспользоваться вашими услугами или приобрести товар. Он может даже не перейти на сайт с поисковой выдачи, увидев низкий рейтинг в сниппете.

Защититься можно с помощью модерации комментариев и отзывов.

Кража трафика (хостинга)

Наиболее маловероятный способ, к которому могут прибегнуть конкуренты. Этого нужно опасаться, если на вашем хостинге установлен лимит на трафик (сейчас встречается редко). Сам по себе этот способ очень прост. На каждом сайте есть какие-то файлы: картинки, текстовые документе, PDF-файлы. «Доброжелатели» берут URL таких файлов и, внимание, импортируют их в Google Spreadsheets.

Например, картинку поставят через формулу “=image(“url”)”, а вдобавок припишут несуществующих аргументов. Таким образом, у них появятся тысячи дублей только одной картинки. Что происходит – когда прописана такая формула, Google бот FeedFetcher перейдёт по адресу и закэширует изображение для дальнейшего отображения в таблице. Так как таких запросов будет очень много, трафика будет тратиться много, и он будет быстро кончаться. Если на хостинге стоит ограничение по трафику, вам придётся платить дополнительные деньги за трафик, который был накручен.

Защититься можно путём блокирования этого бота в файле .htaccess.

Заключение

В заключение хочу сказать, что не всегда конкуренты могут вести атаку на ваш сайт. Зачастую сам владелец сайта с этим прекрасно справляется или помогает тем же конкурентам. Так что, перед тем как забить тревогу с криками «меня атакуют», нужно проверить, а всё ли вы делаете правильно и не привели ли к проблемам именно ваши действия/бездействия. Только потом, если действительно была атака, начинать кричать.

Да, картина, мягко говоря, складывается грустная, но это лишь часть тех способов, к которым могут прибегнуть конкуренты и, что хуже, вряд ли они будут использовать только один. Скорее всего, это будет комплекс мер. Всегда нужно быть начеку и проверять состояние своего сайта, попутно исправляя ошибки, которые были найдены. Вряд ли кто-то захочет проснуться и обнаружить, что над его сайтом надругались.

Давайте вспомним слова одного знаменитого персонажа из мультфильма и последуем им.

Еще по теме:

- Мини-отчет о конференции “Интернет-магазины Украины 2013” 19 Апреля в Харькове прошла очередная, в этом году уже третья по счету, конференция “Интернет-магазины Украины 2013”. Удачно стартовав в 2011 году, конференция продолжает набирать...

- Топ лучших вопросов SEO-доктору выпуск #3 В нашем Telegram-канале "Дежурный SEO-доктор" уже накопилось свыше 350 вопросов от вебмастеров и SEO-специалистов, в первом и втором выпусках подборки лучших вопросов мы уже отвечали на...

- Требуется помощник SEO-оптимизатора Если вам интересно помогать сайтам становиться на ноги, лечить их от разных болезней и вы хотите стать SEO экспертом - добро пожаловать к нам. В...

- Как быстро продвинуть сайт (первоапрельский гайд) Создаём сайт Наполняем контентом Оптимизируем конверсии Добавляем CTR сниппетам Внешнее продвижение В заключение Прежде всего, хотим извиниться перед теми, кто удалил Яндекс.Метрику после предыдущей нашей...

- Юзабилити на дороге. Цифровые технологии на службе пешеходов В современном мире технологии развиваются семимильными шагами, поэтому вполне естественно, что люди пытаются их использовать для разрешения текущих проблем и для улучшения существующих систем. Как...

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

с несуществующими страницами до конца не понятно — как и что

Первое, это смотрят сайт, на наличие страниц которые должны отдавать 404 ответ, но по каким-то причинам этого не делают. К примеру представим некий сайт «site.ru» у него есть страница которая отдает 200 ответ например «site.ru/home». Мы начинаем добавлять к адресу что-то, «site.ru/home123», и пусть будет так, что хоть это страница и не существует, но она по прежнему отдает 200 ответ, либо перенаправляет нас на какую-то другую страну тоже с 200 ответом. Вот такие страницы нам и нужны. Берется и еще дописывается к адресу всякого, и проверяется ответ. Собрав список страниц (он может быть хоть бесконечным) и проверив, что каждая в нем несуществующая страница сайта «site.ru» отдает вместо положенного 404 ответа 200-тый, эти страницы начинают усиленно индексировать. Это продолжается длительное время, тем в самым в индексе появляется огромное число страниц которых нет на сайте, и все они отдают 200 ответ вместо 404. Краулер каждый раз бегает по этим страницам, которых с каждым днем все больше и больше, и в итоге просто пропускает существующие страницы и забывает о них. И они (существующие страницы) вываливаются из индекса.

Виктор, отличная статья, сразу видно, что разбираетесь в том, что пишите.

Спасибо

хорошая статья. Спасибо. Один момент про DDoS-атаку. Сейчас многие хостеры ставят Ддос защиту. Некоторые используют сервисы типа ClidFlare или Sucuri. Если принцип везде один , т.е. как вы пишите «тем самым рефер поисковой системы отваливается и переходит в статус внутренних переходов, а боты отсекаются.», то поясните как отваливание рефера сказывается на ранжировании сайта?

На ранжирование это никак не повлияет. Суть в том, что в Метрике, Вы заметите просадку органического трафика и рост внутренних переходов. И возможно это внесет неразбериху. Ведь Вы начнете искать причину просадки и делать лишние действия для решение проблемы которой грубо говоря нет. Вы просто будете зря тратить время и силы.

спасибо за ответ. Это я и хотела понять. Т.е. по факту с сайтом ничего не происходит и из топа его не выкидывают))

Жуть, если захотят утопить, то утопят, а отомстить и не знаешь кому!

Кто такой Платон и как ему написать о спамных линках?

И куда конкретно в яндекс и гугл сообщать о поведенческих и ссылках?

Платон — это псевдоним тех.поддержки Яндекса. Написать ему можно перейдя по этому адресу https://yandex.ru/support/webmaster-troubleshooting/other.html и выбрав из предложенного списка пункт «Другой вопрос о сервисе или инструменте», затем поставить галочку в пункте «Ответ на вопрос не удалось найти, написать в службу поддержки». http://take.ms/dElsk Дальше вводите свои данные и описываете Вашу проблему или вопрос. По поводу поведенческих и ссылок для Яндекса писать по ссылке выше. А для Google про ссылки можно и не писать есть сервис Disavow Links Tool https://www.google.com/webmasters/tools/disavow-links-main Перейдите по ссылке, выберите свой сайт, и загрузите файл со списком всех ссылок которые Вы считаете нежелательными (спамными), остальные, хорошие ссылки, вписывать в файл не нужно. По поводу поведенческих в гугле никому не напишешь, у них есть только форум в котором Вам врядли помогут сотрудники гугла.

А если…

Поставить 403 на все переходы с нежелательных ссылок(доменов)?

Гугл будет иначе воспринимать такие ссылки? Имею ввиду, будет ли он пропускать их в учете ссылочной массы на мой сайт?

Нет смысла настраивать 403 ответ сервера для нежелательных ссылок/доменов под Google. Гораздо проще воспользоваться сервисом Disavow Links Tool https://bit.ly/2L6KM91. Вам будет достаточно собрать список нежелательных ссылок или доменов, вставить их в текстовый документ в формате txt и добавить его на сервис. Подробнее можно узнать в справке https://support.google.com/webmasters/answer/2648487?hl=ru

Так и делаю. Но похоже, что это слабо работает. Мне наваливают каждую неделю ссылки и после первого «навала» вот уже 2 месяца позиции не возвращаются даже на первую страницу.