- (Обновлено: ) Виктор К.

- 8 минут

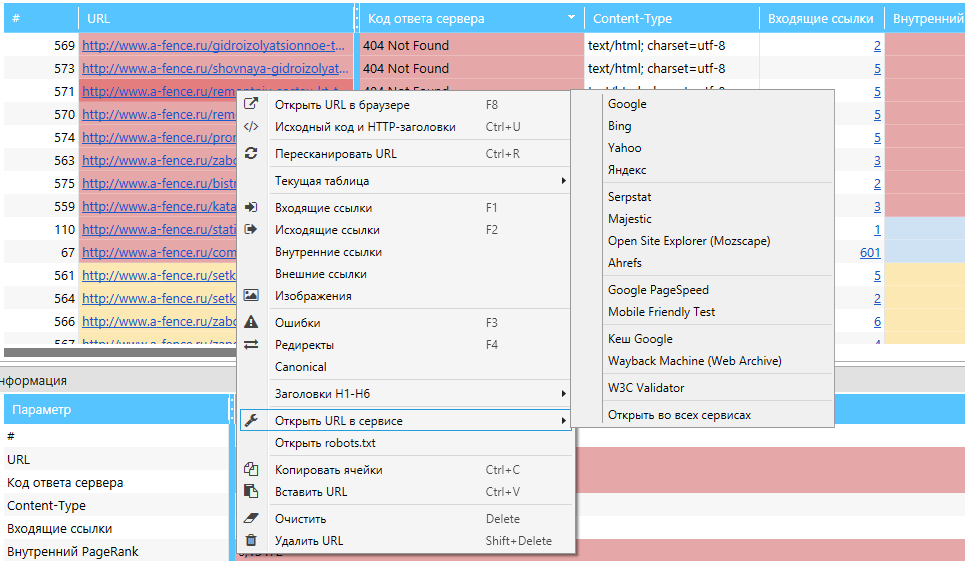

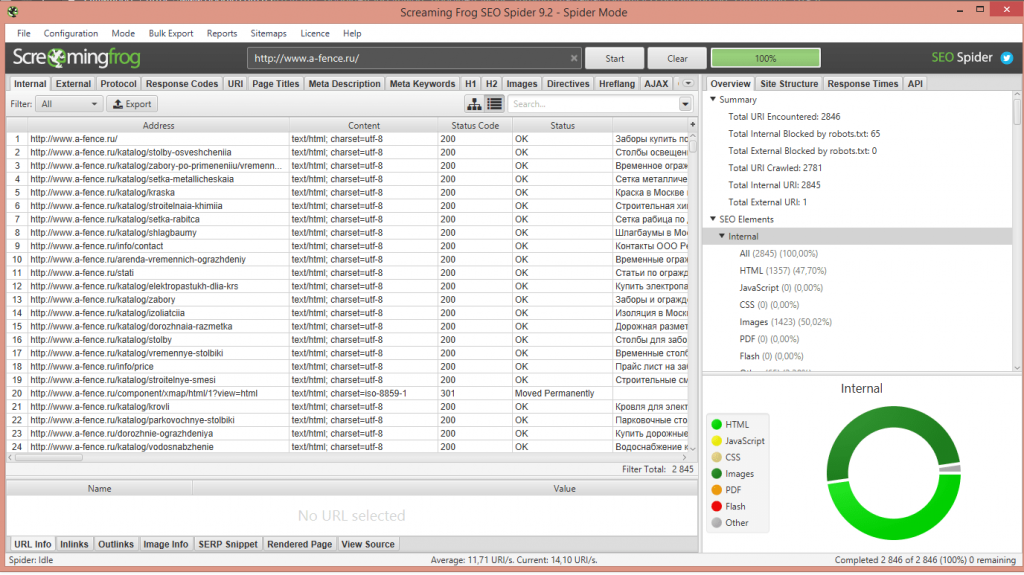

- Screaming Frog SEO Spider 9.2

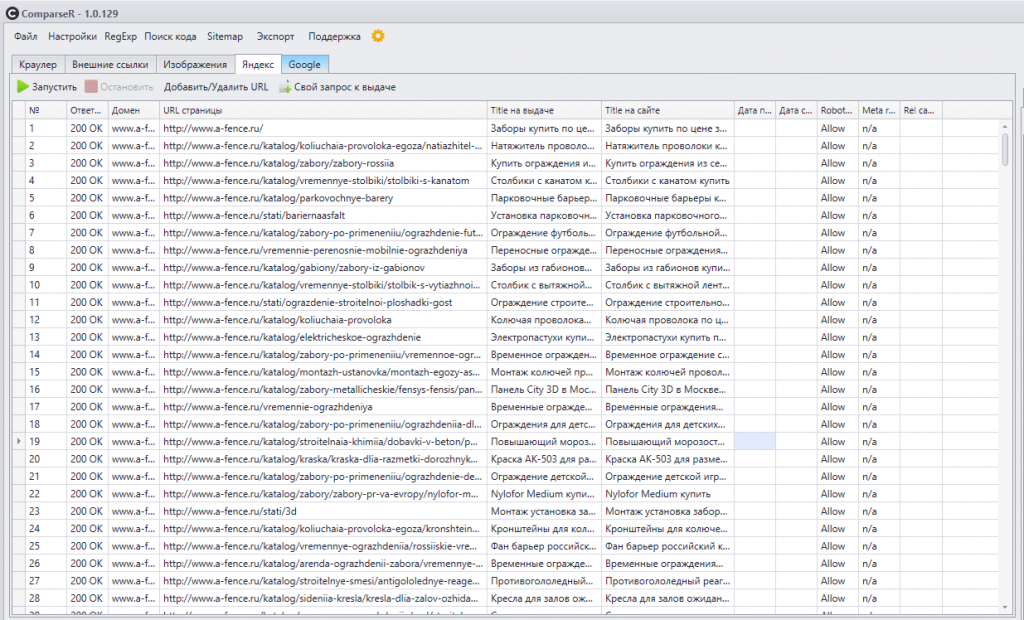

- ComparseR 1.0.129

- Netpeak Spider 3.0

- Xenu’s Link Sleuth

- WildShark SEO Spider

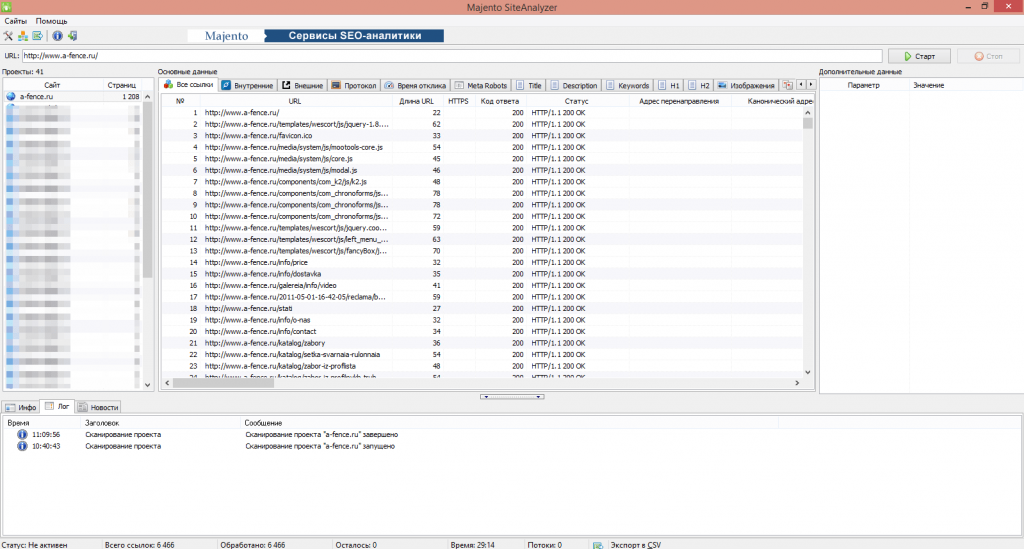

- Majento SiteAnalayzer

- Выводы

Сегодня представить технический анализ сайта без парсера невозможно. Эта программа помогает выявить большинство технических ошибок, найти битые ссылки, неисправные редиректы, узнать, правильно ли настроен robots.txt, уровень вложенности и многое другое.

Парсеров много. Они разнятся своим функционалом, удобностью и, конечно же, ценой. Рассмотрим несколько ярких представителей среди этих программ и оценим их функционал, удобность и время работы.

Для оценки функционала возьмём перечень функций, которые обязательно должен иметь «идеальный» парсер:

- Поиск битых ссылок.

- Указание входящих и исходящих ссылок страницы.

- Указание типа и цепочки редиректов.

- Возможность фильтровать страницы:

- — использовать регулярные выражения;

- — сканировать по правилам robots.txt, meta robots, canonical и т. д.

- Парсинг отдельных URL.

- Выявление дублей Title, Description и заголовков H.

- Указание уровня вложенности.

- Указание заголовков H и их количества.

- Код ответа сервера.

- Возможность смены User Agent.

- Title и его длина.

- Description и его длина.

- Keywords и его длина.

- Canonical.

- Meta robots.

- Alt и его длина.

- Тип контента.

Итак, у нас есть 17 основных требований. Отдельно будем считать дополнительный функционал, удобство и скорость работы.

Удобство, конечно, показатель субъективный. По 5-балльной шкале буду оценивать, насколько мне было удобно и просто работать с программой.

Скорость работы будет показана на примере сайта, размер которого – около 6 тыс. страниц, а к индексации разрешено около 1500 (стоит отметить, что у сайта открыты к индексации скрипты, поэтому он может парсить и их). Для каждого инструмента будут одинаковые условия парсинга.

Screaming Frog SEO Spider 9.2

Screaming Frog – британский, всем известный парсер. Это одна из лучших программ в своём роде, но у неё «кусается» цена и не самый удобный интерфейс. С помощью этого парсера можно собрать множество показателей.

Его функционал полностью отвечает списку обязательных возможностей. Единственный минус – не очень удобный интерфейс. Стоит отметить, что у Screaming Frog есть обширный мануал по работе с ним, там можно найти всю нужную информацию.

Отдельно нужно сказать о его удобстве: не составит труда поверхностно посмотреть данные, но для более глубокого изучения порой приходится смотреть мануал.

Дополнительного функционала у инструмента достаточно. Вот наиболее интересные возможности, по моему мнению:

- Проверка, как то или иное заполнение robots.txt повлияет на индексацию сайта.

- Просмотр структуры сайта.

- Сканирование сайтов, которые требуют авторизации.

- Генерация Sitemap.

- Поиск по коду.

- Настройка скорости парсинга сайта.

С парсингом сайта справился всего за 3 минуты – это довольно быстро, что является только плюсом.

Оценка: 17 баллов

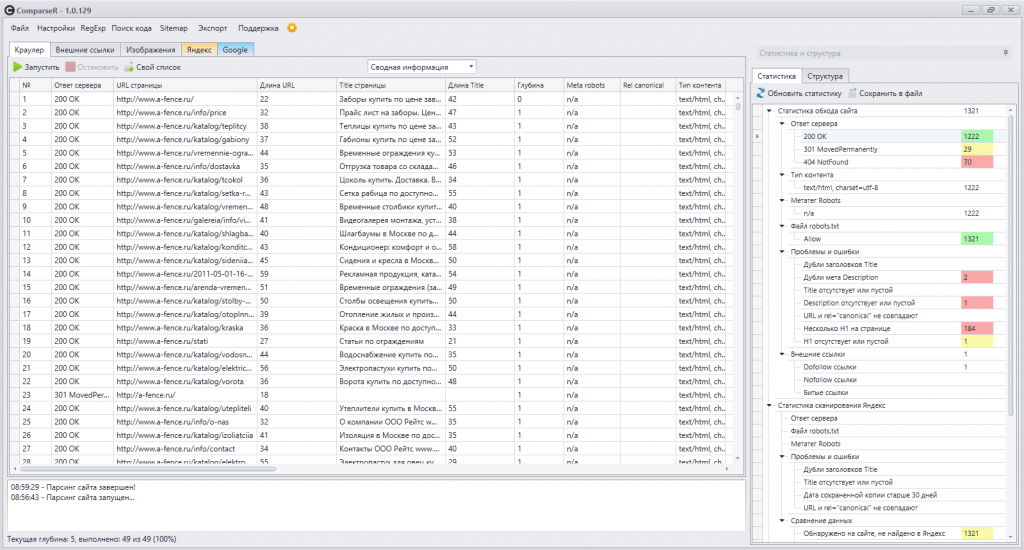

ComparseR 1.0.129

ComparseR 1.0.129 – довольно хороший парсер, отлично справляется с парсингом сайта. Стоит отметить, что его основная задача – не просто спарсить страницы сайта, а проверить его индексацию в поисковых системах. Инструмент имеет большой функционал, не хватает лишь списка ссылок на страницу и со страницы. В остальном же всё отлично.

Из дополнительных функций у него есть:

- Проверка индексации страниц в Google и Яндексе (показывает все проиндексированные страницы в ПС, может показать даже те страницы, которые были отфильтрованы для парсинга). Это действительно классная функция, с помощью которой можно узнать, какие страницы проиндексированы, а какие – нет.

- Просмотр структуры сайта.

- Поиск кода или текста на страницах.

- Генерация Sitemap.

- Возможность парсить многостраничные сайты.

- Парсинг сайтов, требующих авторизации.

- Проверка индексации сайта при том или ином заполнении robots.txt.

В общем, как видим, функционал хороший. Парсер прост и удобен, сложностей в работе с ним не возникает.

Парсинг сайта занял 2:56 – это отличный результат.

Оценка: 16,5 баллов

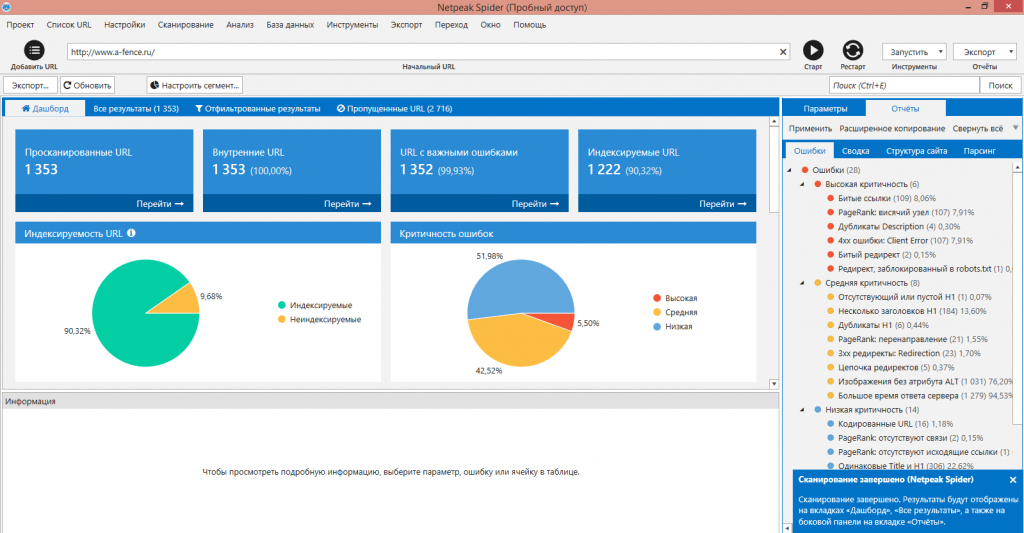

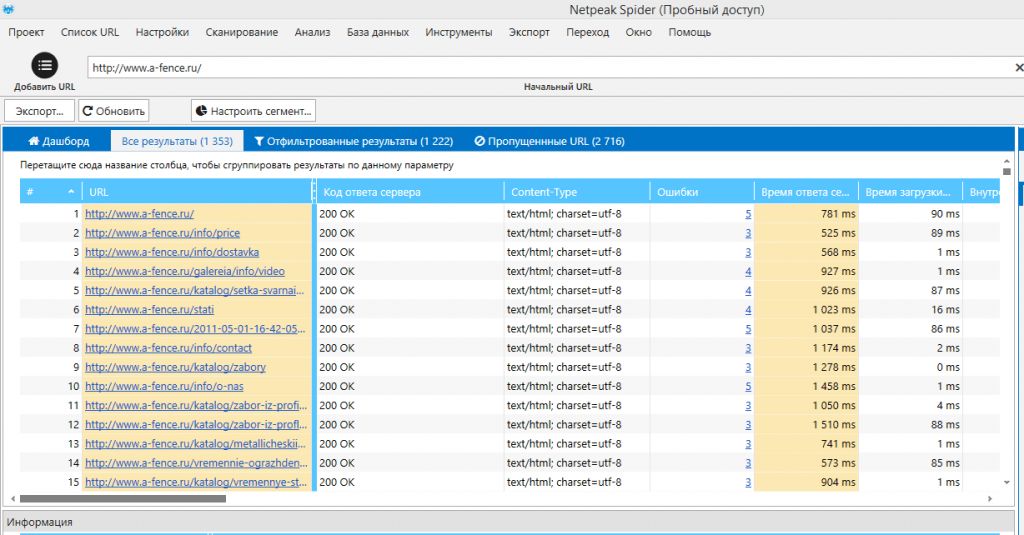

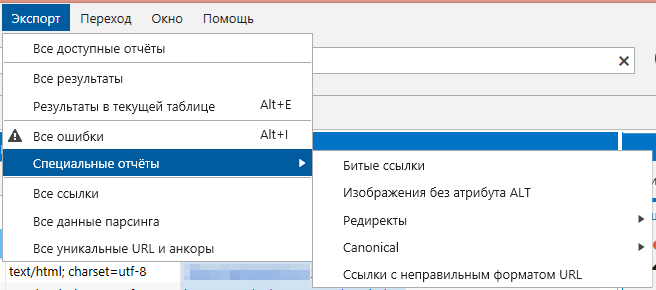

Netpeak Spider 3.0

Netpeak Spider 3.0 – это новая версия парсера, которая вышла совсем недавно. Как и Screaming Frog, он хорошо справляется с парсингом сайта. Основные отличия от «лягушки»: более удобный и понятный русскоязычный интерфейс и наличие дополнительных функций.

Разработчики Netpeak Spider 3.0 пишут, что он справляется с большими сайтами с малой затратой ресурсов компьютера. Такая оптимизация действительно полезна, ведь не каждая «машина» сможет справиться с сайтом-миллионником. Чтобы спарсить такие сайты, порой приходится пользоваться виртуальной машиной с лучшими характеристиками, а это дополнительные расходы.

В нём есть весь обязательный функционал, конечно, было бы странно, если за такую цену у него не было каких-то функций. Есть вопросы к блоку ошибок: спорный момент по поводу распределения ошибок и почему не сделали распределение по всем ошибкам определённого типа. Например, общий пункт ошибок заголовков H со списком ошибок по этому пункту и так по всем ошибкам.

Из особенностей можно выделить:

- Удобную настройку фильтров.

- Интерактивный и удобный интерфейс.

- Возможность выгрузить отдельные отчёты, которые вас интересуют.

- Можно получить информацию по определённому URL без лишних кликов.

- Просмотр структуры сайта.

- Возможность задавать пользовательский robots.txt для сканирования.

- Парсинг сайтов, требующих авторизации.

- Поиск кода или текста на страницах сайта.

- Настройка скорости парсинга.

- Возможность остановить и продолжить парсинг в другое время.

- Перенос данных по проекту на другой компьютер.

Этот парсер справился со сканированием нашего сайта всего за 5 минут, что тоже достаточно быстро.

Оценка: 17 баллов

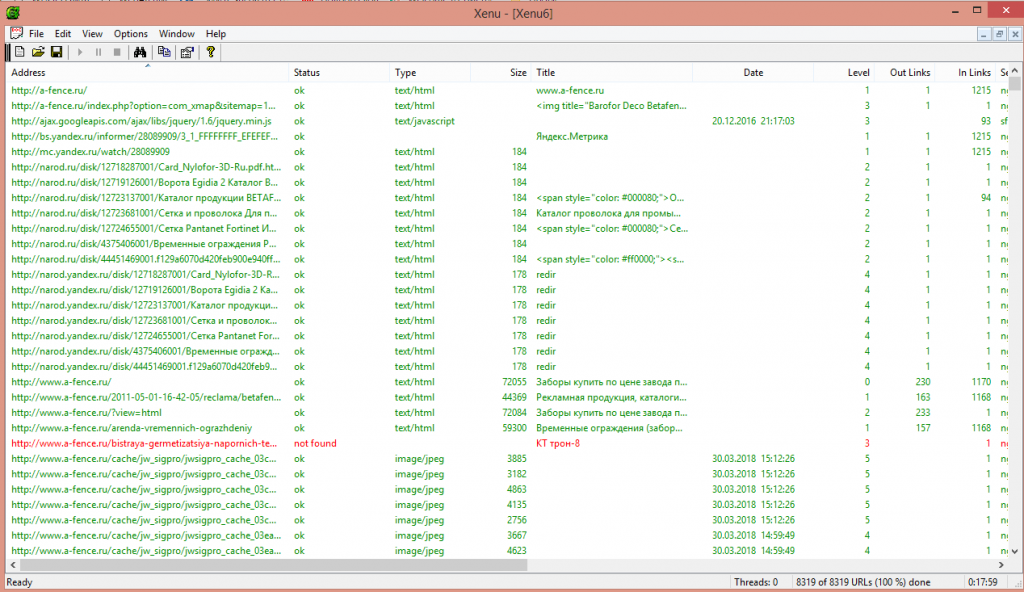

Xenu’s Link Sleuth

Xenu’s Link Sleuth – этот парсер предназначен для поиска битых ссылок, поэтому его функционал сильно отличается от функционала программ, описанных выше. Инструмент бесплатный, что не может не радовать.

Со своей основной задачей он справляется отлично, хотя имеет минус – не указывает ссылки со страницы и на страницу. Для детального анализа он не подойдёт. Если вам нужно узнать, есть ли битые ссылки на сайте, и какой уровень вложенности страниц, можете смело использовать Xenu’s Link Sleuth.

Если нужно больше информации о сайте, лучше выберите другой парсер.

Парсинг сайта занял 17:59 минут – это не так быстро, как хотелось, но приемлемо.

Оценка: 8 баллов

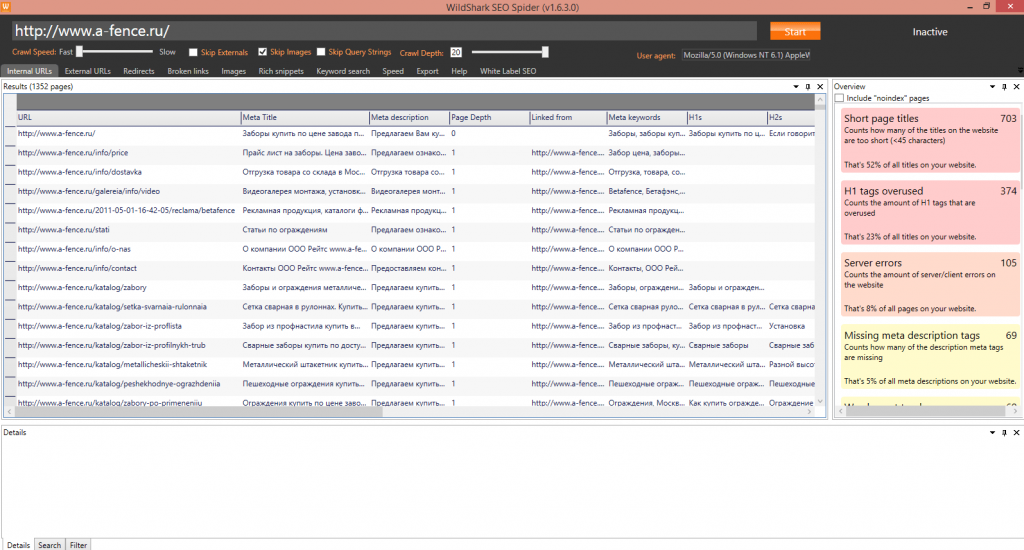

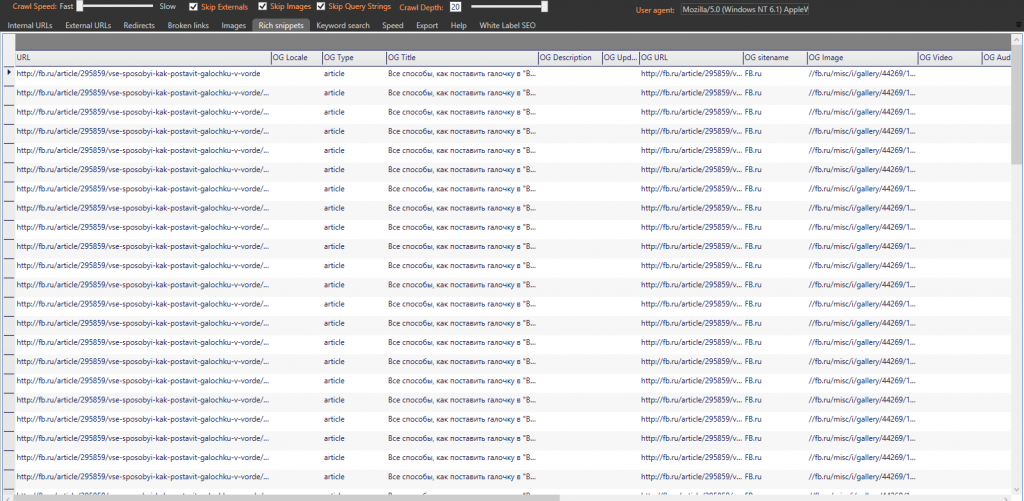

WildShark SEO Spider

WildShark SEO Spider – это бесплатный западный парсер, он очень простой и тем самым удобен. Имеет больше функций, чем Xenu’s Link Sleuth, но их всё же недостаточно. Парсер подойдёт для быстрой оценки технического состояния сайта, но для более детального анализа придётся искать другую программу.

Из особенностей можно выделить подсказки на правой стороне экрана, в которых указывается ошибка и общая информация о ней. Также инструмент может парсить OG микроразметку – это довольно редкая функция, которую не часто встретишь.

Спарсил сайт за 9 минут. Как для бесплатного парсера – это отличный результат.

Оценка: 9,5 баллов

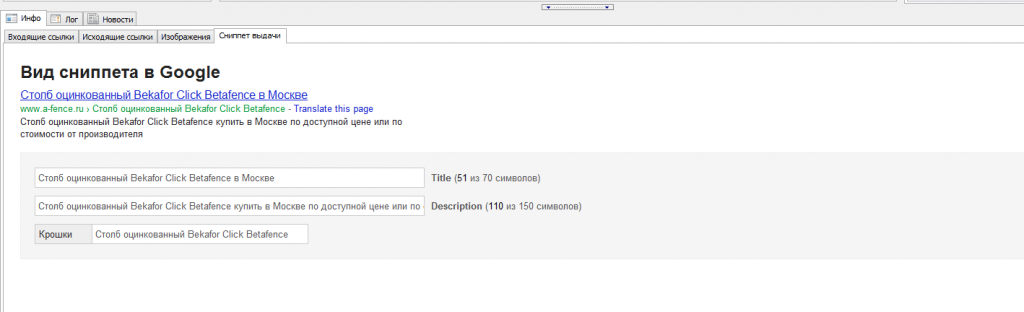

Majento SiteAnalayzer 1.4.4.91

Majento SiteAnalayzer 1.4.4.91 – довольно хороший и удобный бесплатный парсер отечественного производства. По функционалу заметно отличается от западных аналогов (в лучшую сторону). У программы есть 2 минуса:

- медленная скорость работы;

- не показывает количество заголовков H.

По моему мнению, это прекрасная замена платных аналогов. С его помощью можно детально проверить сайт и получить практически всю нужную информацию.

Он не может похвастаться большим количеством дополнительных функций, но они всё же есть. С помощью Majento SiteAnalayzer 1.4.4.91 можно:

- Сгенерировать Sitemap.

- Посмотреть структуру сайта.

- Посмотреть, как выглядит сниппет в Google.

Как я писал выше, у него «хромает» скорость работы. Инструмент спарсил наш сайт за 29:14 минут – это долго, но функционал покрывает этот недостаток. Не забываем, что программа бесплатная.

Оценка: 16,5 баллов

Выводы

В таблице ниже я сравнил каждый из парсеров по его функционалу, времени, потраченному на парсинг сайта, удобности и цене. По поводу функционала стоит уточнить: я сравнивал только по тем функциям, о которых писал в самом начале, то есть по обязательным.

| Парсер | Screaming Frog SEO Spider 9.2 | ComparseR 1.0.129 | Netpeak Spider 3.0 | Xenu’s Link Sleuth | WildShark SEO Spider | Majento SiteAnalayzer 1.4.4.91 |

| Функционал | ||||||

| Поиск битых ссылок | √ | √ | √ | √ | √ | √ |

| Указание входящих и исходящих ссылок страницы | √ | x | √ | √ | x | √ |

| Указание типа и цепочки редиректа | √ | √ (начальный и конечный URL) | √ | x | √ (начальный и конечный URL) | √ (начальный и конечный URL) |

| Возможность фильтровать страницы | √ | √ | √ | √ | √ | √ |

| Парсинг отдельных URL | √ | √ | √ | √ | x | x |

| Указание дублей Title, Description и заголовков H | √ | √ | √ | x | √(только заголовков H) | √ |

| Указание уровня вложенности | √ | √ | √ | √ | √ | √ |

| Указание заголовков H и их количества | √ | √ | √ | x | √ (только текст) | √ |

| Код ответа сервера | √ | √ | √ | √ | √ | √ |

| Возможность смены User Agent | √ | √ | √ | x | √ | √ |

| Title и его длина | √ | √ | √ | √ (только текст) | √ (только текст) | √ |

| Description и его длина | √ | √ | √ | √ (только текст) | √ (только текст) | √ |

| Keywords и его длина | √ | √ | √ | x | √ (только текст) | √ |

| Canonical | √ | √ | √ | x | √ | √ |

| Meta robots | √ | √ | √ | x | x | √ |

| Alt, его длина и размер | √ | √ | √ | x | √ (длину не показывает) | √ |

| Тип контента | √ | √ | √ | √ | x | √ |

| Оценка функционала | 17 | 16,5 | 17 | 8 | 9,5 | 16,5 |

| Время сканирования | ||||||

| 03:00 | 02:56 | 05:00 | 17:59 | 09:00 | 29:14 | |

| Удобность | ||||||

| 3 | 4 | 5 | 4 | 4 | 4 | |

| Стоимость * | ||||||

| 149£/год | 2000 руб | 14$/в месяц | Бесплатно | Бесплатно | Бесплатно | |

* Указана стоимость подписки на момент написания статьи без учёта скидок и акций.

Каждый из представленных парсеров по-своему хорош. Некоторые не сильно отличаются друг от друга, другие более узконаправленные. Однозначно сказать, какой из парсеров самый лучший – нельзя, но распределить их можно.

Среди платных инструментов конкурируют Netpeak Spider и Screaming Frog SEO Spider. У этих парсеров большой функционал, который в полной мере покрывает все потребности, но стоит отметить, что их цена далеко не маленькая.

ComparseR имеет не меньший функционал и вполне отлично справляется с техническим анализом сайта. С его помощью можно узнать, какие страницы в индексе, что тоже немаловажно. Цена парсера – всего 2 тыс. рублей.

Среди бесплатных парсеров однозначно лидирует Majento SiteAnalayzer. Его функционала достаточно для анализа сайта, единственный и главный минус – длительное время парсинга.

Еще по теме:

- Руководство по установке и настройке Google Tag Manager для новичков Предлагаем вашему вниманию пошаговую инструкцию по установке и настройке Google Tag Manager (GTM). Здесь же мы расскажем, как с помощью GTM подключить Google Analytics и...

- Как провести аудит ссылочной массы сайта с помощью Ahrefs Преимущества и недостатки Ahrefs, доступные инструменты, детальный разбор возможностей и советы по анализу ссылочной массы вашего сайта и сайтов конкурентов. Читайте в статье, как проанализировать...

- Excel для SEO. Основы с примерами Часто на решение ряда SEO-задач у начинающего специалиста уходит неоправданно много сил и времени. Зная о возможностях Excel в применении к SEO, вы сможете оптимизировать...

- Операторы поиска Google для SEO: лайфхаки, которые 100% работают Символы для фильтрации запросов Команды поиска по сайту Поиск на сайте site: Кэш сайта cache: Точный поиск по вхождениям ключевых слов Вхождения в заголовок intitle:...

- Когда целесообразно проводить A/B тестирование и какие инструменты использовать? Подскажите, надо ли при обновлении страницы сайта (добавлении, удалении блоков, изменение структуры страницы) проводить ab тестирование? Если да, то насколько оно необходимо? И какие инструменты...

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

(23 оценок, среднее: 4,91 из 5)

(23 оценок, среднее: 4,91 из 5)

забыли сказать что лягушка фактически бесплатна, если вы понимаете о чем я)

лягушку юзаю. 9.2 версия огонь!

А что скажете по поводу seopowersuite и их парсере webauditor?

Отличный пост!

нетпик и компарсер вместе веселее 🙂

Спасибо за сравнение. По поводу Comparser вопрос. Например у меня есть сайт 500 страниц. Я запустил парсиг, спарсил 500 страниц, запустил анализ индекса в Яндексе и Google и получил некоторые данные. Зачастую, парсер показывает что страницы нет в индексе, а она на самом деле есть и наоборот. Показывает что в индексе, а на самом деле ее нет. Как можно при помощи программы узнать точные данные и не перепроверять их?

Добрый день, Александр. Можете привести более детальный пример, а еще лучше дать ссылку Вашего сайта. Так как программа Comparser, все довольно точно определяет. Но можете попробовать сделать следующие: сначала запустите проверку индексации, с параметром «Сортировка выдачи по» релевантности http://take.ms/xgRtf , а затем повторите, но уже не по релевантности а по дате. Когда будете запускать повторно, обязательно надо сохранить результаты первой проверки и не стирать их. Такой способ должен помочь собрать больше проиндексированых страниц.

Спасибо, попробую ваш способ на нескольких сайтах.

Увы ничего сказать не могу, в ввиду того, что им никогда не пользовался.

Да, Вы правы. Есть возможность пользоваться данной программой бесплатно двумя вариантами. Либо использовать бесплатную версию, которая ставит ограничение на 500 url, и невозможность менять настройки. Либо есть второй способ, но это уже пиратство.

Думаю на пост советском пространстве пиратством никого не испугаешь.

А что делаете с помощью ComparseR в этой связке? 😉

Подскажите пожалуйста, а который лучше подойдет для парсинга и сбора цен, например портала недвижимости.

Почему то нет прог, которые нагуглил : Datacol A-parser content downloader X

Они уступают вашим топам?

Собрать данные контента на страницах сайта (например цены как в Вашем случае), с помощью представленных парсеров не получится. С помощью них, можно найти разве что, только страницы на которых встречается определенный код, либо текст.

Парсеры которые Вы перечислили, имеют другой тип, они более предназначены для парсинга контента, по этому мы их не рассматривали вообще. И сравнивать их нельзя.

Спасибо за прояснение

Благодарю за упоминание в обзоре SiteAnalyzer! )

Надеюсь, в 2019 году мы сможем порадовать пользователей новыми фишками и выйти на новый, более качественный уровень работы!

Спасибо за классную подборочку, очень полезно) поняла, что нужно пробовать компарсер)

Хочу добавить, что существуют еще телеграм-боты парсеры. Например parseron_bot. Собирает контакты организаций в справочнике.