В мае 2019 года к нам обратился крупный образовательный портал в Европе, США и Канаде – smapse.com.

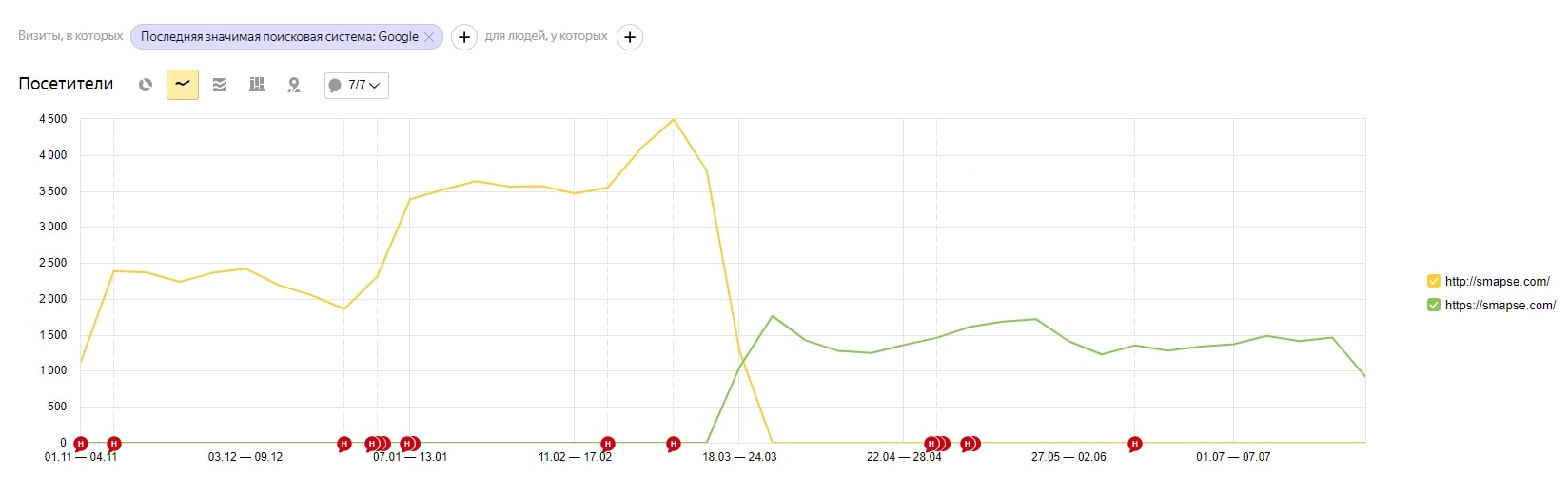

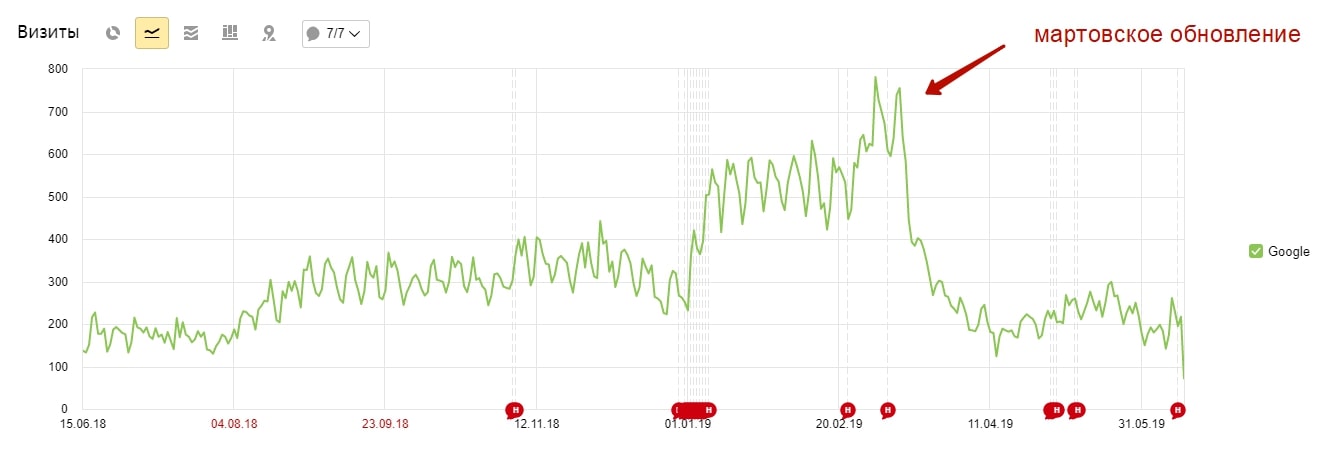

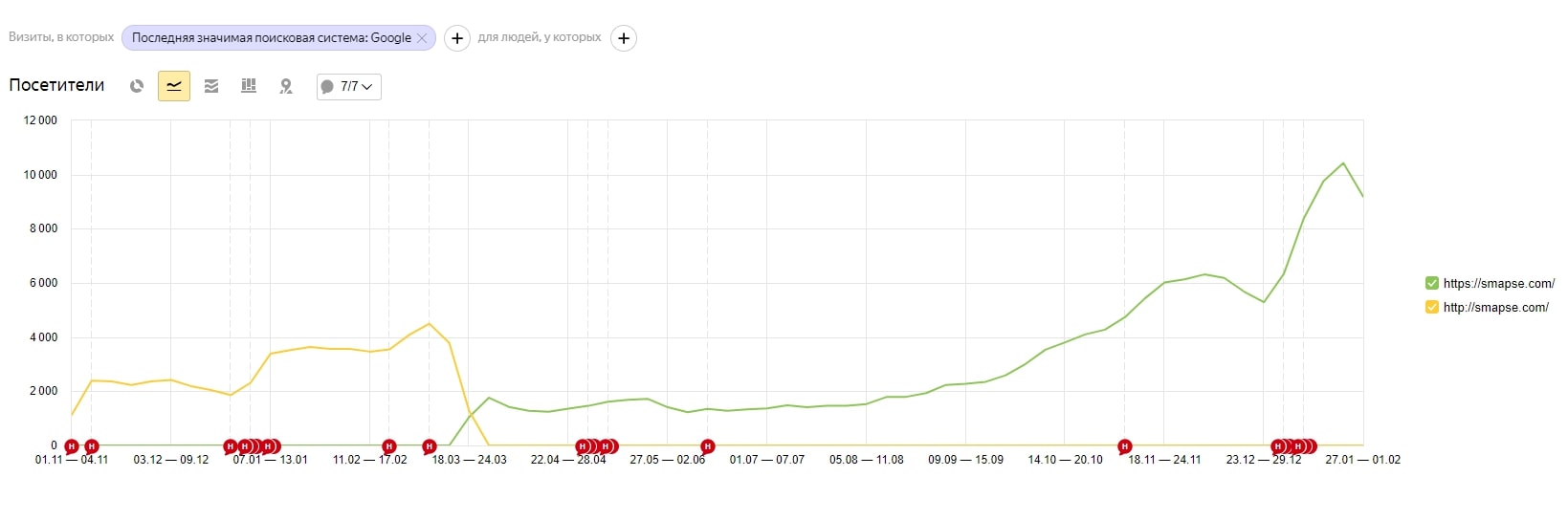

Проблема: просадка трафика после переезда на https в середине марта 2019 года.

Цель: вернуть трафик – нужно найти ошибки, из-за которых произошла просадка, и написать рекомендации по их исправлению.

Учитывая вводные данные, клиенту был предложен технический аудит сайта после переезда с рекомендациями по исправлению ошибок, которые:

- Были допущены во время переезда и могли негативно отразиться на склейке.

- Были не критичными с точки зрения работоспособности и обхода сайта ботами, но могли замедлить склейку зеркал.

Дополнительно проводился анализ логов, чтобы понять, как googlebot сейчас обходит страницы, нет ли мусорных страниц, дополнительных перенаправлений, которые расходуют краулинговый бюджет, что замедляет склейку.

Предыстория

Сайт был переведён на https-протокол в середине марта 2019 года. После этого трафик упал примерно в 2–2.5 раза.

По словам клиента, переезд происходил следующим образом: в один день поставили протокол, сделали все редиректы внутри сайта, заменили robots.txt, Sitemap.xml, сделали переезд сайта в Яндекс.Вебмастере и Google Search Console.

Что анализировали

Технический аудит имел 2 основных направления:

- Поиск ошибок, которые влияют на индексирование страниц и с большей долей вероятности привели к снижению трафика после переезда.

- Работа с оптимизацией краулингового бюджета – поиск дыр, в которые он сливается вместо того, чтобы быстрее обойти и склеить нужные страницы.

Также были указаны другие технические недочёты, которые не мешало бы поправить.

Весь пул ошибок был условно разделён на 3 приоритета:

- Приоритет 1

Влияют на индексирование страниц и с большей долей вероятности привели к снижению трафика после переезда. Реализация крайне важна для продвижения сайта. Нужно внести правки в первую очередь.

- Приоритет 2

Реализация доработок также важна, но их можно отложить и внедрить после внесения правок из первого пункта.

- Приоритет 3

Реализация этих доработок желательна, внедрить после внесения правок из первых двух пунктов.

Разделяя рекомендации таким образом, сразу даём понимание, на что потратить усилия в первую очередь. В аудитах мы расставляем приоритеты в зависимости от задачи и количества затронутых страниц. Поэтому для разных сайтов в разрезах разных проблем один и тот же тип ошибки может попасть в разные приоритеты на исправление. Например, ошибка такого типа «мусорные страницы обходятся ботами и попадают в индекс, несмотря на блокировку в robots.txt» могут попасть:

- в приоритет 1 – если их много (составляют половину и более от страниц сайта) и за счёт их обхода тратится большая половина краулингового бюджета;

- в приоритет 2 – если они составляют около половины и меньше страниц сайта, видим постоянный рост, но есть более важные задачи, которые с большей долей вероятности принесут положительный результат после исправления (банально – настройка 301 после смены протокола);

- в приоритет 3 – если их немного (находятся в пределах одной небольшой папки), нет роста совсем или волнообразная динамика.

Поэтому не удивляйтесь, если увидите, что какие-то серьёзные по звучанию ошибки не попали в первый приоритет. Индивидуальный подход – он такой 🙂

Приоритет 1

Среди ошибок, исправление которых, по нашему мнению, имело наивысший приоритет, были:

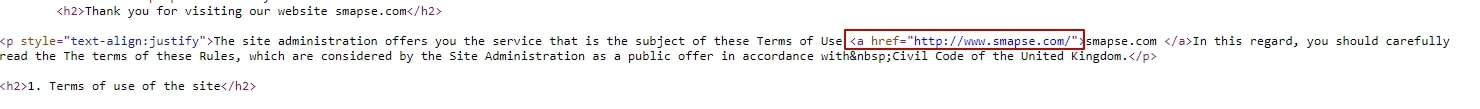

- Ссылки на http-протокол

Так как изначально URLs с абсолютных не были переведены на относительные, на сайте ещё оставались ссылки на страницы на http-протоколе.

- Страницы с 404 кодом ответа сервера

На сайте таких было 2 типа:

- С некорректной кодировкой (в URL есть скрытые символы, которые кодируются как %E2%80%8B%E2%80%8B, или недопустимые символы, например, «’».).

- Находятся по другому адресу, но не был настроен 301 редирект. Вторые вели со статей, и по структуре их URL можно понять, что страницы с аналогичным контентом были не просто удалены, а находятся по другому адресу.

- Ошибка в теге hreflang

У сайта, кроме английской, есть русская версия, на которую настроен тег hreflang. Однако во время аудита он был настроен некорректно.

По факту мы таким образом говорили боту, что страница на английском является её же версией на русском. Кроме того, русская версия также не содержала ссылку на английскую, а ссылалась сама на себя.

Рекомендации по настройке hreflang от Google.

Рекомендации по реализации hreflang от Яндекса.

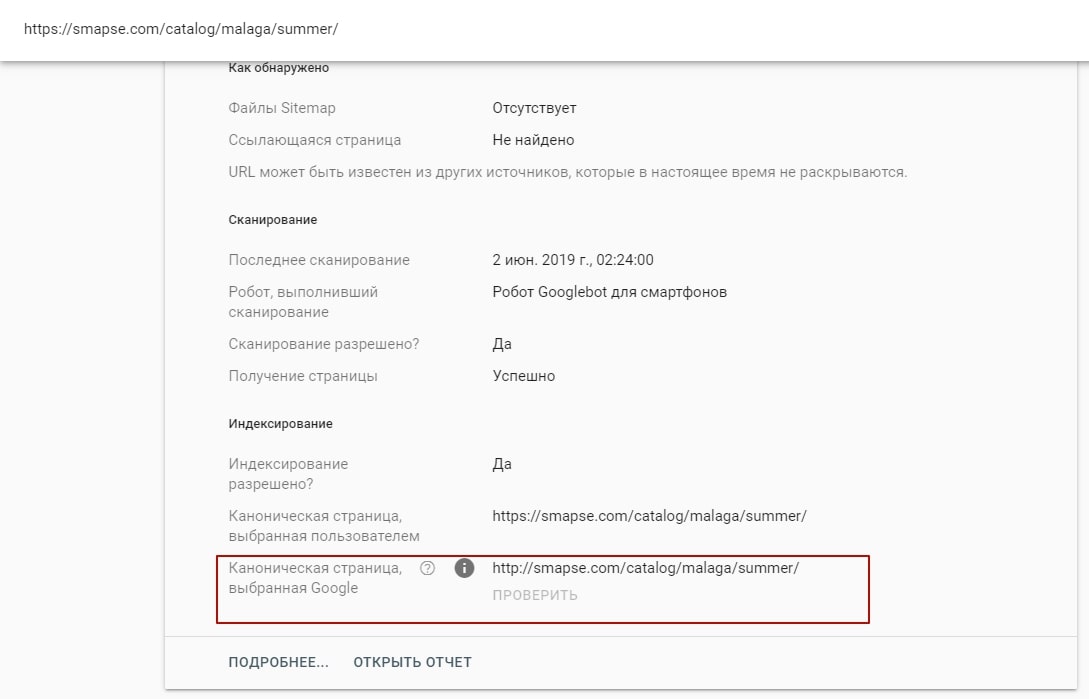

- Страницы на https исключались из индекса как копии (по данным Google Search Console)

Google удалял из индекса страницы с https-протоколом и выбирал в качестве канонических страницы на http.

Первое, что мы предположили – возможна некорректная настройка 301 редиректа.

После проверки ответов серверов и анализа динамики по страницам на http-протоколе эта теория была откинута.

Поэтому было предложено, как ускорить переиндексацию:

- Для страниц, использующих HTTP и HTTPS, сделать разные файлы robots.txt и Sitemap.xml (Справка Search Console).

Включить в один файл Sitemap адреса всех страниц, использующих HTTP, а во второй файл – адреса всех страниц, использующих HTTPS, независимо от того, выполняется ли на этих страницах переадресация. Благодаря этому поисковые боты быстрее просканируют новые страницы.

- Ускорить сканирование сайта вручную. Для этого добавить URL на переобход в Google Search Console – по нашему опыту, работа монотонная, но эффективная.

P.S.: для тех, у кого толковые программисты – можно автоматизировать с помощью скрипта (у нашего клиента как раз такие и работали).

Приоритет 2

- Смысловые дубли

На сайте есть страницы, которые по смыслу дублируют друг друга. Большинство этих страниц содержит дополнительную цифру в URL.

Несмотря на то что их контент может быть уникальным (разные описания, предложения), они отвечают на одинаковые запросы.

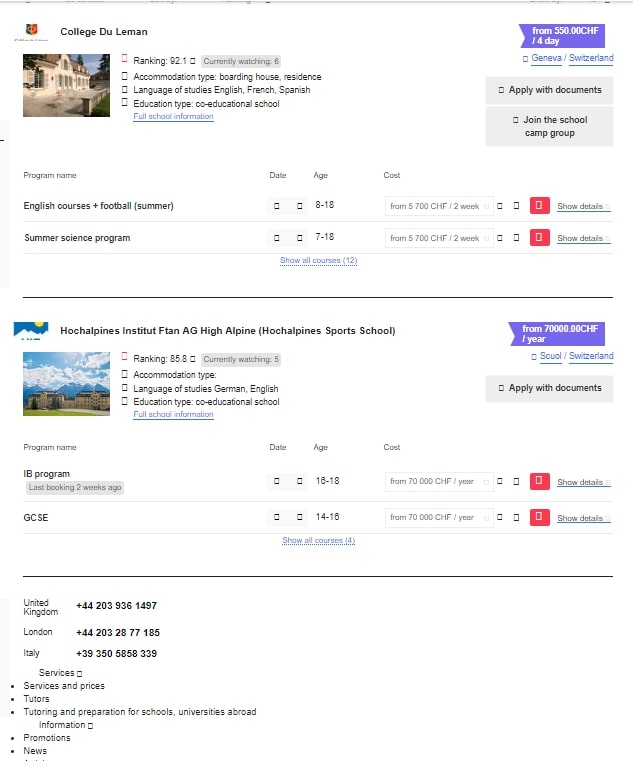

- Предложения, реализованные с помощью JavaScript, со скрытыми ссылками

Такая реализация давала плюс в Google раньше – позволяла не разбавлять частотность ключей, а также для того, чтобы SEO-текст в блоках школ выделялся из остального контента.

Сейчас на страницах листингов поисковый бот видел только первые два предложения, несмотря на то, что по факту их были десятки.

Пример сохранённой копии листинга.

При анализе конкурентов отметили, что они не скрывают свой листинг.

Такая реализация сейчас нас насторожила:

- Мы показываем боту и пользователям разный контент, чего не очень любит Google.

- Страницы, на которые нет ссылок, медленнее переобходятся и, соответственно, склейка происходит медленнее – их нужно находить из других источников.

- Листинги содержат меньше предложений, а значит, уступают конкурентам. Этот пункт больше относится к стратегии внутренней оптимизации, однако мы постоянно отталкиваемся от цели клиента – вернуть трафик.

Учитывая вышесказанное и то, что при такой реализации сайт до переезда получал неплохой трафик, в качестве эксперимента было предложено показать роботу Google все предложения учебных заведений. Для этого ссылки, которые подгружаются скриптом, выводить с помощью html.

- Ссылки с 301 редиректом

На сайте были ссылки на страницы, URL которых был заменён. С точки зрения технической реализации – всё сделано правильно: настроен 301 редирект на новые страницы. Однако на сайте остались ссылки на страницу по старому адресу. Они тратили дополнительный краулинговый бюджет, что было важно для нас, однако таких ссылок было немного. Поэтому они попали во второй приоритет, а не в первый.

Приоритет 3

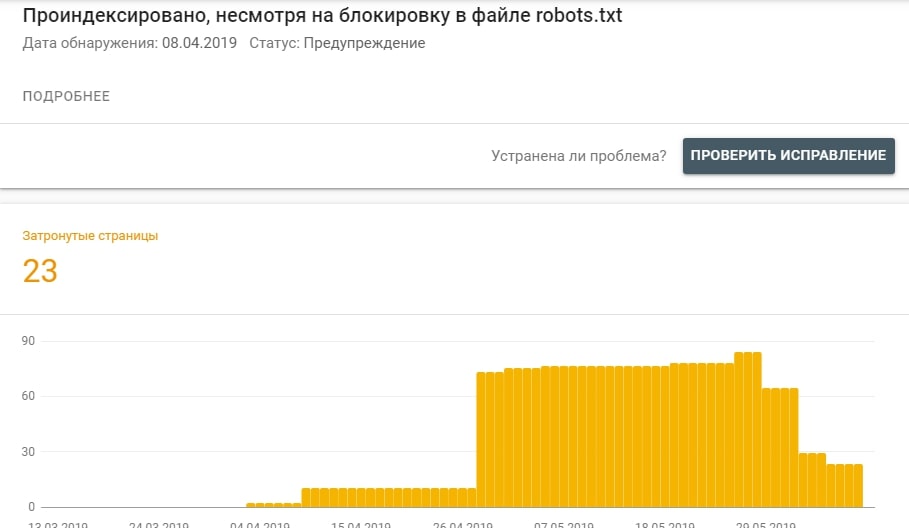

- Мусорные страницы, заблокированные в robots.txt, обходятся ботами и попадают в индекс

В результаты поиска начали попадать страницы, заблокированные в файле robots.txt.

С одной стороны, это критичная ошибка, но с другой – таких страниц было немного, их рост был ограничен, количество уже начало снижаться.

Почему так происходило: robots.txt – это рекомендация, а не правило для поисковых систем. Роботы могут обходить страницы, даже несмотря на их блокировку с помощью Disallow.

- Дубликаты метаданных

На страницах сайта дублируются H1. При этом некоторые варианты, например, «Description: Primary school» встречается сразу на 98 страницах.

Порекомендовали заменить общие заголовки на более частные, которые описывают, что находится на странице.

Что дал анализ логов

С самого начала аудита мы запросили логи сайта для анализа, чтобы посмотреть, как боты обходят страницы, нет ли дыр, в которые сливается краулинговый бюджет. Однако мы нашли даже больше, чем ожидали увидеть, и были на 100% уверены, что именно там корень проблемы.

Чтобы сложилось полное представление, что мы обнаружили, начнём с того, что на сайте есть два типа страниц:

- Страница каталога с программой и списком вузов, которые предлагают эту программу для изучения.

- Страница с описанием этой программы именно у конкретного учебного заведения.

Они были очень похожи – одинаковая шаблонная часть, полностью или частично дублирующийся контент (как уникальность контента влияет на продвижение). Основная проблема возникала, когда программа предлагалась только одним вузом. В таком случае контент был идентичным, за исключением метаданных.

Мы заранее уточнили эту информацию у клиента, и так как она была больше в разрезе внутренней оптимизации, и такой подход не мешал сайту чувствовать себя хорошо, не стали глубоко копать до момента, когда открыли файл с логами.

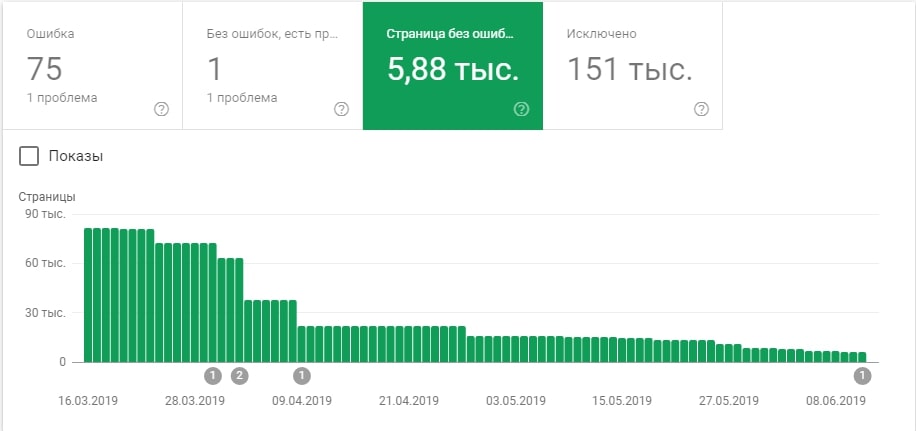

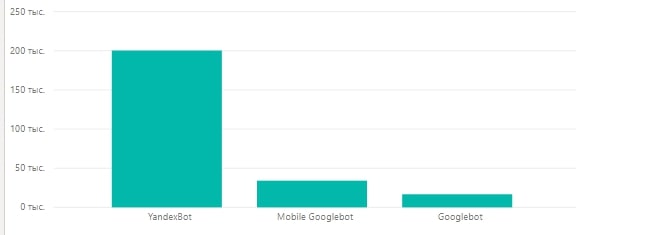

Сразу было видно, что боты Google обходят сайт в 4 раза реже, чем боты Яндекса.

Выясняя, что же не так, заметили такую закономерность: Googlebot обходит только одну-две из страниц с похожим контентом, на остальные за анализируемый период он ни разу не заходил.

Было хорошо видно, что Google не нравятся такие страницы, и он перестаёт их обходить. Это влияет на скорость обхода сайта (бот реже ходит, страницы дольше склеиваются), на оценку качества сайта в целом и, как результат, на позиции и трафик. Кроме того, для обхода не всегда выбиралась более приоритетная для продвижения страница-листинг.

Из практики знаем, что важно не количество страниц в целом, а количество качественных страниц. Дубли таковыми не являются. Большое количество низкокачественных страниц, наоборот, негативно влияет на общую оценку качества сайта.

Учитывая это и то, что страниц, которые нужно уникализировать, было много (да и было не очевидно, что потраченные усилия окупятся), мы порекомендовали быстрый способ устранить проблему – настроить rel= «canonical» на основную продвигаемую страницу.

Сюрприз

Во время анализа основных метрик сайта мы заметили, что переезд совпал с выкаткой March 2019 Core Update.

Поэтому сходу решили немного сместить вектор с чисто технического, на технический + рекомендации по улучшению качества контента.

Основная мотивация этого решения – клиент пришёл не просто исправить технические недочёты на сайте, а вернуть трафик. Именно основная цель аудита и желание её достигнуть в итоге стали движком к дополнительному анализу страниц, которые просели и выросли на самом сайте, и их сравнению с конкурентами, занявшими при этом ТОПовые позиции. Что делало рекомендации по работе над качеством контента, даже в разрезе технического аудита, максимально логичными и такими, что соответствуют цели клиента.

Кроме того, по нашему опыту, улучшение контента параллельно с исправлением технических ошибок увеличивает вероятность роста трафика.

Среди рекомендаций по работе с качеством контента были следующие:

- Расширить Education information на категорийных страницах

По запросам, которые шли на категорийные страницы и больше всего просели, была смешанная выдача: были как сайты, которые предлагают обучение за рубежом, так и информационные статьи.

Поэтому мы порекомендовали:

- Расширить описание категорий страниц за счёт пунктов, которые могут быть полезны пользователям. Для примера с «boarding schools in france» это может быть: преимущества получения образования во Франции, каким образом там построено обучение, что важно знать родителям и их детям.

- Добавить в текст дополнительные вхождения, которые касаются тематики страницы и по которым она показывалась в поиске.

Такие можно найти в Google Search Console – отчёт «Эффективность», указываем URL и смотрим вкладку «Запросы».

- Добавить видеообзор в описание

Это позволило бы увеличить вовлечённость и улучшить взаимодействие пользователей с сайтом.

- Добавить ссылки на официальные сайты

Эта рекомендация была дана в качестве эксперимента. С одной стороны, Google оценивает качество сайтов не только по входящим ссылкам, но и по исходящим, с другой стороны, были кейсы как позитивного, так и негативного влияния внешних ссылок на продвижение сайта.

Заключение

В результате проведённого анализа, оперативного внедрения рекомендаций на стороне клиента, а также тесного взаимодействия во время внесения правок между нашими командами (внедрение и сразу проверка реализации, постоянное общение по правкам), мы получили следующий результат:

Первый рост заметили спустя 2,5 месяца после реализации правок. Положительная динамика закрепилась, остальные обновления Google не оказали негативного влияния на трафик сайта.

Бывает, что при переезде сайты теряют трафик, и он не восстанавливается длительное время. В таком случае основная задача – исправить все ошибки, которые могут повлиять на склейку страниц, и ускорить переиндексацию. А технические правки+улучшение контента – 100% заявка на ТОП в Google.

Хотите так же увеличить трафик? Обращайтесь к нам!↓

Еще по теме:

- Кейс: как мы продвинули в ТОП Яндекса сайт услуг в высококонкурентной нише в Москве Клиент зашёл с задачей «вывести сайт в ТОП по высококонкурентным для тематики фразам». До этого сайт продвигался и были результаты, но по основным продающим ключам...

- Кейс: как мы продвинули молодой сайт в ТОП-10 Яндекса с помощью комплексного SEO Рассказываем, как вывели сайт в ТОП Яндекса за 2 месяца по СЧ- и НЧ- запросам. Пример комплексного и потому успешного подхода к сайту. Если у...

- SEO-кейс: как увеличить органический трафик с 14k до 36k пользователей в месяц За 11 месяцев работы мы увеличили трафик сайта медицинской тематики на 255%. В статье расскажем о подводных камнях работы с семантикой, а также о том,...

- SEO-кейс интернет-магазина: как мы увеличили трафик на +90к после неудачного переезда на новую CMS Содержание: Преамбула Задача, поставленная клиентом Что было сделано, подводные камни и результаты 2018 год Первый квартал Второй квартал Третий квартал Четвёртый квартал 2019 год Первый...

- Кейс: как вывести сайт из-под фильтра Яндекса за рекламу, которой на самом деле нет В нашу компанию участились заявки на вывод из-под фильтра Яндекса за назойливую рекламу. Их особенность в том, что владельцы ресурсов и веб-мастера не понимают, о чем идет...

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

Кейс достойный

Очень любопытно.

PS. Частенько глючат картинки на вашем сайте (не загружаются). В чем может быть проблема?

Хороший кейс. Молодцы