- Ирина Ш.

- 10 минут

- Анализ события

Пока в Google опять штормит, мы изучаем все доступные на данный момент исследования, из которых можно почерпнуть идеи для оптимизации. Сегодня расскажем об одной самой интересной.

Мэри Хейнс (SEO-эксперт с 12-летним опытом и автор для блогов MOZ и SEW) проанализировала влияние январского обновления Google на клиентских проектах и поделилась наблюдениями.

- Основные выводы

- Партнёрским сайтам нужно помечать ссылки

- Делайте контент значительно лучше конкурентов

- Обратите внимание на новые признаки траста

- Учтите, что Google усилил требования для сайтов о здоровье животных

- Спамные сайты не индексируются

- Советы сайтам, пострадавшим от January 2020 core update

Обновление было официально анонсировано 13 января в твиттере Google, так что его влияние ощутили многие сайты.

Среди подопытных у Мэри были сайты под партнёрки, медицинские и ветеринарные, то есть в основном — YMYL-контент.

Основные выводы

- Пострадали сайты на партнёрках, которые не помечали должным образом рекламные ссылки.

- Google вознаградил действительно хороший контент (лучший из лучших).

- Некоторые из признаков надёжности сайта (так называемый «trust» из инструкции для асессоров) были скорректированы и переоценены.

- Требования к качеству контента о здоровье животных значительно возросли.

- Много спамного контента было удалено из индекса (вернее, перестало индексироваться).

А теперь рассмотрим каждый случай по порядку.

Партнёрским сайтам нужно помечать ссылки

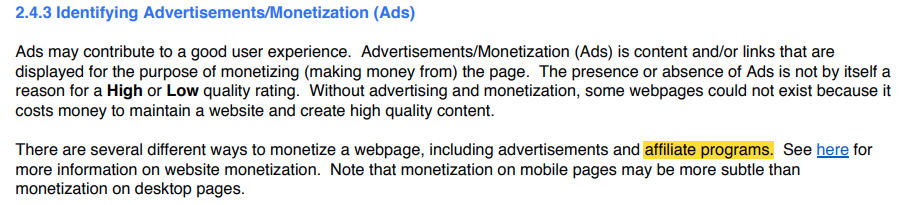

Google не против партнёрских ссылок, ведь создание и поддержание высокого качества контента требует вложений и соответственно монетизации. Тем более что в инструкции говорится:

«Наличие или отсутствие рекламы само по себе не является причиной высокой или низкой оценки качества».

То есть партнёрские ссылки поисковик считает одним из видов рекламы, и на них накладываются всё те же ограничения. Например, рекламные ссылки, чтобы не вводить пользователя в заблуждение, должны быть помечены ярлыком «реклама» или иметь всплывающее при наведении мышки пояснение (добавляется атрибутом title к тегу <a>).

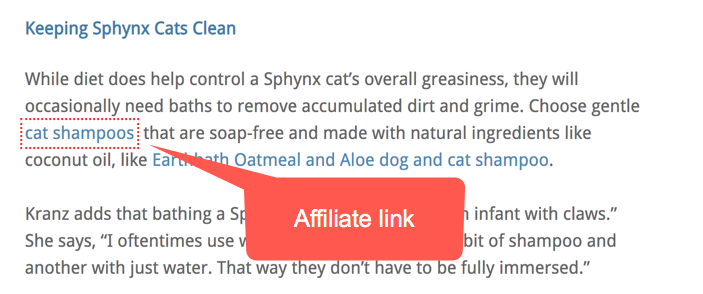

Мэри отмечает, что в её выборке действительно на многих пострадавших сайтах партнёрские ссылки ничем не выделялись.

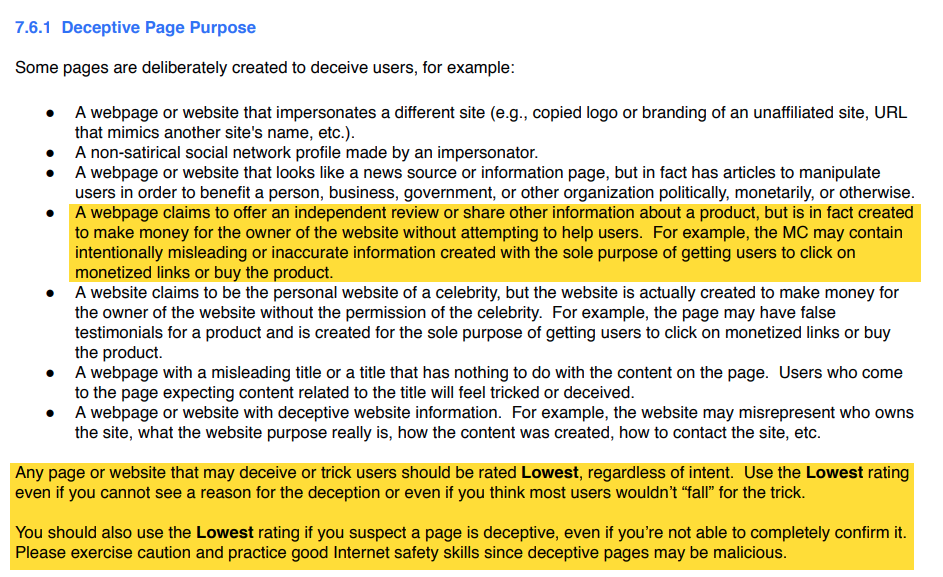

Кстати, в инструкциях Google есть целый раздел про страницы, обманывающие пользователей, и им присваивают самую низкую оценку качества. Среди таких значатся и сайты, созданные только для прибыли владельца, которые предоставляют заведомо ложную или неточную информацию.

Например, к таким отнесут статью с обзором хостингов, в которой рекомендуют только те компании, у которых партнёрский процент больше.

В случае Мэри на некоторых пострадавших сайтах были хорошо написанные тексты и пометки о партнёрстве вверху или внизу статьи, например:

«Контент содержит партнёрские ссылки. Если вы перейдёте по ним и совершите покупку, мы получим маленький процент от продаж».

Но большинство читателей не смотрит на них, люди сканируют страницу в поисках релевантного отрывка и читают только его.

Допустим, у вас страница с рецептом пирога с таким предложением:

«В приготовлении мне нравится использовать этот блендер. Он действительно лучший из всех, что я пробовала».

Поймёт ли неискушённый пользователь, что ссылка на слове «блендер» рекламная и ведёт на Amazon? Вряд ли.

С другой стороны, партнёрские сайты, позиции которых выросли после обновления, имели:

- Пояснение в тексте, что пользователь попадёт на другой сайт с возможностью купить товар, например:

«В приготовлении мне нравится использовать этот блендер, который вы можете купить на Amazon. Он действительно лучший из всех, что я пробовала».

- Официальный виджет от партнёрки. Здесь тоже нет обмана для пользователя, ведь он знает, куда попадёт при клике.

- Пометку о рекламности на ссылках. Можно выводить пометку поп-апом через скрипт или вовсе вынести ссылки в отдельный спонсорский блок. Этого не было в исследуемых Мэри сайтах, но в теории должно сработать.

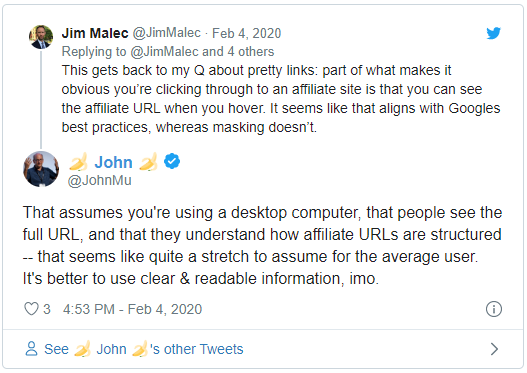

При этом представитель Google Джон Мюллер посоветовал не использовать ссылки с редиректом, например, когда yoursite.com/go/product ведёт на amazon.com/product?affid=your-affiliate-id, так как это тоже не совсем очевидный путь для пользователя.

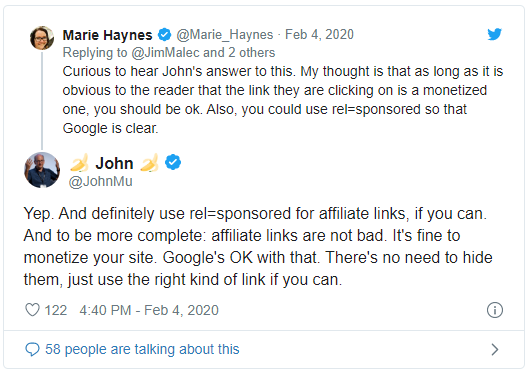

Также Джон рекомендует помечать все партнёрские ссылки атрибутом rel=sponsored.

Если вы сейчас подумали, что пользователи перестанут кликать на ваши ссылки, если помечать их явно рекламными, то не зря читаете эту статью. Ведь если они переходят только по хитро замаскированным ссылкам, ваши действия можно расценивать как обман пользователей, и это надо исправлять. Согласитесь, ведь в примере с блендером мало что поменялось после партнёрской пометки, но асессоры и алгоритмы такое ценят.

Делайте контент значительно лучше конкурентов

Мэри заметила улучшения на нескольких сайтах, которые, кстати, не были партнёрскими и имели лучший в своём роде контент.

Это контент, который отвечает на все актуальные вопросы по теме так, что он легко читается и подзаголовки легко сканируются глазами.

Но не нужно бежать и писать лонгриды для каждой своей страницы, если только это не тот тип контента, который хотят видеть пользователи. Определиться поможет анализ выдачи. Посмотрите на конкурентов по запросам, в которых отстаёте, и проанализируйте, действительно ли их сайты полезнее.

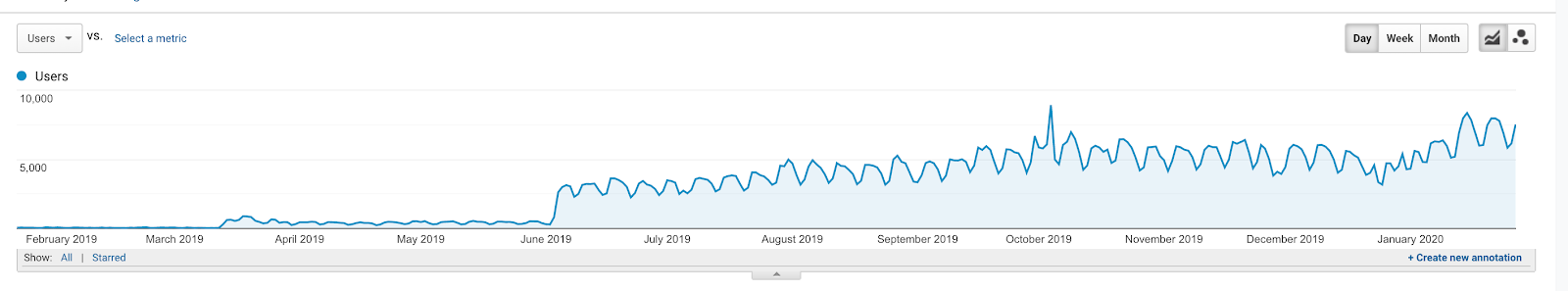

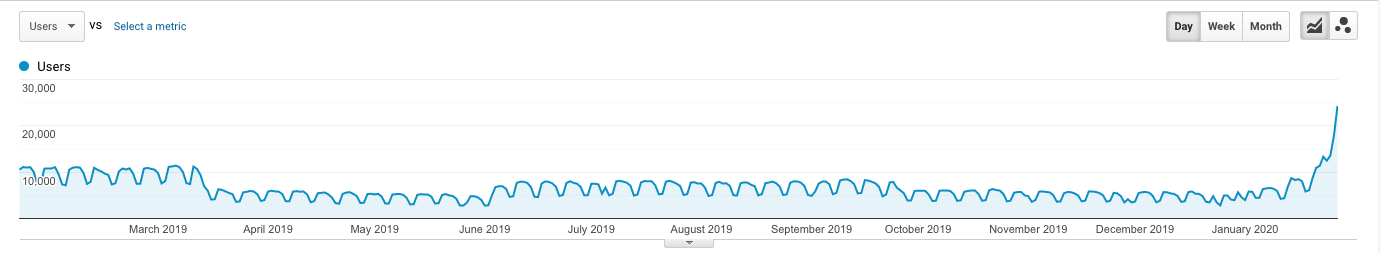

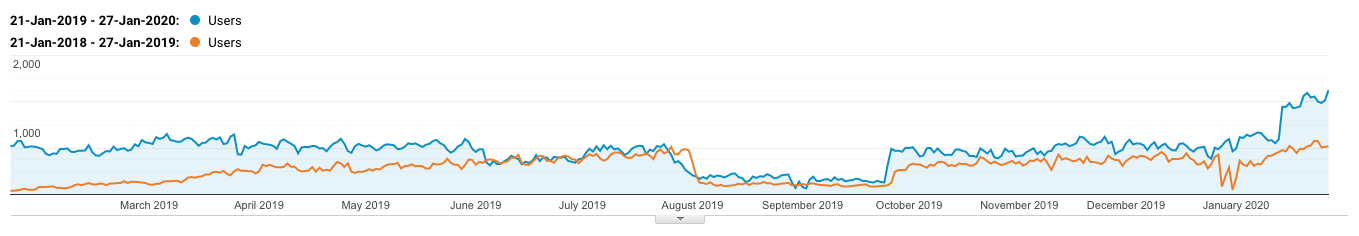

Мэри приводит скриншот трафика медицинского сайта, который выиграл как после июньского, так и после январского апдейта.

Контент для того медсайта писался и проверялся экспертами-докторами с опытом в соответствующей области медицины. Google заценил такое обилие неочевидных деталей и точность.

Но контент — это ещё не всё. Даже сайт с лучшим в мире контентом может страдать из-за неразвитой репутации, раздражающей рекламы, отсутствия контактной информации и т. д.

Google приводил несколько вопросов, которые помогут улучшить контент:

- Есть ли в контенте оригинальная информация, отчёты, исследования и анализ?

- Раскрывается ли тема в нём полно и исчерпывающе?

- Есть ли глубокий анализ или неочевидная информация?

- Если контент опирается на другие источники, то насколько он отличается от них и добавлена ли в него ценность?

Обратите внимание на новые признаки траста

Вот примеры трастовых сигналов, которые повлияли во время январского обновления:

- Актуальность YMYL-контента.

- Использование авторитетных и надёжных источников (в виде ссылок и цитат) в контенте YMYL.

- Прозрачная информация о методах монетизации.

- Чётко различимый спонсорский/партнёрский контент.

- Хорошая репутация в интернете.

- Негативно повлияли практики, когда сайт маскируется под официальное представительство какой-то организации, но на самом деле не является их партнёром.

Один из сайтов Мэри вырос как раз за счёт работы над репутацией. У компании было много негативных отзывов насчёт доставки и возврата товара, и они решили исправить это не просто за счёт SEO, а действительно улучшить свои бизнес-процессы.

Жалоб стало меньше, а довольных клиентов — больше.

Но ещё важно, что они переработали контент сайта, убрав кучу малополезного и улучшив оставшийся, особенно тот, что виден пользователю сразу на первом экране.

Вот ещё один пример комплексной работы над трастовостью медицинского сайта: переработали контент, уменьшили количество противоречащего общепринятому научному подходу и сделали монетизацию понятнее.

Учтите, что Google усилил требования для сайтов о здоровье животных

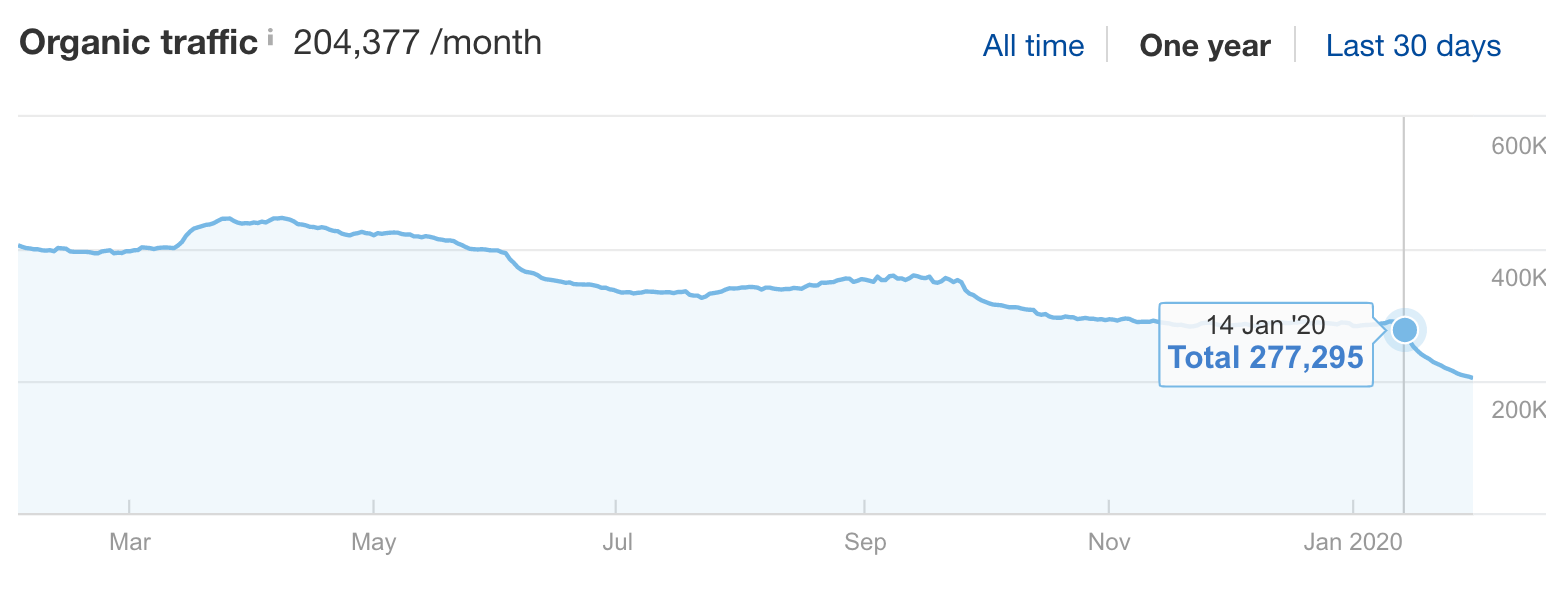

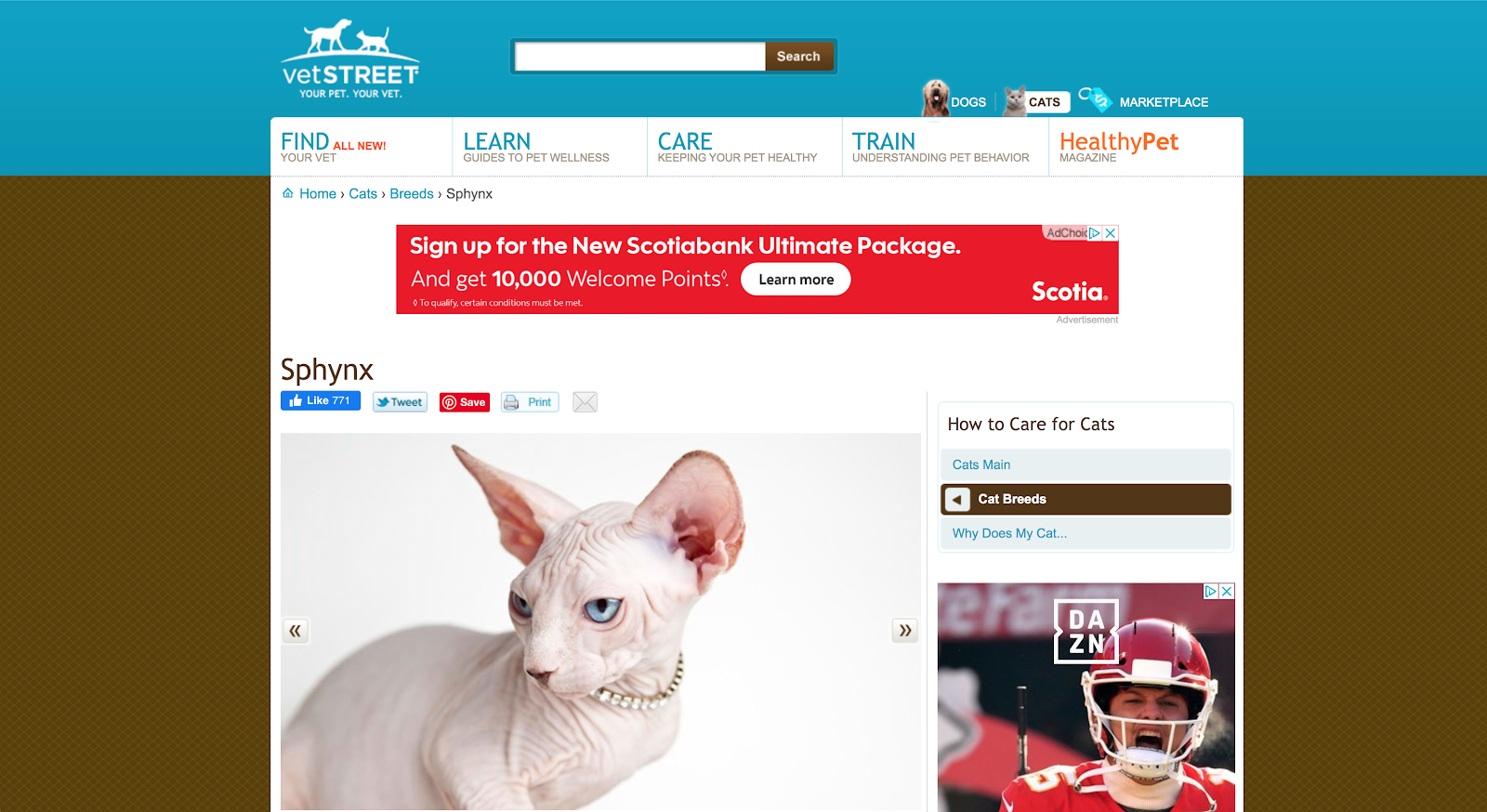

Несколько сайтов ветеринарной тематики одновременно ощутили спад после 14 января 2020 года, что видно по графикам из ahrefs. Вот несколько из них:

- поддомен healthypets.mercola.com

- Vetstreet.com

- Pethealthnetwork.com

Анализ показал, что многим просевшим статьям не хватало E-A-T: не было научных источников, статьи не обновлялись годами, и не было доказательств, что авторы этих статей авторитетны в ветеринарии.

Некоторые статьи были не совсем медицинские и описывали общие вопросы, такие как особенности одной породы кошек.

А партнёрские ссылки не были никак обозначены.

Спамные сайты не индексируются

Аналитик Google Гари Илш даже пошутил на эту тему:

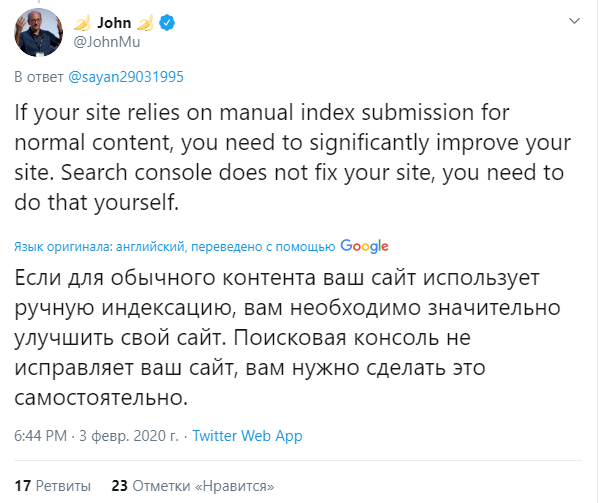

Обычно после обновлений алгоритма сайты понижаются, а не удаляются из индекса, но в этот раз многие вебмастера стали жаловаться, что их новый контент вовсе не индексируется. Представитель Google Джон Мюллер заверил, что проблем с индексацией со стороны поисковика нет, то есть пенять можно только на себя. Чуть позже он высказался ещё жёстче:

За столько лет развития алгоритмы научились лучше выявлять некачественный контент, не давая им даже шанса на ранжирование. Хотя иногда и попадаются неприятные сюрпризы в ТОПе, но они не будут там вечно.

Советы сайтам, пострадавшим от January 2020 core update

Хотя всё вышенаписанное — только теории, но они основаны на опыте команды аналитиков и исследовании сотни проигравших и выигравших сайтов.

Мэри советует:

- Прочитать внимательно инструкцию для асессоров Google, особенно примеры оценки качества, которые могут касаться конкретно ваших сайтов.

- Если у вас есть партнёрские ссылки, позаботьтесь, чтобы пользователь действительно видел и знал, куда перейдёт. Дисклеймера вверху или внизу недостаточно.

- Если у вас много рекламы, то уберите хотя бы блоки, которые вытесняют полезный контент из первого экрана.

- Проанализируйте экспертность и подачу контента конкурентов, которые выиграли от апдейта.

- Посмотрите на сигналы трастовости, которые важнее всего в вашей нише.

- Если у вас медицинский сайт, обратите внимание на то, что ваш контент может расходиться с общепринятыми научными нормами.

- Попытайтесь ответить на вопросы, которые Google рекомендует в своём блоге после каждого апдейта.

Еще по теме:

- Как можно отследить ранжирование сайта по информационным запросам? Вы как-то отслеживаете ранжируется ли ваш коммерческий сайт по инфо-запросам или нет? Нужно ли по всем статьям позиции отслеживать, если как минимум 1-3 статьи в...

- Чего хотят пользователи? Настройка и анализ отчета «Поиск по сайту» Около 30% потенциальных клиентов используют поиск по сайту, и это отличная возможность проанализировать их поведение и дать им то, что они хотят. Как это сделать?...

- Что делать, если резко просел трафик с Яндекса? Пошаговая инструкция по диагностике причин Прежде всего, важно правильно определить тип просевшего трафика, после чего можем перейти к анализу причин его падения. Что делать дальше и в каком случае –...

- Стоит ли бороться за попадание в блок с ответами в Google Поиске? Что вы должны знать о быстрых ответах Google a. Виды блоков с ответами b. Достоинства и недостатки c. Как запретить поисковику добавлять фрагменты сайта в...

- Асессорская инструкция Google: критерии оценки качества страниц (Часть 1) Основываясь на инструкции для асессоров Google, англоязычная версия которой недавно просочилась в сеть, мы проанализировали критерии, по которым поисковая система оценивает сайты. Наш авторский перевод...

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

(6 оценок, среднее: 4,67 из 5)

(6 оценок, среднее: 4,67 из 5)

Спасибо за грамотное изложение, а не тупой перевод 🙂

Но Мэри, похоже, лукавит. Люди приводят пачки примеров, где сайты попали под раздачу в сентябре или июне, с ними не делалось вообще ничего — и в январе Гугл их амнистировал. Тоже самое с сайтами, где люди вылизывали все YMYL / E-A-T факторы до мелочей — хренак, и и в январе Гугл наказал. Так что все эти гадания на кофейной гуще — самообман и самопиар, не более того. Особенно учитывая, что прямо сейчас в Гугле идёт очередной (уже февральский) откат январского апдейта. Его уже успели прозвать

. А если по-русски — РАНДОМ 🙂

Вот если бы кто-то попытался ссылочное проанализировать у фаворитоваутсайдеров — было бы куда полезней.

Спасибо за развёрнутый комментарий!

Да, в действительно пока идёт апдейт, то сложно сказать о реальных факторах. Думаю, немного позже появятся первые крупные исследования.

Можно конечно надеяться только на рандом, но мне кажется, лучше потихоньку улучшать всё, что можете 🙂

А если проседает, то успокоиться и подождать следующего обновления. Ну или стопроцентный вариант — развивать бренд.