- Ирина Ш.

- 25 минут

- Полезные подборки

Мы постоянно следим за новостями SEO-индустрии и каждую пятницу публикуем несколько самых важных в нашем facebook и twitter.

В этой статье мы собрали новости с января 2019 года, но уместить их все в хронологическом порядке невозможно, так что информация разбита на тематические блоки, из которых вы можете судить о трендах маркетинга и развитии поисковиков.

1. Яндекс

1.1. Штрафы за навязчивый push, небезопасный протокол и рекламу

В январе Яндекс решил штрафовать сайты за навязчивые push-уведомления. Они теряют позиции в выдаче и получают специальную пометку. Узнать о том, что сайт попал под санкции за рассылку таких уведомлений, можно в Вебмастере.

Позже Яндекс ответил на самые частые вопросы о протоколе HTTPS, акцентировав на том, что https это сигнал безопасности и качества сайта, соответственно такие сайты лучше ранжируются во всех тематиках.

Также Яндекс начал тестировать разные значки для страниц с https, а затем внедрил пометку в виде замка. Но даётся она только в случае, если у сайта достаточно трафика на защищённых страницах. Проверить можно в Вебмастере: Качество сайта → Показатели качества.

Яндекс.Вебмастер вообще начал воспринимать HTTP-протокол как проблему и разослал оповещения сайтам, которые ещё не перешли на безопасный сертификат. В то же время появились другие оповещения о некорректной работе SSL-сертификата, например, если истёк срок действия.

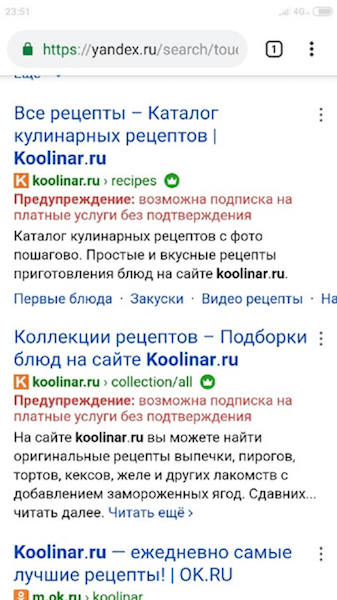

В апреле вебмастера ощутили волну автоматической пессимизации сайтов в Яндексе, виновником которой была мусорная реклама и перенаправление на платные подписки из блоков Adsense. В Вебмастере никаких уведомлений не было, но в выдаче такие сайты получали отпугивающую пометку.

Восстановление занимало месяц-полтора.

А в сентябре под фильтр «Малополезный контент, некорректная реклама, спам» попало ещё больше сайтов. В основном пострадали из-за рекламы (причём белой) молодые сайты с уникальным контентом и суточным трафиком до 3000, ИКС у них до 500. Подробный анализ есть тут. Единственные рекомендации в такой ситуации: убрать агрессивную рекламу и написать в поддержку Яндекса.

Также упомянем, что Яндекс создал робота для удаления пиратских страниц из выдачи. Он ищет страницы, похожие на те, что попали в реестр запрещённых сайтов.

1.2. Изменения алгоритма (ИКС, монополизация и неканонические страницы)

Яндекс решил чаще выводить в поиске неканонические страницы. Они будут показаны, если являются более релевантными запросу и их контент существенно отличается от канонической версии во время сканирования роботом. Сделали это для того, чтобы пользователи попадали на нужную страницу форумов или книг.

В середине августа выдачу Яндекса сильно потрепало. Согласно исследованию:

- сервисов Яндекса стало больше в ТОП-10 (иногда нерелевантных);

- изменилась весомость текстовых факторов (контент большого объёма стал ранжироваться хуже);

- в период обновления рандомизировалась выдача и менялась значимость поведенческих.

Подозреваем, что именно монополизацию выдачи Яндексом ощутили на себе многие.

Интересная ситуация произошла с крупнейшим онлайн-ритейлером Wildberries: он получил уведомление, что Яндекс сделал Маркет главным зеркалом, но всё быстро исправили.

В конце августа Яндекс изменил настройки подсчёта ИКС, чтобы он стал точнее отражать изменения на сайте (шаг округления стал меньше), а в ноябре вывел ИКС из бета-теста и обновил страницу «Показатели качества» в Вебмастере. Рекомендации теперь показываются, только если релевантны для Вашего сайта.

1.3. Турбо-страницы

Яндекс ещё в январе начал тестировать десктопные турбо-страницы, сначала для сайтов медицинской тематики, затем открыли бета-тест для остальных.

В Метрику был добавлен новый отчёт по турбо-страницам, а в главной Вебмастера — счётчик с их количеством. Также стала доступной функция выгрузки их списком из раздела «Источники Турбо-страниц» Вебмастера.

Немного позже в турбо-страницы были добавлены такие функции:

- Авторизация и комментарии.

- Отображение доменного имени.

- Новые форматы рекламы (соответствующей стандартам качества).

- Корзина.

- Настройки доставки.

- Листинги.

В десктопную выдачу был добавлен колдунщик турбо-страниц контентных сайтов.

Чуть позже Яндекс.Метрика начала автоматически создавать подробные отчёты по продажам для Турбо-страниц онлайн-магазинов. В отличие от целей, они, кроме факта конверсии, показывают:

- самые популярные товары, категории и бренды;

- товары, которые часто добавляют в корзину — но не покупают;

- средний доход на покупку и на визит;

- общий доход, доход в разбивке по каналам привлечения трафика и другую статистику.

Найти их можно в разделе «Электронная коммерция» → «Заказы».

1.4. Чаты для бизнеса

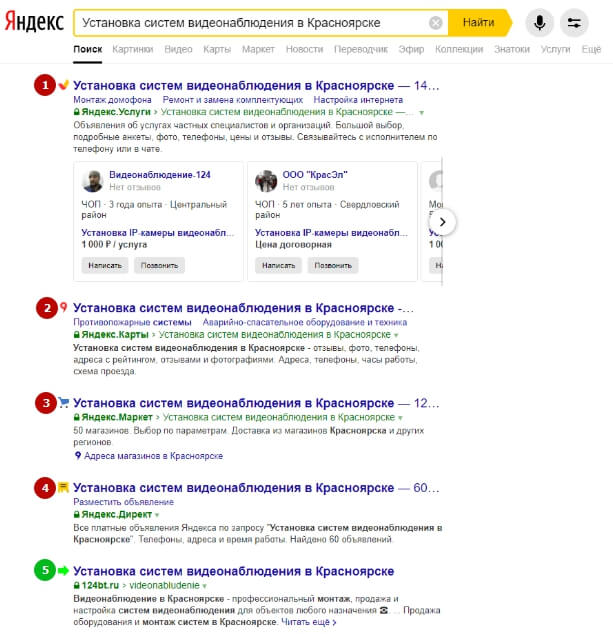

В январе Яндекс тестировал обновленное окно чата с организациями, в котором вопрос задавался сразу нескольким компаниям, но сейчас оно не встречается.

В рекламных блоках тоже появились чаты для бизнеса и цены.

Вскоре виджет с чатом Яндекс.Диалогов стало возможным добавлять прямо на сайт. Также Яндекс поделился статистикой использования Диалогов, самое интересное из неё вот что:

- 30% пользователей Яндекса как минимум один раз писали в чат для бизнеса;

- пользователи готовы ожидать ответа оператора не более 2 минут;

- быстрые и полезные ответы в чатах учитываются при ранжировании.

1.5. Новое в сервисах (Поиск, Вебмастер, Метрика, Справочник)

Яндекс некоторое время тестировал разные варианты блока для похожих запросов (как у Google), но пока не пришёл ни к одному окончательному варианту.

Из выдачи был удалён инструмент «Поиск по сайту», который располагался под поисковой строкой.

В Вебмастере недавно появился детальный отчёт по статистике запросов (показы, клики, CTR, позиции) по конкретным урлам. Он доступен в разделе «Поисковые запросы» → «Статистика страниц».

Яндекс.Метрика в честь 10-летия запустила интерактивный таймлайн, кликнув на который, можно узнать, что происходило в Метрике и в мире в разные годы. Также были обновлены значки в интерфейсе.

Специально для онлайн-медиа были добавлены новые отчёты по контенту, из которых (при наличии Schema) можно узнать доскроллы и дочитывания страницы и наблюдать в онлайн-режиме за статистикой просмотров популярных материалов. Чуть позже их дополнили новыми функциями:

- Постоянное автообновление.

- Анимированный список популярных статей.

- Быстрый поиск по статьям.

Чуть позже добавили поддержку JSON-LD и проверку разметки для отчётов по контенту.

Масштабное обновление претерпел Справочник. Теперь карточки организаций называются Яндекс.Профиль, и каждая из них располагается на отдельной странице с собственным URL, отображающимся в результатах поиска. В профиле можно создавать публикации и загружать прайс-листы с фотографиями и ценами.

Позже был введён бейдж с рейтингом и отзывами, который можно встроить на сайт, и материалы с QR-кодом, которые можно распечатать (визитки и пирамидки).

Также Яндекс.Справочник изменил правила расчёта рейтинга, так что оценки стали ранжироватся только внутри категории, к которой относится компания. То есть продуктовые магазины сравниваются только с другими продуктовыми магазинами, а не с ресторанами, интернет-магазинами или банками. Это позволит сделать оценку организации более прозрачной и наглядной для пользователей. Для появления рейтинга компания должна набрать несколько оценок пользователей (3-5 голосов достаточно).

2. Google

2.1. Борьба с дезинформацией

В январе представители компании заявили, что начата работа над устранением дыры, которая позволяет манипулировать выдачей через «панель знаний» и распространять таким образом фейки. Суть в том, что запрос в ссылке на граф знаний подменялся, и так в выдаче можно было, например, лицезреть панель Гомера Симпсона по запросу «король SEO».

В феврале Google выпустил документ «How Google Fights Disinformation», в котором описано определение недостоверной информации и принципы компании: учитывать качество как фактор ранжирования, противодействовать злоумышленникам и предоставлять пользователям больше контекста.

Если говорить более детально, то:

- Алгоритмы определяют полезность (правильность выдачи) с помощью тестирования на пользователях и ко всем сайтам относятся равно и справедливо, вне зависимости от взглядов самой команды Google.

- Алгоритмы не могут определить правду и ложь, а также замысел создателя контента, просто просканировав страницу. Но они могут определить спамное поведение и манипулятивные сигналы. Например, если сайт позиционирует себя как «Новости из Франции», но основная активность аккаунта указывает на США, поисковик подумает, что вы не до конца честны с пользователями.

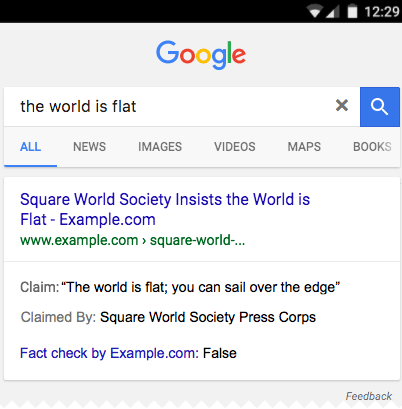

- У пользователей должен быть доступ ко всему контексту, чтобы они самостоятельно могли сформировать свои взгляды. Поэтому алгоритмы стараются давать разнообразную информацию в выдаче. Например, с помощью микроразметки ClaimReview вы можете показать пользователям, что в вашей статье проверяется какой-то факт, который вводил в заблуждение людей.

После трагических событий в США летом Google решил доработать алгоритм. По словам Панду Наяка (вице-президента поиска), поисковик научился распознавать, что случилось плохое событие и значительно увеличивать важность фактора «авторитетности» в такой критически важный момент.

2.2. Mobile-first и AMP

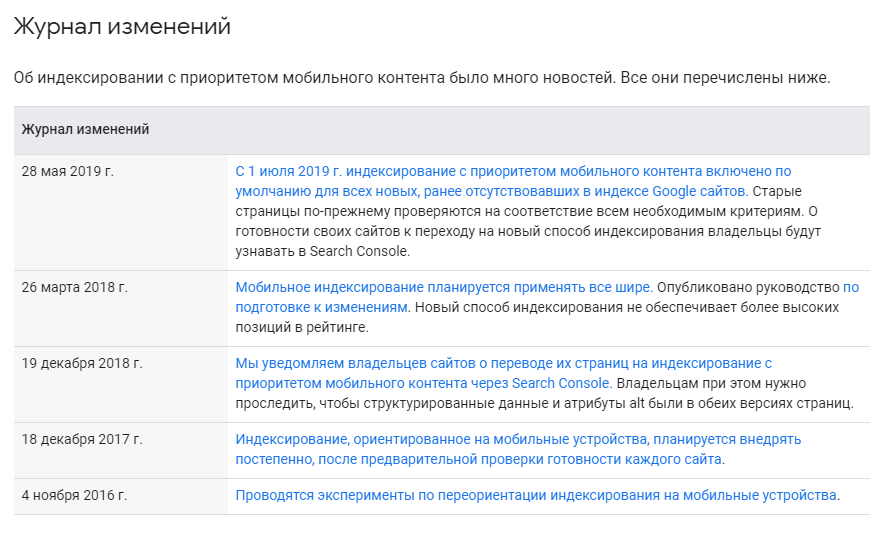

Зимой Google рассылал всем вебмастерам уведомления о переходе на mobile-first index. Переводили даже тех, у кого присутствовали некоторые ошибки в мобильной оптимизации. А с 1 июля mobile-first индексация включена по умолчанию для всех новых сайтов.

Источник

Если в GSC основным краулером отображается Googlebot smartphone, значит, сайт уже на mobile-fisrt. Также аннотация о переводе отображается в диаграмме.

Представитель Google Джон Мюллер, отвечая на вопросы вебмастеров на Reddit, настоял, что всем сайтам, которые ориентируются на мобильные, следовало бы перейти на адаптивный дизайн вместо отдельных урлов (поддоменов). Как его реализовать, мы писали в статье.

В отчёт инструмента Test My Site для тестирования скорости мобильных сайтов было добавлено больше данных. Теперь можно:

- узнать скорость загрузки всего сайта и отдельных страниц;

- базово сравнить показатели с конкурентами и со своим прошлым периодом;

- рассчитать потенциальную выгоду от увеличения скорости;

- получить советы по оптимизации 5 страниц.

Также Google добавил в инструмент для проверки оптимизации сайтов на мобильных устройствах (Mobile-Friendly Test и AMP Test) возможность проверки по коду, чтобы вебмастера могли найти и исправить ошибки на своих ресурсах ещё до публикации.

В апреле Google запустил новый сервис — Masterful Mobile Web, призванный показать на лучших примерах, как оптимизировать сайты для мобильных. Для анализа пока доступно 29 регионов и три категории: retail (торговля), finance (финансы), travel (путешествия).

В мае на конференции Google I/O 2019 объявили о будущих AR-функциях и 3D-объектах в результатах поиска. А в блоке Google News, кроме авторитетных статей, появятся хроника событий и аудиоподкасты.

Кроме этого, произошли такие обновления мобильной выдачи:

- У органики добавили фавикон (в заголовке должен быть тег ).

- У рекламы убрали серую полоску, а сам ярлык чёрный и без рамки.

- URL и хлебные крошки стали чёрными и переместились вверх.

Google взял вектор на AMP, добавив в выдачу и Search Console новый раздел — AMP Stories (это формат, похожий на Instagram Stories, но на них можно ссылаться, как и на любую веб-страницу, и они не исчезают). Позже AMP-страницы получили поддержку пользовательского JavaScript с помощью AMP-script.

Немного о тестах: в мобильном поиске США прямо под строкой поиска был доступен новый элемент «Your related activity», с помощью которого авторизованный пользователь мог посмотреть предыдущие запросы и посещённые страницы по той же теме. Также Google тестировал блок с ответами, в который подтягивались сразу несколько сайтов.

2.3. JavaScript SEO

Google опубликовал новое руководство по основам JavaScript SEO, авторами которого являются разработчик Мартин Сплитт и технический писатель Лиззи Харви.

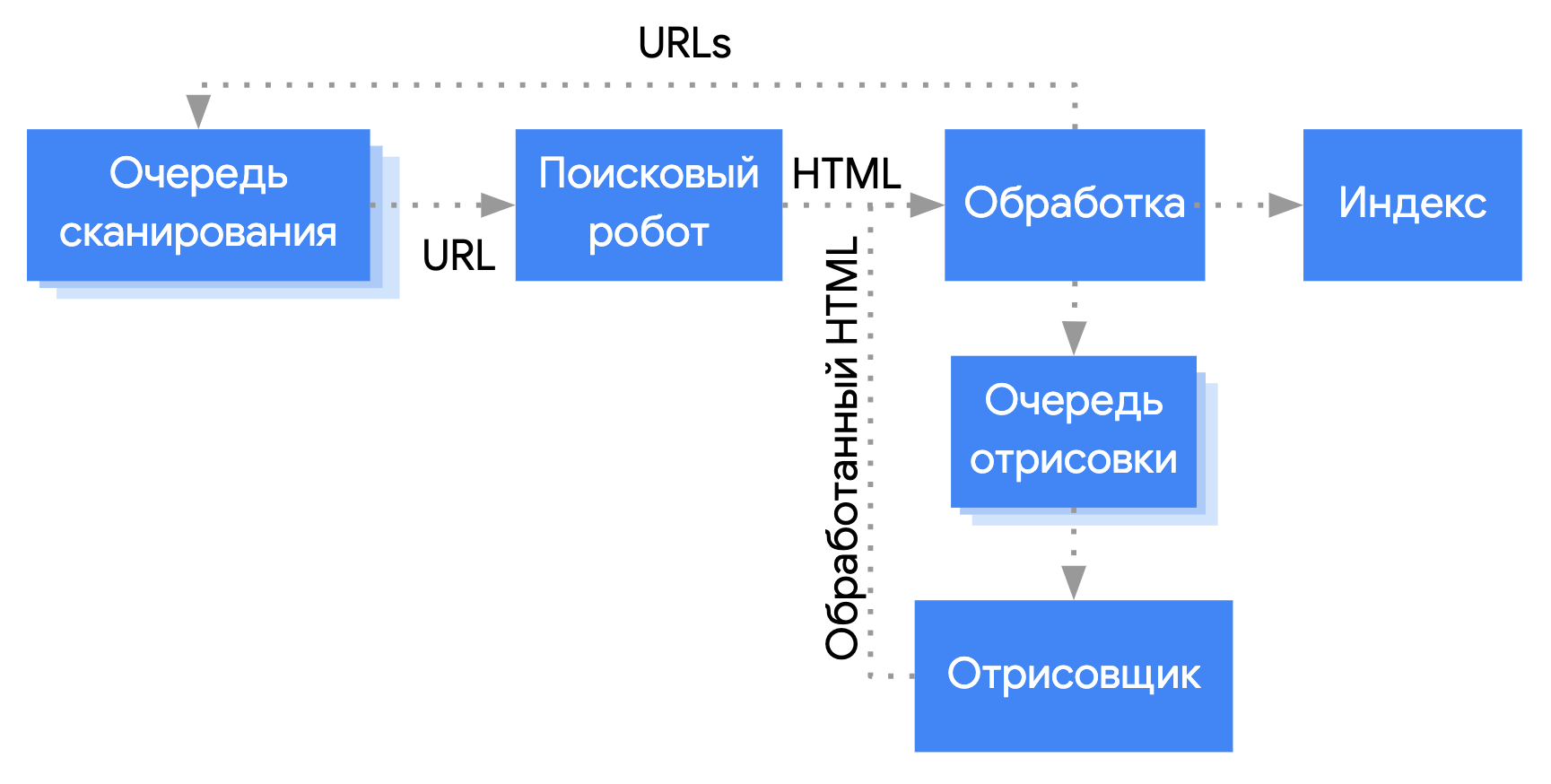

В гайде описывается процесс краулинга и обработки JavaScript-контента, а также даются рекомендации, как сделать его Google-friendly:

- Укажите информацию о своей странице с помощью уникальных заголовков и метаописаний: для их изменения можно использовать JavaScript.

- Создайте код, совместимый с роботом Googlebot: он может не поддерживать некоторые API и функции JavaScript. Руководство по устранению неполадок.

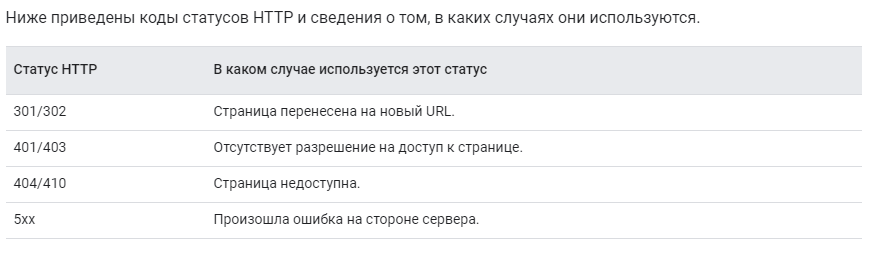

- Используйте понятные (стандартные) коды статусов HTTP: они сообщают боту, что страница переехала или не должна быть просканирована/проиндексирована.

- Используйте метатеги robots с осторожностью: это может работать не так, как вы ожидаете.

«При наличии атрибута noindex робот также не обрабатывает код JavaScript. Из-за этого удалить тег со страницы не получится. Попытка изменить или удалить метатег robots с помощью JavaScript может не привести к желаемым результатам».

- Реализуйте отложенную загрузку для обработки изображений, чтобы улучшить скорость загрузки сайта.

2.4. Новое в сервисах (Поиск, Search Console и Google Chrome и другое)

Google открыл регистрацию в доменной зоне .dev.

Соцсеть Google+ была закрыта и команда Google посоветовала удалить все связанные с ней элементы с сайтов.

В Google Chrome появился встроенный блокировщик навязчивой рекламы (по умолчанию выключен). Анонсирован ещё в январе, но стал доступен только через полгода.

Также в Google Chrome стало возможно переопределять геолокацию пользователя и задавать другое местоположение, чтобы протестировать, как сайт реагирует на пользователей из разных регионов. Для этого достаточно использовать новую функцию в Chrome DevTools.

Плюсом для пользователей станут две новые функции, призванные повысить безопасность использования браузера:

- Новое расширение Suspicious Site Reporter, позволяющее сообщать о подозрительных и вредоносных сайтах.

- Защита от тайпсквоттинга — уведомление о возможной ошибке, если адрес сайта похож на другой более известный сайт.

Googlebot обновлялся несколько раз. Весной было добавлено более 1000 новых функций и объявлено, что веб-краулер всегда будет работать на последней версии Chromium. 1 ноября Googlebot перевели на Chrome 78.

Также в новом Google Chrome и некоторых других браузерах автоматически убирается префикс www у доменов, названия компаний, EV-сертификат — они скрываются под значок замка.

Такие инструменты тестирования, как проверка URL в Search Console, проверка оптимизации для мобильных, проверка расширенных результатов, проверка AMP-страниц, тоже получили поддержку нового краулера и показывают максимально приближённый к его рендерингу результат.

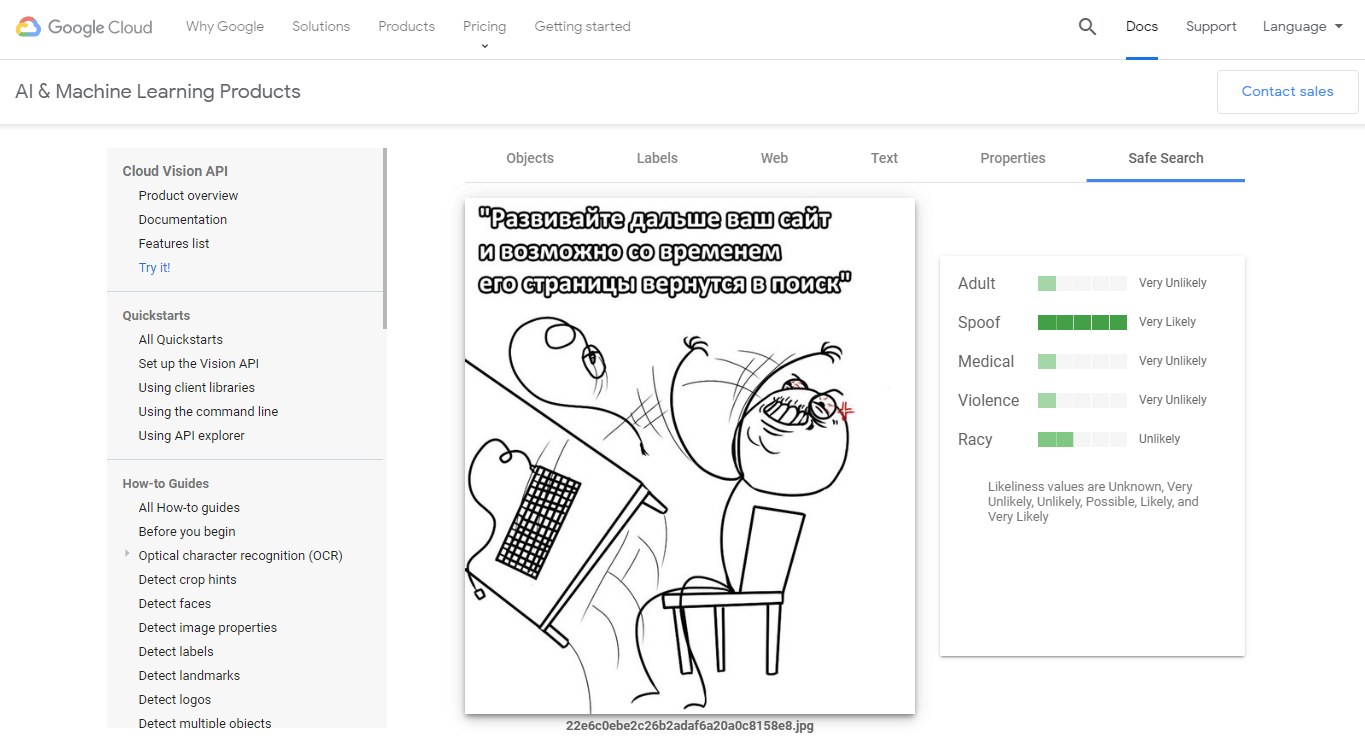

Запущен AI-инструмент для анализа изображений, он призван показать возможности Cloud Vision API — сервиса, который выполняет похожие функции, но его можно встроить в приложения и сайты.

Инструмент умеет распознавать объекты, класс изображения (чёрно-белое, мультяшное), текст, связанные понятия (например, имя автора рисунка), цветовую гамму и показывает ограничения с точки зрения небезопасного контента.

Google окончательно перешёл на новую Search Console и добавил её в выдачу так, что вебмастера могут увидеть основную статистику своего сайта под поисковой строкой. Некоторые функции были заменены, а некоторые и вовсе отключены.

Например, больше нельзя указывать основной домен прямо в GSC. Google стал ориентироваться на другие сигналы:

- атрибут rel= «canonical»;

- HTTP-заголовок rel= «canonical»;

- файл Sitemap;

- код статуса 301 для URL удалённых страниц.

В отчёте об эффективности стали подгружаться более свежие данные, они обновляются меньше, чем за сутки. Также стало возможным скачать данные за определённый период.

Сравнение инструментов старой и новой панели есть на официальном сайте.

Google вывел из беты поисковую функцию Top Places List (Список лучших мест), которая по запросу заведения подтягивает в результаты выдачи обзорные статьи со списком лучших мест, в которых оно упоминалось. Обычно такие статьи ориентированы на туристов и выглядят как «10 мест, которые вы обязаны посетить в городе N». Рекламные, оскорбительные или шаблонные SEO-статьи Google такой чести не удостоит. Функция использует алгоритмы машинного обучения и полностью автоматизирована.

Был добавлен новый оператор для поиска в Google по датам — команда «год-месяц-день». Например:

[avengers endgame before:2019]

[avengers endgame after:2019/04/01]

[avengers endgame after:2019-3-1 before:2019-3-5]

Если написать неполную дату, гугл её трансформирует так:

[before:2018] = [before:2018-01-01]

[after:2018] = [after:2018-12-31]

Но всё же дату, указанную в результате выдачи, следует воспринимать как оценку Google, а не как точное время публикации, так как поисковику бывает сложно определить её с точностью.

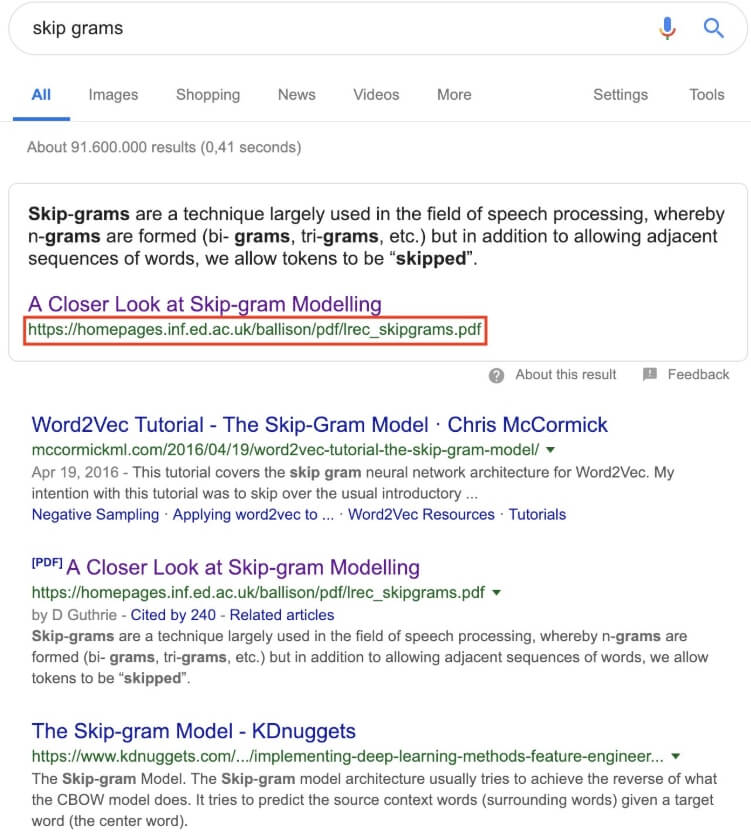

PDF-файлы стали попадать на нулевую позицию в выдаче, а в некоторых случаях — даже с расширенным сниппетом.

Источник

Началась экспансия агрегаторов, и представитель Google Джон Мюллер подтвердил, что:

«Синдицированный контент (материалы, копии которых размещаются на сторонних ресурсах) может обойти оригинал в ранжировании».

Google удалил документацию по разметке rel=prev/next, так как уже несколько лет не использует её для индексации. Сотрудник Google Илья Григорик прокомментировал это так:

«Googlebot достаточно умён, чтобы найти вашу следующую страницу с помощью внутренних ссылок, мы не нуждаемся в «prev, next» как явном сигнале, и да, есть и другие причины (например, стандарт доступности контента — a11y), из-за которых вы должны её использовать до сих пор».

Джон Мюллер признался, что входящие и исходящие ссылки (ваше место в ссылочном графе) это один из самых важных факторов в Google, но не для всех сайтов и запросов. Например, новости могут ранжироваться по другим сигналам.

Ещё одно подтверждение этому — тот факт, что Google использует входящие ссылки для определения релевантности страниц, заблокированных в robots.txt.

С 1 сентября Google перестал поддерживать директиву noindex в файле robots.txt.

В качестве альтернативы можно использовать:

- Noindex в метатегах robots.

- Коды ответа сервера 404 и 410.

- Disalow в robots.txt.

- Инструмент удаления URL в Search Console.

- Защиту паролем (если страница без разметки платного контента).

WordPress на это отреагировал, изменив способ запрета индексации на:

<meta name=’robots’ content=’noindex,nofollow’ />

В сентябре Google добавил новые атрибуты для ссылок, и теперь их можно помечать как:

- rel= «sponsored», если ссылка является частью рекламы, спонсорства или других соглашений;

- rel= «ugc» для User Generated Content (контент, генерируемый пользователями), например, комментариев или постов на форумах;

- rel= «nofollow», если хотите поставить ссылку, контент которой не поддерживаете (не хотите передавать ссылочный вес).

Все эти атрибуты Google будет обрабатывать как подсказки о том, какие ссылки следует учитывать или исключать из поиска. Почему только подсказки, а не директиву? Чтобы учиться лучше выявлять признаки искусственных ссылок и понимать связь контента донора и акцептора.

Западные SEO-эксперты протестировали влияние нового атрибута ссылок rel= «ugc» на ранжирование: его применили к половине комментариев в блоге MOZ, но никакого сдвига в показателях не наблюдалось. То есть пока добавление атрибута бесполезно.

Несколько советов:

- Менять существующие nofollow на другие атрибуты не нужно.

- Можно использовать больше одного rel в ссылке, например, rel= «ugc sponsored» для рекламной ссылки на форуме или rel= «nofollow ugc», если хотите, чтобы ссылка была совместима с сервисами, которые ещё не поддерживают новые атрибуты.

- Если обозначить ссылку неправильным атрибутом, ничего страшного не произойдёт, если только она не рекламная: такие должны быть sponsored или nofollow.

Nofollow перейдёт из директивы в рекомендацию 1 марта 2020 года.

2.5. Микроразметка

Довольно сильный упор Google сделал на микроразметку, добавив новые отчёты в GSC (логотип, окно поиска по сайту, статус хлебных крошек), сообщения об ошибках (структурированные данные, которые невозможно обработать) и запустив новые типы:

- FAQ предназначен только для официальных ответов.

- Q&A для форумов или вопросников.

- Разметка для фильмов.

- В микроразметку how-to были добавлены изменения, а вывод разметки рейтинга (звёзды) был ограничен некоторыми схемами, чтобы избежать манипуляций вебмастеров.

В инструменте «Проверка расширенных результатов» стал доступен предпросмотр изменений при редактировании кода и возможность проверки отдельно для десктопа и мобильных.

Чуть позже представитель Google Джон Мюллер подтвердил, что поисковик использует микроразметку не только для расширенных сниппетов, но и чтобы лучше понимать смысл страницы. И хоть это не фактор ранжирования, который приведёт больше трафика, но всё-таки способ показывать вашу страницу более целевой аудитории.

2.6. March 2019 Core Update+

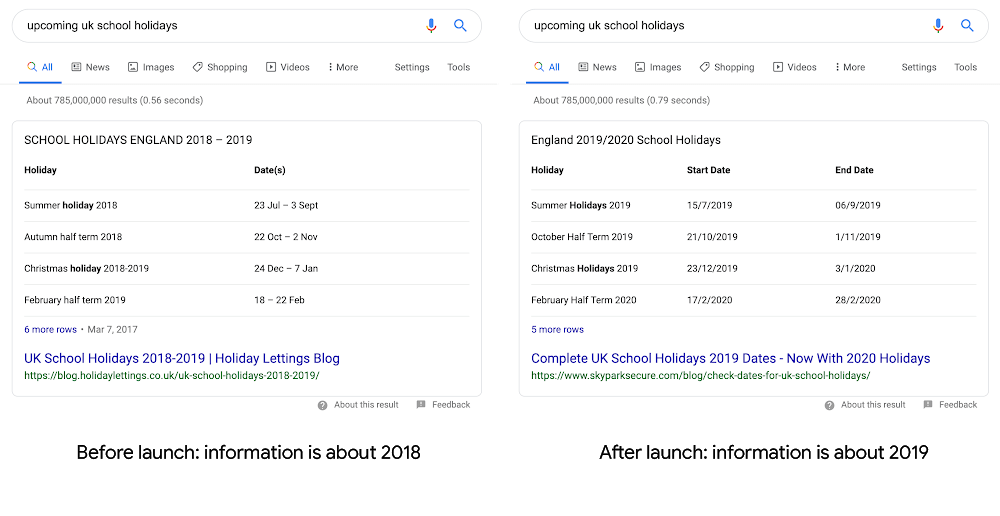

Ещё в феврале Google доработал алгоритм, чтобы сделать быстрые ответы (featured snippets) более актуальными: он стал лучше понимать, какой контент быстро устаревает, а какой остаётся «вечнозелёным».

Например, расписания праздников, обзоры лучших товаров, расписание выхода сериалов по умолчанию будут выводиться на текущий/будущий год.

Крупный мартовский апдейт (алгоритм Florida-2) обратил внимание всех вебмастеров на факторы Е-А-Т (Экспертность, Авторитетность, Надёжность). Основными рекомендациями по восстановлению для пострадавших сайтов стали:

- Добавление авторов контента или контактных данных, поддержки (для коммерческих страниц), страниц «о нас».

- Удаление/оптимизация страниц с некачественным контентом, например: короткие тексты, контент без особой ценности, страницы с плохим ссылочным, со спамной перелинковкой, дублированный контент. В принципе, рекомендации к ним такие же, как и для Яндекса.

- Переход на безопасный SSL-серфитикат.

Плюсом также будет увеличение скорости загрузки: сжатие файлов и изображений, оптимизация кода (например, с помощью html5), улучшение скорости ответа сервера (можно использовать http-заголовки), оптимизация краулингового бюджета. Тем более что в Google Chrome могут появиться отметки для медленных и быстрых сайтов.

Плюс недавно Google запустил новый экспериментальный отчёт о скорости загрузки в Search Console. Он автоматически группирует страницы сайта по скорости загрузки (высокой, средней и низкой) и проблемам, чтобы Вы смогли расставить приоритеты в оптимизации. В отчёте есть ссылка на инструмент Page Speed Insight, который подскажет, что именно нужно исправить.

2.7. June 2019 Core Update + Diversity Update

В июне Google всего за 5 дней выкатил обновление основного алгоритма, призванное разнообразить выдачу. Параллельно с этим внедрялись изменения в алгоритм, призванные обеспечить большее разнообразие доменов в SERP, после них Google перестал показывать один домен на больше чем двух позициях одновременно по запросу.

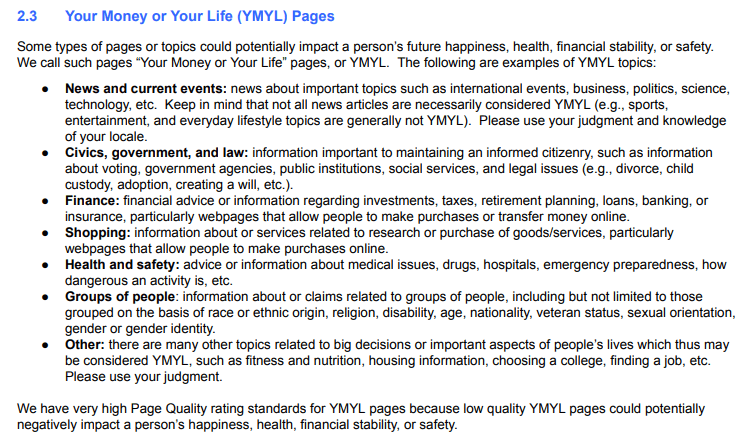

Обновления прошлись по многим сайтам, но больше всего затронуло YMYL (например, тематики «гемблинг», «здоровье», «еда и продукты питания» и «финансы»), СМИ, интернет-магазины.

Джон Мюллер посоветовал таким сайтам обратить внимание на три вопроса:

- Выглядит ли сайт устаревшим?

- Могут ли читатели узнать, кто автор контента?

- Фото авторов реальны или взяты с фотостоков?

Также он упомянул гайд на 23 вопроса по качеству сайта, который публиковался ещё во времена Панды. Перевод можно почитать в блоге Деваки.

Чуть позже Google в своём блоге для вебмастеров выпустил официальные рекомендации, которые, возможно, помогут успокоиться и восстановить трафик после обновлений основного алгоритма. Из них следует, что «нет ничего неправильного в страницах, которые начинают ранжироваться хуже после крупных апдейтов». Это не санкции и не нарушение руководства для вебмастеров, это изменение системы оценивания контента алгоритмами в целом. При этом ранее недооценённые сайты могут выйти на первые позиции.

Для лучшего понимания Google привёл сравнение с обновляемым списком лучших фильмов, который изменяется не потому, что старые фильмы стали хуже, а потому, что появились новые достойные.

В посте также перечисляются вопросы по контенту, экспертизе и сравнению ценности. Их перевод есть у SEOnews.

В середине июля Google обновил алгоритм, чтобы показывать меньше порнографического контента в спорных случаях (например, по запросу [школьница]). Если у фразы есть несколько интерпретаций, то приоритет стал отдаваться более культурной.

2.8. September 2019 Core Update+

В сентябре многие вебмастера жаловались на слишком резкое изменение позиций. Больше всего пострадали сайты с YMYL-контентом.

Совпадение или нет, но в то же время (май и сентябрь) дважды было обновлено руководство для асессоров:

- Добавили пункт про межстраничные объявления в раздел про отвлекающую рекламу.

- В FAQ добавили пункт об экспертизе и обозначили, что развлекательным сайтам не нужно давать низкую оценку только за то, что они не несут практической пользы.

- Добавили фактор E-A-T в некоторые пункты, привели больше примеров страниц очень высокого качества и признали видео источником контента.

- В разделе про YMYL-контент:

- Добавили примеры новостей, которые не относятся к YMYL.

- Разделили «Shopping» и «Finance», информацию о товарах или услугах, связанную с исследованием или покупкой товаров/услуг (например, отзывы), отнесли к YMYL.

- Добавили раздел «Groups of people».

- Стало важным указание создателя контента (он из команды ресурса или приглашённый эксперт).

- Сайты с лицензированным или синдицированным контентом теперь за него отвечают так же, как и создатели.

Краткий обзор обновлений можно посмотреть здесь.

Полезные ссылки:

В октябре Google представил новый самообучающийся алгоритм BERT, созданный чтобы лучше понимать длинные запросы (обычно это НЧ) и воспринимать их как целостную смысловую часть, а не разбивать на слова и обрабатывать каждое отдельно. Пока он влияет на 10% англоязычных запросов, но планирует развернуться на другие языки. Подробнее о нём в обзорной статье.

Джон Мюллер посоветовал пострадавшим сфокусироваться на релевантности, а не на BERT и технических факторах, так как это обновление наложилось на несколько других. Также сказал, что улучшение юзабилити и скорости загрузки всегда идут в плюс.

Законы и документы

Ещё в феврале Еврокомиссия опубликовала правила, согласно которым поисковики (Google, Bing) и торговые площадки (Amazon, eBay, Google Shopping) обязаны будут раскрыть свои основные параметры ранжирования. Они вступают в силу спустя 12 месяцев после публикации (февраль 2020) и могут пересматриваться в течение ещё 18 месяцев, чтобы удостовериться, что они работают в рамках меняющегося рынка.

Роскомнадзор несколько раз штрафовал Google за наличие в выдаче ссылок на запрещённые сайты, а затем обвинил в манипуляциях политической рекламой. Поисковику пришлось ужесточить фильтрацию запрещённых сайтов и урезать возможности таргетинга политической рекламы в своих сервисах.

Также напомним, что 18 марта в России вступил в силу закон о фейковых новостях, а в октябре уже назначили первый штраф по нему. Юр. и физ. лиц после предупреждения будут штрафовать, а их страницы блокировать, если они публиковали фейковую социально значимую информацию, которая способна навредить. Основные вопросы, связанные с этим законом, удачно раскрыты в Т—Ж.

А с 1 ноября запущен закон об автономности Рунета. Роскомнадзор возьмёт на себя управление трафиком в случаях возникновения таких угроз, как:

- Угроза целостности – невозможность установить соединение между пользователями.

- Угроза устойчивости – нарушение работы сети при поломке части оборудования, природных и техногенных катастрофах.

- Угроза безопасности – попытки взломать оборудование провайдера или дестабилизировать сети связи.

В Украине бурно обсуждали новый закон о языке, из-за которого сайты и соцсети предприятий, зарегистрированных в стране, должны по умолчанию вестись на украинском языке.

4. Выводы

Сейчас поисковики сконцентрированы на оптимизации под мобильные, новых собственных сервисах в выдаче и опыте для пользователя. Хакерские атаки и законы заставляют их обращать больше внимания на безопасность как фактор ранжирования и штрафовать сайты за некачественную рекламу.

Всё же темой этого года можно назвать борьбу за качественный и достоверный контент, которая выражается в ужесточении оценки YMYL-сайтов и работе над рейтингом.

А какая новость стала самой значимой для вас? Пишите в комментарии.

Хотите, чтобы Ваш сайт продвигали профессионалы? Обращайтесь к нам!

Еще по теме:

- 3 шага в Яндекс.Метрике: ищем источник падения трафика Часто вебмастера сразу начинают менять все на сайте, хотя причиной падения трафика могли стать пару запросов на одну конкретную страницу. Поэтому не нужно спешить, а...

- Supervised Nested PageRank Мы подготовили для вас перевод доклада Яндекса о его новой разработке SupervisedNestedPageRank. Тем, у кого нет научной степени по математике, понять его будет довольно-таки сложно....

- SEO-гайд для новичков: анализ просадки позиций в Яндексе Порой падение позиций в Яндексе бывает резким, а иногда просадка происходит медленно, но верно. В этой статье мы расскажем, как по характеру просадки позиций выявить...

- История алгоритмов Яндекса Хроника изменений Яндекса - мы отследили, как менялись алгоритмы и фильтры поисковой системы за последние 12 лет. По мере появления нововведений материал дополняется. 7 апреля 2017 –...

- Как определить просадку трафика в Яндексе – пошаговая инструкция Определяем поисковую систему, в которой произошла просадка Выясняем дату просадки и равнозначные периоды Определяем просевшие страницы в Яндексе Анализируем полученные данные Определяем просевшие запросы Как...

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

Привет! Скажите, вот Гугл рекомендует установить плагин AMP для мобильных страниц, у Яндекса турбо-страницы, как они между собой будут взаимодействовать, будут конфликты? Или можно установить и AMP и турбо-страницы?

Добрый день!

Яндекс.Турбо и AMP-страницы не мешают друг-другу. Они не заменяют оригинальные страницы сайта. Это дополнительная ускоренная версия, которая находится на серверах ПС: AMP — на серверах Google, а Турбо — Яндекса. По факту, они существуют только в рамках своей поисковой системы. Яндекс не видит AMP, Google — видит только Турбо-страницы Яндекс.Директа, созданные в конструкторе.

Вы можете установить и AMP, и Турбо-страницы одновременно.

Отличная статья! Разобрано все детально и с примерами!